catalogue de données moderne catalogue de données gouvernance d'entreprise gouvernance la conformité

Selon Gartner, la mauvaise qualité des données coûte en moyenne 12,9 millions de dollars par an aux entreprises, tandis que une étude d'IBM de 2025 montrent que les entreprises mettent en moyenne 258 jours pour identifier et contenir une violation de données. Ces statistiques révèlent une vérité fondamentale : gouvernance ne gouvernance plus être une réflexion après coup ou un processus manuel ; elle doit être automatisée, centralisée et Embarqué les opérations de données.

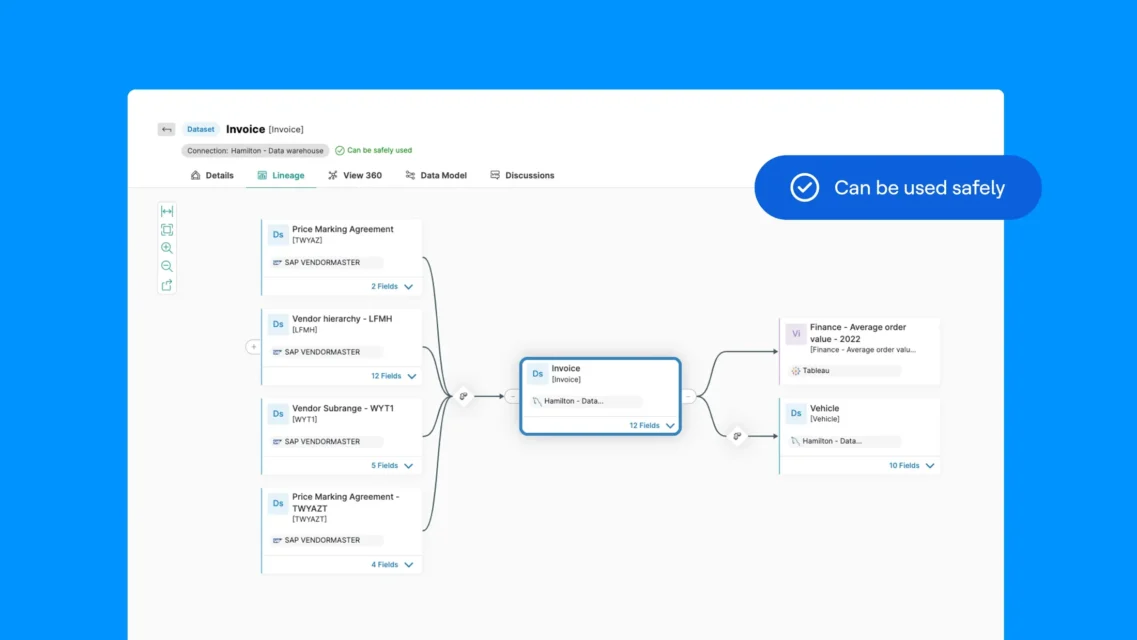

Un catalogue de données un métadonnées centralisé métadonnées qui aide les organisations à découvrir, comprendre et gérer leurs données. Au sein d'une plateforme d'intelligence des données, le catalogue de données la base contextuelle et de découverte qui relie métadonnées, la traçabilité, gouvernance et observabilité l'entreprise. Il offre des fonctionnalités automatisées de découverte, de traçabilité, de classification et d'application des politiques, afin que les équipes puissent rapidement trouver des données fiables et les utiliser de manière responsable.

Un catalogue de données moderne, avec découverte automatisée, métadonnées centralisées et application des politiques, transforme gouvernance fragmentée et risquée des données gouvernance libre-service proactif et fiable qui améliore la conformité, la qualité et prise de décision. Il représente le passage d'une gestion réactive à gestion des données stratégique gestion des données, permettant aux organisations de gouverner à grande échelle tout en accélérant l'analyse et l'innovation.

Les catalogues de données d'entreprise nécessitent plus qu'une simple fonction de recherche et d'inventaire. Fonctionnalités essentielles Fonctionnalités métadonnées automatisée métadonnées , l'alignement intégré du glossaire métier, la traçabilité de bout en bout, les contrôles d'accès basés sur les rôles, l'application des politiques et observabilité de qualité et observabilité des données. Lorsqu'elles sont fournies dans le cadre d'une plateforme d'intelligence des données, ces Fonctionnalités la disponibilité de données fiables et gouvernées là où l'analyse et l'IA sont réellement utilisées.

Qu'est-ce qu'un catalogue de données?

Un catalogue de données un système centralisé qui répertorie, organise et enrichit métadonnées les utilisateurs puissent découvrir, comprendre, approuver et gérer les données au sein d'une organisation. Les catalogues de données modernes automatisent métadonnées , suivent leur provenance, appliquent gouvernance et affichent des indicateurs de qualité et de fiabilité afin de support , la conformité et les initiatives d'IA.

Principaux avantages d'un catalogue de données

Les catalogues de données modernes offrent des avantages transformateurs en matière de gouvernance, de conformité et d'efficacité opérationnelle.

- Centralise métadonnées toutes les sources dans un dépôt unique et consultable, éliminant ainsi les silos de données.

- Améliore la qualité et la fiabilité des données grâce à une surveillance, une validation et une évaluation de la qualité continues.

- Automatise la classification et l'application des politiques, garantissant ainsi un traitement cohérent des données sensibles.

- Accélère l'analyse et libre-service , en rendant les données fiables accessibles en quelques minutes, et non plus en plusieurs semaines.

- Renforce la conformité avec le RGPD, la loi HIPAA et les réglementations du secteur.

- Fournit une traçabilité pour comprendre l'origine, les transformations et l'utilisation des données dans l'ensemble de l'écosystème.

- Réduit les risques opérationnels et gouvernance manuelles gouvernance , ce qui permet aux équipes de se concentrer sur les initiatives stratégiques.

- Permet la démocratisation des données tout en maintenant la sécurité et le contrôle grâce à un accès basé sur les rôles.

- Accélère les initiatives en matière d'IA et d'apprentissage automatique en fournissant apprentissage fiables et bien documentées.

- Améliore la collaboration entre les équipes techniques et commerciales grâce à une compréhension commune.

Comprendre gouvernance principaux gouvernance des données

La gouvernance données est l'ensemble des politiques, des rôles et des processus qui garantissent que les données sont disponibles, utilisables, exactes et sécurisées dans l'ensemble de l'entreprise. Au fur et à mesure que les organisations ingèrent de plus en plus de données provenant de sources diverses, la gouvernance devient de plus en plus difficile et importante.

Les principaux défis comprennent la fragmentation métadonnées des systèmes déconnectés, ce qui crée des vues incohérentes et rend gouvernance à l'échelle de l'entreprise. Les silos de données persistent parce que les systèmes départementaux ne communiquent pas entre eux, ce qui entraîne la duplication des données et crée des cauchemars en matière de contrôle des versions. L'incohérence de la terminologie commerciale signifie qu'un même concept peut avoir des noms différents selon les équipes, comme « client » ou « consommateur », tandis que des concepts différents partagent le même nom, ce qui entraîne confusion et erreurs.

Les processus manuels de conformité restent lents et sujets aux erreurs. Les inventaires de données basés sur des tableurs deviennent immédiatement obsolètes. Les examens d'accès ont lieu tous les trimestres ou tous les ans, laissant des autorisations inappropriées en place pendant des mois. La classification repose sur un marquage manuel qui passe à côté de données sensibles ou applique des étiquettes de manière incohérente. La préparation des audits nécessite des semaines de collecte manuelle de preuves.

Le manque de visibilité est un véritable fléau pour les organisations : les équipes ne parviennent pas à trouver jeux de données existent déjà, ce qui entraîne une duplication du travail et un gaspillage des ressources. Elles ne peuvent pas évaluer la qualité sans connaissances tribales ou sans mener une enquête fastidieuse. Elles ne peuvent pas retracer la lignée pour comprendre d'où proviennent les données ou ce qui en dépend, ce qui rend l'analyse d'impact impossible et l'enquête sur les causes profondes extrêmement lente.

Sans une propriété et une gestion claires, la qualité des données se détériore, car personne n'assume la responsabilité de leur exactitude, de leur exhaustivité ou de leur actualité. La confiance s'érode lorsque les utilisateurs sont confrontés à des problèmes de qualité à plusieurs reprises, et ils cessent d'utiliser les sources de données officielles au profit d'alternatives non contrôlées.

Les conséquences vont au-delà de l'inefficacité : amendes réglementaires, incidents de sécurité et blocage des initiatives d'analyse ou d'IA. Les organisations qui tentent de développer l'IA constatent que le développement de modèles est paralysé sans apprentissage fiables et bien documentées. Pour développer libre-service fiable libre-service devenir axées sur les données, les organisations ont besoin gouvernance automatisée, centralisée et intégrée dans les flux de travail quotidiens.

Automatiser la découverte de données et métadonnées Collection

La découverte automatisée analyse en permanence les bases de données, les fichiers, le stockage cloud et les applications afin d'identifier les ressources de données, éliminant ainsi les inventaires manuels et garantissant une couverture complète. Les outils de découverte modernes détectent les emplacements sources, les schémas, les relations et les modèles d'utilisation, améliorant ainsi la précision au fil du temps grâce à l'apprentissage automatique.

métadonnées automatisée métadonnées permet d'extraire des informations bien plus riches que ne le permettrait jamais une documentation manuelle. métadonnées techniques métadonnées les détails du schéma, les types de données, la nullabilité, l'unicité, la cardinalité et les profils statistiques indiquant les distributions de valeurs et les indicateurs de qualité. métadonnées métier métadonnées l'objectif, la propriété, les scores de qualité et les directives d'utilisation. métadonnées opérationnelles métadonnées les modèles d'accès, requête , les calendriers de rafraîchissement des données et la lignée indiquant les transformations.

Ces processus automatisés permettent de synchroniser le catalogue avec la réalité. Lorsque les développeurs déploient des modifications de schéma via des pipelines CI/CD, la découverte les détecte en quelques heures. Lorsque de nouvelles sources de données sont mises en ligne, elles apparaissent automatiquement dans le catalogue. Lorsque jeux de données mis hors service, le catalogue reflète leur suppression. Cette synchronisation empêche le catalogue de devenir un autre système de documentation obsolète que les équipes ignorent.

L'automatisation réduit considérablement les délais d'intégration des nouvelles sources (de plusieurs semaines ou mois à quelques heures ou jours), ce qui permet de démarrer plus rapidement les projets d'analyse. Parallèlement, gouvernance et les contrôles d'accès s'appliquent dès l'ingestion.

Créer un catalogue de données centralisé et complet

catalogue de données centralisé catalogue de données et organise toutes catalogue de données dans une interface unique permettant d'effectuer des recherches, éliminant ainsi les silos et créant une source unique de vérité. Cette consolidation offre des avantages pratiques immédiats. Les utilisateurs passent quelques minutes à trouver jeux de données passer des jours à demander autour d'eux. Les doublons diminuent considérablement lorsque les équipes peuvent voir ce qui existe déjà. gouvernance s'appliquent de manière uniforme, car il existe un seul endroit où les définir et les appliquer. La préparation des audits s'accélère, car toutes les preuves se trouvent dans un seul système avec une journalisation complète.

Recherche et découverte Fonctionnalités: Les catalogues modernes offrent plusieurs modèles de recherche pour répondre utilisateur différents utilisateur . La recherche par mot-clé permet d'effectuer des recherches rapides par nom ou par description. La recherche sémantique comprend les concepts commerciaux et trouve jeux de données « revenus » jeux de données les utilisateurs recherchent « ventes ». La recherche à facettes permet de filtrer par système source, domaine de données, propriétaire, classification, score de qualité ou actualité. Les utilisateurs peuvent parcourir les taxonomies et les hiérarchies, ou suivre les recommandations basées sur leur rôle et leurs habitudes d'utilisation passées.

Indicateurs de qualité et de fiabilité des données: Chaque jeu de données des mesures de qualité calculées à partir de règles de profilage et de validation : pourcentages d'exhaustivité, scores de précision, indicateurs de pertinence et cohérence . utilisateur et commentaires utilisateur fournissent des informations qualitatives. Les statistiques d'utilisation indiquent la popularité :jeux de données utilisés par les analystes seniors sont souvent plus fiables que les ressources rarement consultées. Les badges de certification indiquent qu'ils ont fait l'objet d'un examen et d'une approbation formels par les administrateurs.

Analyse de l'utilisation: Le catalogue permet de savoir qui accède jeux de données, quand et dans quel but. Cette visibilité permet de mettre en évidence data products populaires data products un investissement supplémentaire, d'identifier les actifs sous-utilisés qui pourraient être archivés et d'aider les gestionnaires à comprendre l'impact de leurs données. L'analyse permet également de détecter les modèles d'accès inhabituels qui pourraient indiquer des problèmes de sécurité ou des violations de la politique.

Fonctionnalités collaboratives: Les utilisateurs peuvent commenter jeux de données, poser des questions ou partager leurs idées. Ils peuvent évaluer la qualité des données en fonction de leur expérience. Les gestionnaires peuvent joindre des exemples d'utilisation illustrant des requêtes courantes ou des modèles d'analyse. Les fils de discussion autour des ressources de données créent une base de connaissances institutionnelles qui, autrement, se trouverait dans des canaux Slack ou des fils de discussion par e-mail, ce qui rendrait leur recherche difficile par la suite.

Contexte commercial et normalisation: La centralisation impose un langage commercial cohérent grâce à des définitions, des classifications et des glossaires normalisés. Lorsque le terme « client » a une définition officielle liée à chaque jeu de données des données clients, la confusion entre les services disparaît. Les équipes s'alignent sur la terminologie, ce qui réduit les malentendus qui conduisent à des analyses incorrectes ou à des doublons dans le travail.

Les catalogues modernes contiennent des métadonnées techniques et commerciales, des exemples d'utilisation et des évaluations de la qualité afin que les utilisateurs comprennent ce que signifient les données, comment elles sont produites, quelle est leur fiabilité et quels sont les cas d'utilisation et les limites appropriés.

Analyse de l'impact et de l'évolution des données

La visualisation de la traçabilité des données représente l'une desFonctionnalités gouvernance les plus puissantes, montrant comment les données circulent depuis les systèmes sources jusqu'aux points de consommation finaux, en passant par les transformations, les intégrations et les analyses. Une traçabilité complète répond à des questions essentielles auxquelles la documentation manuelle peine à répondre : d'où vient cette valeur ? Quelles transformations ont été appliquées ? Quels rapports et modèles dépendent de cet jeu de données? Si je modifie ce tableau, qu'est-ce qui sera perturbé en aval ?

Visualisation du flux de bout en bout: Les catalogues modernes construisent des graphiques de lignage complets couvrant l'ensemble du patrimoine de données. Cette visibilité s'étend aux technologies et plateformes, montrant le lignage même lorsque les données traversent les frontières du système.

Lignée au niveau des colonnes: Pour la conformité réglementaire et l'analyse d'impact approfondie, la traçabilité au niveau des tables n'est souvent pas suffisante. La traçabilité au niveau des colonnes suit les champs individuels tout au long des transformations, montrant que le « revenu annuel » dans un rapport provient en fin de compte du « total des ventes » dans le système source après conversion monétaire et agrégation. Cette granularité s'avère essentielle pour les réglementations en matière de confidentialité qui exigent la documentation du flux des données personnelles à travers les systèmes, ainsi que pour les enquêtes de qualité qui nécessitent une identification précise des causes profondes.

Analyse des causes profondes des problèmes de qualité: Lorsque des problèmes de qualité des données surviennent, la traçabilité permet une investigation rapide. Si un tableau de bord des valeurs incorrectes, les équipes remontent la traçabilité en amont à travers les transformations afin d'identifier où les erreurs ont été introduites. S'agissait-il de données sources erronées ? D'une erreur logique dans le code de transformation ? D'une valeur nulle inattendue qui a perturbé les calculs ? La traçabilité réduit le temps d'investigation de plusieurs jours à quelques heures en fournissant une feuille de route menant directement au problème.

gouvernance du modèle ML: À mesure que les organisations déploient davantage de modèles d'apprentissage automatique, la traçabilité devient essentielle pour gouvernance l'explicabilité des modèles. Elle permet de documenter apprentissage utilisées, la manière dont les caractéristiques ont été conçues, le prétraitement effectué et les éventuelles modifications apportées à ces composants depuis déploiement du modèle. Lorsque les performances du modèle se dégradent, la traçabilité aide à déterminer si la cause est une dérive des données, une dérive des concepts ou des modifications dans les sources de données en amont.

Développement de produits de données: Les organisations qui créent data productsinternes ( jeux de données sélectionnés jeux de données pour être réutilisés par différentes équipes) s'appuient sur la traçabilité pour comprendre les dépendances et garantir la fiabilité. Les propriétaires de produits peuvent voir toutes les sources en amont dont dépend leur produit et tous les consommateurs en aval qui en dépendent, ce qui leur permet de gérer correctement les changements et de SLA .

Appliquer des contrôles d'accès et des politiques de sécurité basés sur les rôles

Le contrôle d'accès basé sur les rôles (RBAC) attribue des autorisations en fonction des rôles, garantissant ainsi que seuls les utilisateurs autorisés ont accès aux données sensibles tout en permettant une utilisation professionnelle légitime. Dans un catalogue, le RBAC associe les fonctions professionnelles à des droits de consultation, de modification et d'utilisation spécifiques, garantissant ainsi un accès cohérent et vérifiable.

L'intégration du RBAC aux politiques de sécurité de l'entreprise centralise l'application et simplifie les audits de conformité. L'automatisation des décisions d'accès basées sur des règles prédéfinies réduit la charge informatique et élimine les pratiques d'autorisation ad hoc qui créent des lacunes. Lorsque de nouveaux analystes rejoignent l'entreprise, ils reçoivent automatiquement les autorisations standard accordées aux analystes en fonction de leur service et de leur ancienneté. Lorsque des employés sont mutés, leurs autorisations sont automatiquement ajustées. Lorsque des employés quittent l'entreprise, leur accès est immédiatement révoqué sur tous les systèmes régis. Cette automatisation élimine le processus manuel de demande d'accès basé sur des tickets, qui entraîne des retards et des incohérences.

Le système RBAC avancé peut être adapté au contexte - adapter les autorisations en fonction de l'heure, du lieu, de l'appareil ou de l'objectif - afin d'équilibrer la protection stricte des informations sensibles et la flexibilité opérationnelle pour les flux de travail légitimes.

Cette approche sophistiquée concilie la protection stricte des informations sensibles et la flexibilité opérationnelle nécessaire aux flux de travail légitimes. Un data scientist peut accéder à l'intégralité des dossiers clients pour apprentissage de modèles apprentissage un ordinateur portable de l'entreprise pendant les heures de travail, mais ne voir que des statistiques agrégées sur un appareil personnel depuis son domicile. Un sous-traitant peut accéder à jeux de données spécifiques à un projet jeux de données la durée de son contrat, mais perd automatiquement cet accès à la fin de sa mission.

Mise en œuvre de la classification automatisée et de l'application des politiques

La classification automatisée applique des algorithmes et des ML pour étiqueter les données en fonction de leur type, de leur sensibilité et des exigences réglementaires, ce qui permet un traitement cohérent de l'ensemble des données. Elle remplace l'étiquetage manuel, source d'erreurs, et garantit que les enregistrements sensibles (PII, données financières, IP) sont identifiés de manière fiable.

Les classifications couvrent plusieurs dimensions : Le type de données identifie si les données sont des informations personnelles identifiables, des informations médicales protégées, des informations financières, des informations relevant de la propriété intellectuelle ou des informations publiques. Le niveau de sensibilité classe les données comme publiques, internes, confidentielles ou restreintes. Portée réglementaire identifie les données soumises au RGPD, à la loi HIPAA, à la norme PCI DSS, à la loi CCPA ou à des réglementations spécifiques à un secteur. Exigences de conservation spécifient la durée de conservation des données et le moment où elles doivent être supprimées. Restrictions géographiques indiquent où les données peuvent être stockées et qui peut y accéder en fonction des lois sur la résidence des données.

L'application des politiques utilise ces classifications pour appliquer automatiquement des contrôles - restrictions d'accès, masquage, règles de conservation et surveillance - tout en recherchant en permanence les violations des politiques. La plateforme peut signaler les accès inhabituels, générer des alertes et déclencher des flux de travail de remédiation afin de réduire les erreurs humaines et les délais d'application.

Les rapports de conformité automatisés produisent des pistes d'audit et des rapports (qui a accédé à quoi, quand et sous quels contrôles) requis par le GDPR, l'HIPAA et d'autres réglementations, réduisant ainsi les efforts et les risques liés aux rapports manuels.

Maintenir les pistes d'audit et permettre un contrôle proactif de la conformité

Les pistes d'audit enregistrement actions chronologiques sur les actifs de données - accès, éditions, changements de métadonnées et mises à jour de lignage - fournissant des preuves essentielles pour la responsabilité, les enquêtes sur les incidents et les audits réglementaires. Les journaux enregistrent l'utilisation directe et indirecte (rapports, analyses, pipelines) pour support analyse médico-légale et l'évaluation des risques.

La surveillance proactive de la conformité analyse en permanence les schémas d'accès, le respect des politiques et les anomalies d'utilisation afin de détecter les problèmes avant qu'ils ne s'aggravent. En cas d'anomalies, le système peut alerter les parties prenantes, lancer des flux de travail de remédiation ou appliquer des corrections automatiques en fonction de la gravité.

La surveillance avancée peut offrir des perspectives prédictives à partir de modèles historiques, aidant les équipes à anticiper et à prévenir les risques de non-conformité plutôt que de réagir après coup.

Faciliter la collaboration grâce à une documentation basée sur des modèles

La documentation basée sur des modèles standardise la manière dont les métadonnées, le contexte commercial, les affectations des responsables et les politiques sont collectés et présentés, réduisant ainsi la variabilité et les efforts manuels. Le glisser-déposer et les formulaires guidés permettent aux contributeurs non techniques d'ajouter du contexte, des règles métier et des conseils d'utilisation sans compétences spécialisées.

Les plateformes fournissent généralement des modules adaptés aux rôles : des modules de studio pour les intendants afin de gérer les flux de travail et les politiques, et des modules d'exploration pour les utilisateurs professionnels afin de découvrir les actifs et de contribuer à la connaissance du domaine. Les modèles support registres d'actifs, les glossaires, les affectations d'intendance, les déclarations de politique et les directives d'utilisation, le tout avec des flux d'approbation et un contrôle de version pour garantir l'exactitude.

Cette approche structurée et collaborative permet de répartir le travail de documentation, de maintenir la qualité et de s'assurer que les informations publiées sont examinées et régies.

Meilleures pratiques pour une mise en œuvre réussie du catalogue de données

Pour mettre en œuvre un catalogue avec succès, il faut tenir compte à la fois de la technologie et des personnes. Les pratiques clés comprennent :

- Attribuer une gestion claire: Désigner des propriétaires et des gestionnaires pour tous les principaux domaines de données, avec des responsabilités clairement définies en matière de documentation, de qualité et de gouvernance de l'accès.

- Développer et maintenir un glossaire commercial standardisé: Harmonisez la terminologie entre les équipes grâce à des définitions faisant autorité des termes, mesures et concepts commerciaux. Le glossaire devient la base sémantique qui garantit que tout le monde parle le même langage.

- métadonnées automatique métadonnées : Intégrez les mises à jour du catalogue pipeline de données CI/CD et pipeline de données afin que métadonnées automatiquement à jour.

- Fournir apprentissage basé sur les rôles: Adaptez apprentissage administrateurs, ingénieurs de données, analystes et utilisateurs professionnels à l'aide de scénarios pratiques illustrant la valeur du catalogue pour chaque rôle.

- Intégrer le catalogue dans les flux de travail:Embarquer Fonctionnalités les utilisateurs travaillent déjà afin que gouvernance Embarqué et ne constitue pas une étape supplémentaire.

Les organisations qui appliquent ces pratiques font état d'une meilleure visibilité des données,insight plus rapideinsight, d'une auditabilité renforcée et d'une plus grande confiance dans les résultats analytiques. Le catalogue passe d'une exigence de conformité à une capacité stratégique, permettant une innovation sûre et rapide.

En quoi les catalogues de données modernes diffèrent-ils des outils de catalogage traditionnels ?

catalogue de données traditionnels catalogue de données se concentrent principalement sur l'inventaire et la recherche. Bien qu'utiles, ces outils manquent souvent métadonnées en temps réel, d'un glossaire métier unifié, d'une traçabilité approfondie,gouvernance Embarqué et des indicateurs de qualité requis pour l'analyse et l'IA à l'échelle de l'entreprise.

Les catalogues de données modernes fonctionnent dans le cadre d'une plateforme de veille stratégique plus large. Ils collectent en permanence métadonnées techniques, commerciales et opérationnelles, relient la traçabilité, observabilité et les définitions du glossaire commercial, et Embarquer gouvernance directement dans la manière dont les données sont consultées et utilisées. Cette évolution transforme le catalogue, qui passe d'un système de référence passif à une couche active de contrôle et de confiance pour les données d'entreprise.

catalogue de données . Solutions traditionnelles et ponctuelles

De nombreuses organisations adoptent des solutions ponctuelles pour le catalogage des données, les glossaires métier, la traçabilité ou la qualité des données. Si ces outils répondent à des besoins individuels, ils créent souvent des expériences fragmentées difficiles à mettre à l'échelle.

Un catalogue de données moderne catalogue de données une plateforme d'intelligence des données unifie la découverte, les définitions du glossaire métier, la traçabilité, gouvernance et observabilité un seul et même système. Cela élimine les outils déconnectés, réduit le travail d'intégration manuel et garantit que gouvernance et les signaux de confiance sont appliqués de manière cohérente dans tous les workflows d'analyse et d'IA.

Contrairement aux outils de catalogue autonomes, une approche intégrée permet aux organisations d'aller au-delà de l'inventaire pour passer à gouvernance active, libre-service fiable et des données prêtes pour l'IA à l'échelle de l'entreprise.

FAQ

Un catalogue de données un métadonnées centralisé métadonnées qui aide les équipes à découvrir, comprendre et gérer les données d'entreprise. Il fonctionne en analysant automatiquement les sources de données, en collectant métadonnées, en classifiant les informations sensibles, en cartographiant la traçabilité et en appliquant gouvernance afin que les utilisateurs puissent rapidement trouver des données fiables pour l'analyse et l'IA.

Un catalogue de données l'intelligence des données en agissant comme principale couche de découverte et de contexte qui relie métadonnées, la traçabilité, gouvernance et la qualité des données à l'échelle de l'entreprise.

Au sein d'une plateforme de data intelligence, le catalogue collecte en continu métadonnées techniques, commerciales et opérationnelles, rendant les actifs de données consultables, compréhensibles et gérés à grande échelle. Il offre une visibilité sur la propriété, l'utilisation, la provenance et les indicateurs de confiance afin que les équipes d'analyse, les systèmes d'IA et les utilisateurs professionnels puissent sélectionner en toute confiance les données adaptées à leurs besoins.

Sans catalogue de données, l'intelligence des données manque d'une interface pratique pour la découverte et l'adoption. Le catalogue garantit que l'intelligence n'est pas seulement documentée, mais aussi activement utilisée dans les analyses, l'IA et les flux de travail opérationnels.

Un catalogue de données la visibilité et le contrôle dont gouvernance ont besoin. Il centralise métadonnées, normalise les définitions, applique les politiques d'accès et automatise la surveillance de la conformité. Cela réduit les risques, améliore la qualité des données et garantit gouvernance cohérente gouvernance l'ensemble du parc de données.

Un catalogue de données les principaux défis qui empêchent les organisations de faire confiance à l'utilisation des données et de la développer. Il élimine métadonnées fragmentées, réduit le travail d'analyse en double et facilite la recherche et la compréhension de données régies et de haute qualité.

Les catalogues de données modernes traitent des problèmes courants tels que les définitions commerciales incohérentes, la visibilité limitée de la traçabilité, les processus de conformité manuels et la faible confiance dans les résultats analytiques. En centralisant métadonnées, la traçabilité et la gouvernance et les indicateurs de qualité, un catalogue de données prise de décision plus rapide, une conformité renforcée et des initiatives fiables en matière d'IA et d'analyse.

Les catalogues de données d'entreprise nécessitent plus qu'une simple fonction de recherche et d'inventaire. Parmi les fonctionnalités essentielles, citons métadonnées automatisée métadonnées , la traçabilité de bout en bout, les contrôles d'accès basés sur les rôles, l'application des politiques, observabilité de qualité et observabilité des données, ainsi que support environnements hybrides et multicloud.

Dans la pratique, ces Fonctionnalités sont efficaces Fonctionnalités lorsque le catalogue s'inscrit dans le cadre d'une plateforme d'intelligence des données plus large, où gouvernance , les indicateurs de confiance et le contexte métier s'appliquent directement à la manière dont les données sont consultées et utilisées dans les systèmes d'analyse et d'IA. Sans cette base, les catalogues peinent à dépasser le cadre des petites équipes ou des cas d'utilisation liés uniquement à la conformité.

L'IA améliore un catalogue de données automatisant la découverte, la classification et métadonnées . L'apprentissage automatique identifie les modèles de données, détecte les anomalies, recommande des ressources connexes, signale les problèmes de qualité et prédit les risques potentiels de non-conformité. Ces Fonctionnalités les organisations Fonctionnalités adapter gouvernance moins de travail manuel.

Oui. Un catalogue de données moderne catalogue de données un rôle essentiel dans l'IA et l'apprentissage automatique en fournissant les métadonnées, la lignée et les modèles contextuels de qualité dont dépendent les modèles.

Les initiatives en matière d'IA nécessitent apprentissage fiables, des pipelines de fonctionnalités explicables et une visibilité sur l'évolution des données au fil du temps. Un catalogue de données y catalogue de données en documentant l'origine des données, leurs transformations, les signaux de qualité et les contraintes d'utilisation, ce qui réduit les risques, les biais et la dérive des modèles tout en améliorant la transparence et gouvernance.

Les catalogues open source offrent une grande flexibilité aux équipes qui souhaitent personnaliser leurs propres outils, mais qui peuvent avoir besoin de ressources techniques supplémentaires. Les catalogues de données d'entreprise offrent gouvernance intégrées d'automatisation, gouvernance de sécurité, évolutivité, support et d'intégration avec plateformesde données plus larges, ce qui les rend mieux adaptés aux environnements réglementés ou à grande échelle.