7 Schritte zum Aufbau einer KI-bereit Dateninfrastruktur

Der Aufbau einer KI-fähigen Dateninfrastruktur ist entscheidend, um das volle Potenzial von KI-Technologien zu erschließen. Die meisten KI-Projekte scheitern an schlechten Datensystemen, nicht an der KI selbst. Hier erfahren Sie, wie Sie einen skalierbar und effizienten Framework für den KI-Erfolg schaffen:

- Prüfung der aktuellen Datensysteme: Identifizieren Sie Lücken in der Datenqualität, der Verwaltung und dem Zugriff.

- Einhaltung von Vorschriften sicherstellen: Richten Sie Ihre Systeme an Vorschriften wie HIPAA, SOX oder CCPA aus.

- Integrieren Sie Datenquellen: Nutzen Sie hybride Plattformen, um On-Premises, Cloud und Edge-Daten zu vereinen.

- Etablieren Sie Governance: Erstellen Sie klare Richtlinien und automatisieren Sie die Durchsetzung, um Beständigkeit zu gewährleisten.

- Überwachen Sie die Datenqualität: Nutzen Sie KI-Tools zur Echtzeitverfolgung und Problemlösung.

- Pipelines automatisieren: Erstellen Sie modulare Pipelines mit No-Code-Tools für mehr Effizienz.

- Bereitstellung von High-Performance und Rechenleistung: Passen Sie Speicher- und Rechenleistung an die KI-Anforderungen an und nutzen Sie hybride Cloud .

Diese Schritte helfen Unternehmen, Daten effektiv verwalten , Kosten zu senken und die KI-Ergebnisse zu verbessern. Unternehmen wie Standard AI und Pickle Robot haben bereits messbare Vorteile, wie Kosteneinsparungen und verbesserte Genauigkeit, festgestellt. Es wird erwartet, dass KI bis 2030 einen Mehrwert von 15,7 Billionen Dollar für die Weltwirtschaft bringt. Daher ist es jetzt an der Zeit, Ihre Dateninfrastruktur vorzubereiten.

Aufbau einer High-Performance Dateninfrastruktur für KI

Schritt 1: Überprüfen Sie Ihre aktuellen Datensysteme

Bevor Sie mit dem Aufbau einer KI-fähigen Infrastruktur beginnen, sollten Sie Ihre aktuelle Datenumgebung genau kennen. Wenn Sie diesen Schritt auslassen, kann das zu kostspieligen Fehlern führen. Beginnen Sie mit der Bewertung Ihrer bestehenden Datensysteme, um eine solide Grundlage für Verbesserungen zu schaffen.

Führen Sie eine vollständige Datenprüfung durch

Eine gründliche Datenprüfung ist der Schlüssel zu einem klaren Bild der Datenbestände Ihres Unternehmens. Legen Sie zunächst klare Ziele für die Prüfung fest und katalogisieren Sie alle Ihre Datenquellen. Dazu gehört alles, von Altsystemen und Cloud bis hin zu Tabellenkalkulationen und sogar nicht autorisierten Quellen.

Schauen Sie sich genau an Datenqualität indem Sie Faktoren wie Genauigkeit, Vollständigkeit, Beständigkeit, Aktualität, Einzigartigkeit und Gültigkeit bewerten. Verwenden Sie Profiling-Techniken, um Probleme wie Anomalien, Duplikate oder fehlende Werte aufzudecken. So können Sie beispielsweise inkonsistente Formatierungen oder Namenskonventionen feststellen, die korrigiert werden müssen, bevor Sie fortfahren.

Weiter, bewerten Sie Ihre derzeitigen Datenmanagement . Stellen Sie fest, wie Daten in Ihrem Unternehmen erfasst, gespeichert, verarbeitet und gepflegt werden. Dieser Schritt kann Lücken in der Verwaltung aufdecken, z. B. schwache Kontrollen der Dateneingabe oder veraltete Sicherheitsmaßnahmen. Vergewissern Sie sich, dass Ihre Praktiken sowohl mit den internen Richtlinien als auch mit den Branchenstandards übereinstimmen.

Ein weiterer wichtiger Aspekt ist die Analyse der Datenzugriffs- und Nutzungsmuster. Ermitteln Sie, wer auf welche Arten von Daten Zugriff hat, und stellen Sie fest, ob diese Zugriffsebenen angemessen sind. Dies kann Situationen aufzeigen, in denen sensible Daten übermäßig exponiert sind oder in denen wichtige Daten nicht mit den Teams geteilt werden, die sie am dringendsten benötigen.

Es ist erwähnenswert, dass mehr als 80 % der KI-Projekte scheitern, oft weil sich Unternehmen auf oberflächliche Symptome konzentrieren, anstatt die tieferen Probleme innerhalb ihrer Dateninfrastruktur anzugehen.

"Selbst die besten KI-Tools können ein unverstandenes Problem nicht beheben. Dauerhafte Lösungen erfordern die Identifizierung und Behebung der wahren Workflow-Schmerzpunkte in einem Prozess." - Terry Cangelosi und Bobby Hunter, Orr Group

Endlich, dokumentieren Sie alles in einem detaillierten Bericht. Fügen Sie Ihre Ergebnisse zu Datenqualitätsproblemen, Sicherheitsschwachstellen und Lücken in den Verwaltungspraktiken zusammen mit umsetzbaren Empfehlungen zur Behebung der einzelnen Bereiche bei. Dieser Bericht bildet die Grundlage für die Integration von KI-fähigen Datensystemen.

Nach Abschluss des Audits besteht der nächste Schritt darin, Ihre Systeme an die Compliance- und Governance-Standards anzupassen.

Festlegung von Compliance- und Governance-Anforderungen

Für Unternehmen mit Sitz in den USA ist es unabdingbar, die Compliance-Anforderungen zu kennen. Die Datenschutzgesetze variieren je nach Branche und Bundesstaat, sodass eine frühzeitige Befassung mit diesen Vorschriften Sie später vor kostspieligen Verstößen bewahren kann.

Beginnen Sie damit, die für Ihr Unternehmen geltenden Vorschriften zu ermitteln, z. B. HIPAA, SOX, GLBA oder CCPA. Organisationen des Gesundheitswesens müssen beispielsweise die HIPAA-Standards für Patientendaten erfüllen, während Finanzunternehmen SOX und GLBA einhalten müssen. Wenn Ihr Unternehmen in Kalifornien tätig ist oder die Einwohner Kaliforniens beliefert, kommen auch die CCPA-Bestimmungen zum Schutz von Verbraucherdaten ins Spiel.

Anforderungen an die Datenresidenz sind ein weiterer kritischer Faktor. Einige Vorschriften schreiben vor, dass bestimmte Arten von Daten innerhalb der US-Grenzen verbleiben oder bestimmte Sicherheitszertifizierungen erfüllen müssen. Die Kenntnis dieser Vorschriften ist eine wichtige Grundlage für Entscheidungen über Cloud und Speicherarchitektur.

Überprüfen Sie außerdem Ihre Richtlinien für die Aufbewahrung und Löschung von Daten um sicherzustellen, dass sie den gesetzlichen Normen entsprechen. Einige Gesetze verpflichten Sie, bestimmte Daten für einen bestimmten Zeitraum aufzubewahren, während andere die sofortige Löschung personenbezogener Daten auf Anfrage vorschreiben. Diese Vorschriften haben direkten Einfluss darauf, wie Sie Ihre Speichersysteme gestalten und den Lebenszyklus der Daten verwalten .

Um diesen Schritt abzuschließen, dokumentieren Sie alle Lücken in der Einhaltung und erstellen Sie einen Plan zur Behebung. Konzentrieren Sie sich auf die dringlichsten Probleme, die die KI-Implementierung verzögern oder zu behördlichen Strafen führen könnten. Legen Sie klare Zeitpläne fest, weisen Sie Verantwortlichkeiten zu und definieren Sie Erfolgsmetriken für jede Aufgabe. Indem Sie diese Lücken im Vorfeld angehen, stellen Sie sicher, dass Ihre Data Governance stark genug ist, um fortschrittliche KI-Initiativen zu unterstützen.

Werden diese grundlegenden Arbeiten vernachlässigt, führt dies häufig zu größeren Problemen, deren Behebung später sehr viel teurer und störender ist.

Schritt 2: Skalierbare Datenintegration einrichten

Nach Abschluss der Datenprüfung und der Ermittlung der Compliance-Anforderungen besteht der nächste Schritt darin, all Ihre Datenquellen in einem einheitlichen System zusammenzuführen. Moderne Unternehmen sind im Durchschnitt auf 187 bis 190 Anwendungen angewiesen, wodurch ein kompliziertes Datennetz entsteht, das harmonisch funktionieren muss. Bis 2025 wird das weltweite Datenaufkommen voraussichtlich 163 Zettabyte pro Jahr erreichen. Angesichts dieser gewaltigen Datenmengen ist eine skalierbar Integrationsstrategie entscheidend für den Erfolg von KI-Initiativen.

Die Daten von heute sind über On-Premises Systeme, mehrere Clouds und Edge-Standorte verteilt, was herkömmliche Integrationsmethoden überfordern kann. Um dieses Problem zu lösen, wenden sich Unternehmen hybriden Integrationsplattformen zu, um diese unterschiedlichen Umgebungen nahtlos zusammenzuführen.

Im Folgenden erfahren Sie, wie Sie hybride Datenquellen verbinden und effiziente Batch- undStreaming-Datenpipelines entwerfen.

Hybride Datenquellen verbinden

Hybride Integrationsplattformen vereinfachen den Prozess der Vereinheitlichung von Daten und Anwendungen in On-Premises und Cloud . Dieser Ansatz beseitigt Datensilos, die häufig KI-Initiativen behindern.

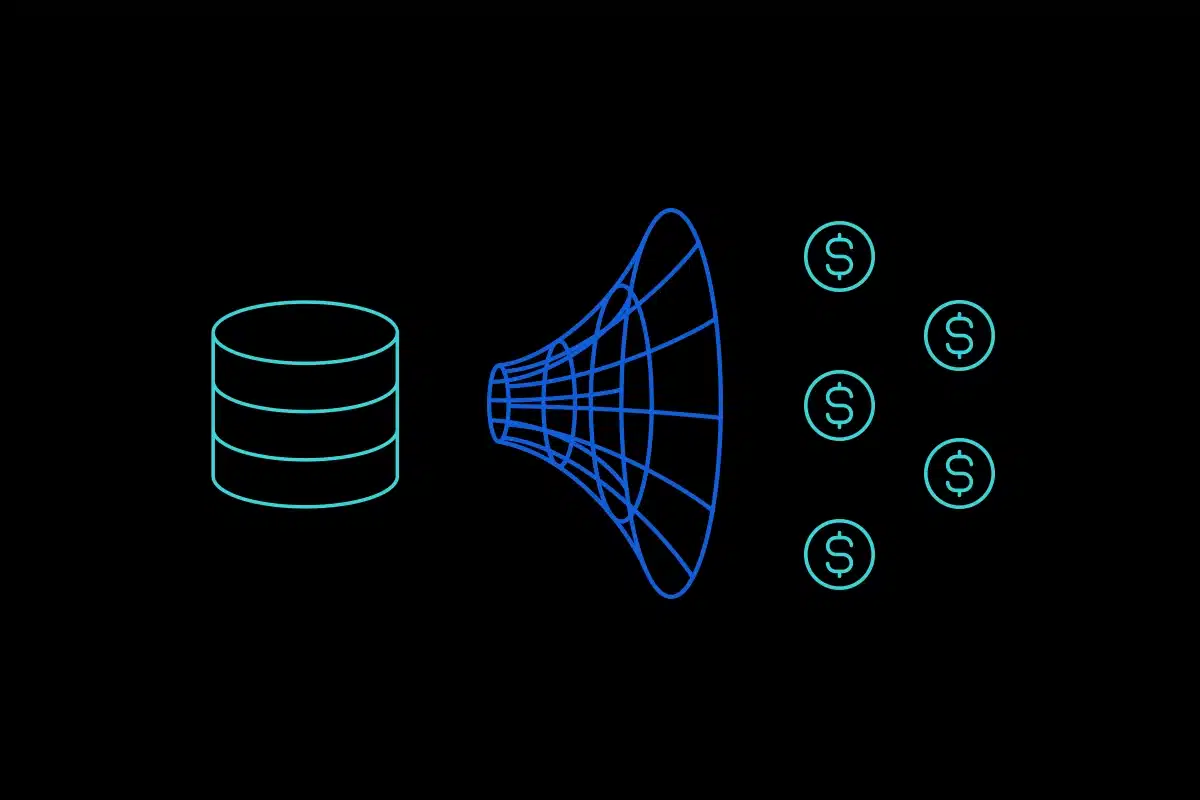

"Eine hybride Integrationsplattform sollte Unternehmen alle Tools zur Verfügung stellen, die sie benötigen, um die Integration von Daten und Anwendungen in jeder On-Premises und Multicloud-Umgebung zu vereinfachen und zu erleichtern. Wenn Datensilos aufgebrochen werden, haben Unternehmen eine unglaubliche Chance, ihre Daten in verwertbare Erkenntnisse umzuwandeln und so schneller bessere Entscheidungen zu treffen." - Pete McCaffrey, Direktor, IBM Hybrid Cloud Marketing

Achten Sie bei der Auswahl einer Integrationsplattform auf Funktionen wie API-Lebenszyklusmanagement, Unterstützung für strukturierte und unstrukturierte Daten, Echtzeitverarbeitung durch Messaging und ereigniszentriert Architekturen sowie Hochgeschwindigkeitsdatenübertragung Fähigkeiten. So bietet Actian DataConnect eine nahtlose Integration über Cloud, On-Premises und hybride Umgebungen hinweg und verarbeitet unbegrenzte Datentypen und -mengen.

Beispiele aus der Praxis zeigen die Vorteile der hybriden Integration. Emirates Global Aluminium (EGA) implementierte ein hybrides Setup, das private Cloud mit On-Premises Rechenzentren und öffentlichen Cloud verbindet. Dieser Ansatz reduzierte die Latenzzeit, unterstützte fortschrittliche KI und Automatisierung und erreichte eine 10- bis 13-mal schnellere KI-Verarbeitung mit 86 % Kosteneinsparungen für Bild- und Videoanwendungen. In ähnlicher Weise entwickelte Uniper ein zentralisiertes dashboard , um Anwendungen über Cloud und On-Premises hinweg verwalten , was schnellere Serviceeinführungen und eine verbesserte Leistung ohne Unterbrechung der kritischen Infrastruktur ermöglichte.

Achten Sie bei der Bewertung von Plattformen vor allem auf starke Sicherheitsmaßnahmen wie Verschlüsselung, Identitätsmanagement und Zugangskontrollen. Achten Sie außerdem darauf, dass die Plattform verschiedene Datenformate verarbeiten kann und Ihre Compliance-Anforderungen erfüllt.

Erstellen von Batch- und Streaming

KI-Systeme arbeiten sowohl mit historischen als auch mit Echtzeitdaten. Deshalb ist der Aufbau robuster Stapelverarbeitungs- und Streaming für die Verarbeitung großer täglicher Datenmengen unerlässlich.

Bei der Entwicklung von Streaming sollten Sie auf Scalability und minimale Latenz achten. Verteilte Systeme mit paralleler Verarbeitung können helfen, den Durchsatz bei wachsenden Datenmengen aufrechtzuerhalten. Die Automatisierung von Tests und Überwachung mit Warnsystemen kann ebenfalls dazu beitragen, Leistungsprobleme frühzeitig zu erkennen und zu beheben.

Bei Streaming sollten Fehlertoleranz und hoher Durchsatz im Vordergrund stehen. Die Tools müssen den Status beibehalten und die Ressourcenzuweisung dynamisch anpassen, um wechselnde Anforderungen zu bewältigen. Die Implementierung von Change Data Capture (CDC) gewährleistet Datensynchronisierung in Echtzeit. In Anbetracht der Tatsache, dass mehr als 80 % der Führungskräfte in Unternehmen die Bedeutung der Datenintegration für den täglichen Betrieb betonen, wird die Einrichtung leistungsstarker Batch- und Streaming Ihre KI-Anwendungen darauf vorbereiten, effektiv zu skalieren und einen langfristigen Mehrwert zu liefern.

Schritt 3: Aufbau einer starken Data Governance

Sobald integrierte Datenpipelines vorhanden sind, besteht der nächste Schritt darin, eine solide Governance zu etablieren, um Beständigkeit und Sicherheit für KI-Systeme zu gewährleisten. Laut Gartner riskieren 80 % der digitalen Organisationen einen Misserfolg ohne moderne Data Governance. Obwohl 68 % der Unternehmen fast 30 % ihrer IT-Budgets für das Datenmanagement bereitstellen, erreichen nur 12 % die KI-Reife. Eine starke Governance stellt sicher, dass KI-Modelle mit genauen, zuverlässigen Daten gefüttert werden, Vorschriften wie GDPR und CCPA einhalten und dazu beitragen, KI-Verzerrungen zu mindern. Dies schafft einen Framework für klare, durchsetzbare Richtlinien, die KI-Initiativen effektiv unterstützen.

Schaffung föderaler Governance-Rahmenwerke

Herkömmliche Governance-Modelle stehen oft vor Herausforderungen: Zentralisierte Systeme können zu Engpässen führen, während dezentralisierte Ansätze zu Datensilos und uneinheitlichen Standards führen können. Ein föderiertes Governance-Modell bietet einen Mittelweg, indem es die zentrale Festlegung von Richtlinien mit der lokalen Ausführung kombiniert, einheitliche Standards sicherstellt und die einzelnen Teams befähigt.

"Federated Data Governance ist ein hybrides Governance-Modell, das ein Gleichgewicht zwischen Top-Down-Kontrolle und lokaler Autonomie schafft, indem es zentralisierte Data Governance mit dezentraler Ausführung verbindet." - Michael Meyer

Bei diesem Modell legt ein zentrales Führungsgremium die Unternehmensrichtlinien, Compliance-Anforderungen und Messkriterien fest, während lokale Teams für die tägliche Arbeit zuständig sind. Dieser Ansatz ermöglicht es den Teams, ihre Datenprodukte unabhängig verwalten und gleichzeitig die übergreifenden Governance-Standards einzuhalten.

Ein gutes Beispiel ist The Very Group. Im Jahr 2020 führte der Chief Data Officer Steve Pimblett eine Hub-and-Spoke-Governance-Struktur mit Alation ein. Diese Einrichtung zentralisierte die Koordinierung von Richtlinien auf hoher Ebene und gab gleichzeitig den einzelnen Abteilungen die Flexibilität, ihre Datenanforderungen zu verwalten , was zu einer kohärenteren und fortschrittlicheren Datenkultur führte.

Zu den wichtigsten Schritten bei der Umsetzung der föderalen Verwaltung gehören:

- Bilden Sie einen Governance-Rat mit lokalen Verwaltern: Dieser Rat sollte die Unternehmensrichtlinien festlegen und die zentralen Richtlinien an die spezifischen Datenbereiche anpassen. Dazu gehören Vertreter der IT, der Rechtsabteilung, der Compliance-Abteilung und der wichtigsten Geschäftsbereiche.

- Führen Sie einen skalierbar Datenkatalog ein: Die Zentralisierung von Metadaten erleichtert die Suche nach Assets und fördert ein gemeinsames Verständnis zwischen den Teams.

- Standardisierung der Datenklassifizierung: Verwenden Sie eine einheitliche Taxonomie zur Klärung von Datentypen, Sensibilitätsstufen und Nutzungsbeschränkungen, um eine reibungslosere Interoperabilität zu gewährleisten.

Sobald ein Governance-Rahmen vorhanden ist, wird die Automatisierung entscheidend, um diese Standards effektiv und in großem Umfang durchzusetzen.

Automatisierte Durchsetzung von Richtlinien verwenden

Die automatisierte Durchsetzung von Richtlinien gewährleistet Beständigkeit, reduziert Fehler und sorgt für die Einhaltung von Richtlinien bei gleichzeitiger Verringerung des Workload. Zu den wichtigsten Vorteilen gehören die Erkennung von Richtlinienverstößen in Echtzeit, Abhilfeworkflows, eine konsistente Zugriffskontrolle und umfassende Protokolle.

CHRISTUS Health hat beispielsweise automatisierte Governance-Tools implementiert, um die Komplexität seines elektronischen Gesundheitsdatensystems (EHR) verwalten . Bis 2023 nutzte das Unternehmen die Data-Lineage-Lösung von MANTA, um die Transparenz zu erhöhen, Probleme proaktiv zu lösen und die Compliance in der Datenumgebung des Gesundheitswesens zu gewährleisten. Fortschrittliche Data-Lineage-Tools wie diese helfen Unternehmen, von der reaktiven Problemlösung zu einem proaktiven Ansatz überzugehen, der eine agile Governance ermöglicht.

Um eine automatische Durchsetzung von Richtlinien zu implementieren:

- Einbindung von Fachleuten aus dem Unternehmen: Stellen Sie sicher, dass automatisierte Richtlinien mit den realen Geschäftsanforderungen und Arbeitsabläufen übereinstimmen, indem Sie Experten aus jedem Datenbereich einbeziehen.

- Setzen Sie eine aktive Data Governance ein: Verwenden Sie eine Plattform mit Funktionen wie einem zentralisierten Lager, Transparenz-Tools, Durchsetzungsanalysen und Protokolle. Die Data Intelligence Platform von Actian beispielsweise bietet diese Fähigkeiten durch Knowledge-Graph-Technologie und föderierte Governance-Funktionen.

- Definieren Sie Durchsetzungsmetriken: Verfolgen Sie Kennzahlen wie die Häufigkeit der Einhaltung von Richtlinien, die Häufigkeit von Verstößen, die Reaktionszeit auf Vorfälle, die Einhaltung von Vorschriften und die Akzeptanz von Governance-Tools, um die Wirksamkeit des Systems zu messen.

- Implementieren Sie Governance nach Ausnahmen: Legen Sie Toleranzgrenzen fest und überwachen Sie die Leistung, um Richtlinienverstöße schnell zu erkennen und zu beheben.

Automatisierte Governance vereinfacht nicht nur die Compliance, sondern stärkt auch die Grundlage für eine effiziente und sichere Bereitstellung von KI-Modellen.

Schritt 4: Überwachung von Datenqualität und Leistung

Sobald Sie Governance-Rahmen und integrierte Pipelines eingerichtet haben, besteht der nächste wichtige Schritt darin, die Datenqualität und -leistung im Auge zu behalten. Dies ist nicht nur ein "Nice-to-have" - es ist unerlässlich. Schlechte Datenqualität kostet Unternehmen jährlich durchschnittlich 12,9 Millionen Dollar. Gartner prognostiziert sogar, dass die Beobachtbarkeit bis 2025 ein Hauptaugenmerk sein wird. Und warum? Weil Dateningenieure heute fast die Hälfte ihrer Zeit mit routinemäßigen Zuverlässigkeitsaufgaben verbringen, während Datenanalysten 40-80 % ihrer Zeit für die Sicherstellung der Datenqualität aufwenden. Die Branche bewegt sich in Richtung proaktiver Lösungen, wobei Beobachtbarkeit den Ton angeben. Diese Tools können Probleme erkennen und beheben, bevor sie die Leistung von KI-Modellen beeinträchtigen.

Datenqualität in Echtzeit verfolgen

Die Echtzeitüberwachung hebt das Datenqualitätsmanagement auf die nächste Stufe. Anstatt sich auf statische Schwellenwerte zu verlassen, definiert Maschinelles Lernen "normale" Basiswerte und zeigt subtile Abweichungen an, die KI-Modelle verfälschen könnten. Diese Plattformen führen Metriken, Protokolle und Traces zusammen, um ein vollständiges Bild des Datenzustands zu vermitteln und gleichzeitig eine proaktive Erkennung von Anomalie zu ermöglichen. KI-gestützte Tools rationalisieren den Prozess durch die Automatisierung von Aufgaben wie Datenprofilierung, Anomalie und sogar Datenbereinigung.

Hier sind einige der wichtigsten Merkmale der modernen Datenqualitätsüberwachung:

- Intelligente Erkennung von Anomalie : Die KI lernt aus historischen Daten, um ungewöhnliche Muster und Anomalien zu erkennen. Sie kann sogar Probleme vorhersagen und fehlende Daten auf der Grundlage früherer Trends ergänzen.

- Automatisierte Datenprofilierung: Sucht kontinuierlich nach Änderungen in der Datenstruktur, dem Datenvolumen oder der Datenqualität, die nachgelagerte KI-Anwendungen stören könnten.

- Überwachung der Einhaltung: Hilft bei der Einhaltung von Vorschriften wie GDPR oder HIPAA, indem es Fehler identifiziert und die Datengenauigkeit aufrechterhält, wodurch sich der Bedarf an arbeitsintensiven Audits verringert.

- Ursachenanalyse: Fortschrittliche Tools sagen Ihnen nicht nur, dass etwas schief gelaufen ist - sie helfen Ihnen auch, die Gründe dafür zu verstehen und beschleunigen so die Problemlösung.

Um die Echtzeitüberwachung effektiv zu gestalten, sollten Sie wichtige Leistungsindikatoren (KPIs) für die Datenqualität festlegen, z. B. Vollständigkeit, Genauigkeit, Beständigkeit und Aktualität. Die Verwendung offener Standards wie OpenTelemetry kann auch dazu beitragen, Kosten zu senken und die Kompatibilität zwischen verschiedenen Systemen zu verbessern.

Die Echtzeitüberwachung schafft natürlich die Voraussetzungen für ein proaktives Störungsmanagement.

Automatisches Incident Management und Warnmeldungen einrichten

Sobald Sie eine Echtzeitverfolgung eingerichtet haben, besteht der nächste Schritt darin, die Erkenntnisse in Maßnahmen umzusetzen. Automatisierte Incident-Management-Systeme sind genau dafür ausgelegt. Sie senden kontextspezifische Warnungen, bevor Probleme eskalieren, und helfen den Teams, Probleme zu lösen, bevor sie die KI-Leistung beeinträchtigen.

So bietet Actian Data Beobachtbarkeit eine robuste Lösung mit Echtzeit-Warnungen, SQL-basierten Metriken und automatisierten Incident-Tickets. Dies ermöglicht Unternehmen den Übergang von der reaktiven Problemlösung zum proaktiven Qualitätsmanagement.

So sieht ein effektives automatisiertes Störungsmanagement aus:

- Schwellenwert-basierte Alarmierung: Sendet Echtzeit-Benachrichtigungen, sobald Schwellenwerte überschritten werden.

- prädiktive Analyse und automatisierte Problembehebung: Kombiniert prädiktive Analyse mit automatisierten Korrekturen, um sicherzustellen, dass Probleme schnell und mit Hilfe detaillierter Protokolle behoben werden.

- Umfassende Prüfpfade: Bietet eine klare Aufzeichnung von Vorfällen zur Unterstützung der Compliance und der kontinuierlichen Verbesserung.

- Verfolgung derMigration : Hilft dabei, festzustellen, wo Datenqualitätsprobleme die größten Leistungs- und Kostenprobleme verursachen.

Bei der Implementierung dieser Systeme ist es wichtig, die Datenaufbewahrungsrichtlinien zu optimieren und die Speicherkosten gegen den Wert der zu überwachenden Daten abzuwägen. Konzentrieren Sie sich auf Warnmeldungen, die verwertbare Erkenntnisse liefern, damit die Teams echten Bedrohungen der Datenqualität wirksam begegnen können.

sbb-itb-73daff9

Schritt 5: Automatisieren von Datenpipelines und Arbeitsabläufen

Sobald Sie die Überwachung der Datenqualität in Echtzeit und ein automatisiertes Störungsmanagement eingerichtet haben, ist der nächste Schritt die Automatisierung Ihrer Datenpipelines. Warum? Weil die manuelle Datenverarbeitung mit den wachsenden Anforderungen der heutigen data-driven Welt einfach nicht mehr Schritt halten kann. Es wird erwartet, dass der weltweite Markt für Datenpipeline von 12,3 Milliarden US-Dollar im Jahr 2025 auf 43,6 Milliarden US-Dollar im Jahr 2032 ansteigen wird, mit einer jährlichen Wachstumsrate von fast 20 %. Dieses Wachstum unterstreicht einen klaren Trend: Unternehmen setzen zunehmend auf Automatisierung, um größere Datenmengen ohne ständigen manuellen Aufwand verwalten .

Automatisierung spart nicht nur Zeit, sondern erhöht auch die Zuverlässigkeit. Dateningenieure können sich auf hochwertige Aufgaben konzentrieren, z. B. die Erstellung fortschrittlicher KI-Modelle oder die Bewältigung komplexer geschäftlicher Herausforderungen. Und mit Automatisierung als Rückgrat werden Workflow-Anpassungen mit No-Code- oder Low-Code-Tools noch einfacher.

Entwurf skalierbarer Datenpipelines

Der Aufbau skalierbar Datenpipelines ist unerlässlich, um sicherzustellen, dass Ihr System wachsende Datenmengen problemlos verarbeiten kann. Beginnen Sie mit einem modularen Design und kombinieren Sie es mit einer Cloud Infrastruktur, die Ressourcen automatisch und On Demand skalieren kann.

Hier ist die Vorgehensweise:

- Modulare Komponenten: Entwerfen Sie jeden Teil der Pipeline als separates Modul. Auf diese Weise können Sie bestimmte Komponenten skalieren - wie z. B. die Zuweisung von mehr Ressourcen für Dateneingang in Spitzenzeiten -, ohne das gesamte System zu überarbeiten.

- Versionskontrolle: Tools wie Git sind für die Verfolgung von Änderungen, die Zusammenarbeit und die Rücknahme von Aktualisierungen bei Bedarf von entscheidender Bedeutung.

- Eingebaute Validierung: Warten Sie nicht bis zum Ende, um nach Fehlern zu suchen. Fügen Sie in der gesamten Pipeline Validierungsschritte ein, um Probleme wie Schemafehlanpassungen, Nullwerte oder Duplikate frühzeitig zu erkennen.

- Automatisierte Orchestrierung: Verwenden Sie Tools wie Airflow oder Prefect, um die Ausführung vonAufgabe und Wiederholungsversuchen verwalten . Diese Systeme können eine automatisierte Wiederherstellung versuchen, wenn etwas schief läuft, und eskalieren nur bei Bedarf an Menschen.

- Anpassung an die Schemaentwicklung: Datenstrukturen ändern sich im Laufe der Zeit, planen Sie also eine Schemaveränderung ein. Verwenden Sie Tools, die Änderungen erkennen und sicherstellen, dass Transformationen angepasst werden, ohne nachgelagerte Prozesse zu stören.

- Sichere Deployment: Mit Feature-Flags und gestaffelten Rollouts können Sie Aktualisierungen in kontrollierten Umgebungen testen, bevor sie vollständig implementiert werden, wodurch Risiken minimiert werden und bei Bedarf ein schneller Rollback möglich ist.

"Shakudo gab uns die Flexibilität, die Komponenten des Datenstapels zu verwenden, die unseren Anforderungen entsprechen, und den Stapel weiterzuentwickeln, um mit der Branche Schritt zu halten." - Neal Gilmore, Senior Vice President, Enterprise Data & Analytics

Während robuste Pipelines die technische Grundlage bilden, erleichtern No-Code-Tools die Anpassung und Pflege von Arbeitsabläufen.

No-Code/Low-Code-Workflow-Tools verwenden

No-Code- und Low-Code-Plattformen verändern das Spiel für die Automatisierung von Datenpipeline . Diese Tools ermöglichen es nicht-technischen Benutzern, zur Pipeline-Entwicklung beizutragen, und bieten gleichzeitig die Flexibilität, die technische Teams benötigen. Das Ergebnis? Schnellere Deployment und einfachere Zusammenarbeit zwischen Teams.

Diese Plattformen nutzen visuelle Schnittstellen und vorgefertigte Tools, um die Entwicklung zu vereinfachen. Sie beschleunigen nicht nur den Prozess, sondern machen auch die Pipeline-Logik für alle Beteiligten leichter verständlich. Viele moderne Tools enthalten sogar künstliche Intelligenz, die es den Nutzern ermöglicht, Aufgaben in einfachem Englisch zu beschreiben und die technische Ausführung dem System zu überlassen.

Ein herausragendes Merkmal ist die Fähigkeit der Pipelines, sich automatisch anzupassen, wenn sich die Metadaten der Quelle ändern. Wenn beispielsweise eine Datenquelle neue Felder einführt oder Datentypen ändert, können diese Tools nachgelagerte Prozesse automatisch anpassen und so die manuelle Wartung reduzieren.

Wenn Sie sich für eine No-Code- oder Low-Code-Plattform entscheiden, sollten Sie Lösungen den Vorzug geben, die:

- Starke Fähigkeiten.

- Zuverlässige Sicherheit und Überwachung.

- Unterstützung für Skripting oder benutzerdefinierte Module, um komplexere Anforderungen zu erfüllen.

Durch die Einbettung der automatischen Datenvalidierung in diese Arbeitsabläufe wird die Datenintegrität bei jedem Schritt gewährleistet, so dass der Bedarf an manueller Überwachung sinkt.

Unternehmen, die in eine skalierbar Dateninfrastruktur, einschließlich No-Code-Automatisierungstools, investieren, verzeichnen eine Steigerung der betrieblichen Effizienz um 20 %. Diese Verbesserung ergibt sich aus weniger manuellen Eingriffen, schnelleren Deployment und einer konsistenteren Datenverarbeitung.

"Die Zukunft des Unternehmens wird auf Daten aufgebaut sein, und Scalability wird der entscheidende Faktor dafür sein, wer Erfolg hat." - Marc Benioff, CEO von Salesforce

Schritt 6: Bereitstellung von High-Performance und Rechenleistung

Sobald Ihre automatisierten Datenpipelines einsatzbereit sind, müssen Sie sich im nächsten Schritt auf den Aufbau einer robusten Infrastruktur konzentrieren, die den hohen Anforderungen von KI-Workloads gerecht wird. KI-Anwendungen sind auf schnellen Datenzugriff und leistungsstarke Fähigkeiten angewiesen. Um einen reibungslosen Betrieb während des Training und der Inferenz sicherzustellen, benötigen Sie Speicher- und Rechenressourcen , die potenzielle Engpässe beseitigen.

Wenn Ihr Speichersystem zu langsam ist, kann es teure Grafikprozessoren ungenutzt lassen. Ebenso kann eine unzureichende Rechenleistung schnelle Aufgaben in langwierige Prozesse verwandeln. Moderne Speicherlösungen und hybride Cloud ermöglichen es Ihnen, Leistung und Kosten separat zu skalieren, sodass Sie die Flexibilität haben, sich nach Bedarf anzupassen.

Wählen Sie skalierbare Speicherlösungen

KI-Workloads bringen Speicheranforderungen mit sich, die herkömmliche Unternehmenssysteme oft nur schwer erfüllen können. Ihr Speicher muss mit den GPU-Geschwindigkeiten mithalten und gleichzeitig die enormen Datensätze verwalten, die für KI-Modelle erforderlich sind. Flash-Speicher bietet beispielsweise eine deutlich höhere Geschwindigkeit als herkömmliche Festplatten und ist für aktive KI-Abläufe unerlässlich.

Suchen Sie nach Speicherlösungen, mit denen Sie Leistung und Kapazität unabhängig voneinander skalieren können. Auf diese Weise wird vermieden, dass Sie zu viel für High-Performance bezahlen, wenn Sie nur mehr Speicherplatz benötigen, oder dass Sie zu wenig Leistung erhalten, wenn ein schnellerer Zugriff erforderlich ist.

Bei der Bewertung von Speicheroptionen sollten Sie Leistungskennzahlen wie Bandbreite, IOPS und Latenz auf die spezifischen Anforderungen Ihrer KI-Anwendungen abstimmen. Zum Beispiel:

- Das Trainieren großer Sprachmodelle erfordert oft eine anhaltend hohe Bandbreite, um Daten an mehrere GPUs zu übertragen.

- Echtzeit-Inferenz konzentriert sich auf die Minimierung der Latenzzeit für schnelle Antworten.

Objektspeicher sind besonders nützlich für die Verwaltung großer Mengen von Metadaten. Um Ihre Speicherstrategie zu optimieren, sollten Sie Folgendes berücksichtigen:

- Lebenszyklus- und Datenmanagement: Trennen Sie "aktive" Daten, auf die häufig zugegriffen wird, von "inaktiven" Daten, die für die Archivierung oder Compliance verwendet werden. Verwenden Sie Systeme wie Azure Managed Lustre, Azure NetApp Files oder lokale NVMe/SSD-Dateisysteme für aktive Daten. Inaktive Daten können automatisch auf kostengünstigere Storage-Tiers verschoben werden. Implementieren Sie eine Datenversionierung, um Änderungen an Datensätzen und Modellen zu verfolgen, was bei Rollbacks und Reproduzierbarkeit hilft.

- Sicherheit und Leistung: Schützen Sie Ihre KI-Daten vor Bedrohungen wie Hackerangriffen oder Manipulationen und sorgen Sie gleichzeitig dafür, dass die Sicherheitsmaßnahmen die Leistung nicht beeinträchtigen.

Ein Beispiel aus der Praxis kommt von VAST Data, dessen Technologie zur Ähnlichkeitsreduzierung im Vergleich zu herkömmlichen Komprimierungs- und Deduplizierungsmethoden eine Datengrößenreduzierung von 3:1 für Training erreicht.

Nach der Einrichtung des skalierbar Speichers besteht der nächste Schritt darin, diese Ressourcen in eine flexible hybride Cloud zu integrieren.

Hybride Cloud nutzen

Aufbauend auf skalierbar Speicher heben hybride Cloud die KI-Leistung auf die nächste Stufe, indem sie Kosten und Rechenanforderungen ausgleichen. Laut dem Flexera-Bericht"2024 State of the Cloud " verwenden 89 % der Unternehmen heute ein Multi-Cloud-Modell, wobei 73 % hybride Cloud einsetzen. Diese weit verbreitete Nutzung unterstreicht die praktischen Vorteile hybrider Ansätze für KI-Workloads.

Der Hauptvorteil? Finanzielle Flexibilität. Öffentliche Clouds sind ideal für variable oder saisonale Arbeitslasten - Sie zahlen nur für das, was Sie nutzen. In der Zwischenzeit können vorhersehbare, gleichbleibende Arbeitslasten auf privaten oder On-Premises Systemen bleiben, wo die Kosten stabiler sind. Diese Ausgewogenheit ist besonders nützlich für KI-Projekte, bei denen die Rechenanforderungen zwischen Training und Inferenz erheblich schwanken können.

Die Verteilung der KI-Arbeitslasten verschiebt sich. Im Jahr 2023 entfielen 80 % der Arbeitslasten auf Training , aber bis 2028 wird sich diese Aufteilung voraussichtlich auf 20 % Training und 80 % Inferenz umkehren, wobei bis 2025 eine ausgewogene 50:50-Verteilung erwartet wird. Das bedeutet, dass sich Ihre Infrastruktur an diese veränderten Muster anpassen muss, ohne dass eine komplette Überholung erforderlich ist.

Beispiele aus der Praxis zeigen die Vorteile der Hybrid Cloud:

- Walmart: Verwendet ein "Triple-Modell", das zwei öffentliche Cloud mit seiner privaten Cloud kombiniert, die über mehrere US-Regionen verteilt ist. Außerdem betreibt Walmart 10.000 Cloud in seinen Filialen und Clubs für skalierbar, niedrige Latenz an Kundeninteraktionspunkten.

- Netflix: Nutzt die öffentliche Cloud für die Verwaltung von Inhalten und die Verfolgung von Nutzer , während ein privates Cloud Content-Delivery-Netzwerk die Latenz für das Streaming reduziert.

Für KI-spezifische Vorteile sorgt die Cloud dafür, dass die Modelle auf die neuesten Daten zugreifen können, unabhängig davon, wo sie geografisch gespeichert sind.

Unternehmen können in der Cloud beginnen, die Kosten überwachen und die Arbeitslasten bei Bedarf On-Premises migrieren. Ein gängiger Richtwert ist die Verwendung von 60 % bis 70 % der Gesamtkosten für die Beschaffung von Systemen als Schwellenwert für die Entscheidung, wann Arbeitslasten verlagert werden sollen. Um informierte Entscheidungen zu treffen, sollten Sie den Bedarf an Daten und Modell-Hosting (in Gigabyte) im Verhältnis zur Anzahl der Transaktionen pro Sekunde, die ein einzelner Grafikprozessor bewältigen kann, verfolgen.

Eine schnelle und sichere Netzwerkanbindung ist auch für KI-Inferenzen unerlässlich. Cloud Adjacency - die Nähe Ihrer Systeme zu öffentlichen Clouds - kann Latenzzeiten reduzieren und die Leistung verteilter Anwendungen steigern.

"Durch den Einsatz eines hybriden Cloud für die Infrastruktur können wir bei Korrekturen an unseren Geschäftsmodellen, bei der Kostenbewertung und bei Entscheidungen darüber, wie KI-Technologien unseren Wettbewerbsvorteil ausbauen können, schnell vorwärts schreiten." - Liam Yu, Senior Product Solutions Marketing Manager, Integrated Systems bei Hitachi Vantara

"Die Hybrid Cloud ist die Grundlage für den globalen Zugriff auf verteilte unstrukturierte Dateidaten, die die Grundlage für den erfolgreichen Einsatz von KI im Unternehmen bilden. Ohne Zugriff auf alle unstrukturierten Daten können Sie den größtmöglichen Nutzen aus KI im Unternehmen ziehen. Und dieses Maß an sicherem, globalem Zugriff ist ohne hybride Cloud nicht zu erreichen." - Jim Liddle, Nasuni

Diese Infrastruktur bildet das Rückgrat für die schnelle Datenverarbeitung und Training , die KI erfordert.

Schritt 7: KI-gesteuerte Datenintelligenz hinzufügen

Sobald Sie eine skalierbar und automatisierte Dateninfrastruktur aufgebaut haben, ist es an der Zeit, die Dinge auf die nächste Stufe zu heben, indem Sie KI nutzen, um umsetzbare Erkenntnisse zu gewinnen. Mit Ihren High-Performance Speicher- und Computersystemen können Sie Ihre Daten mit Hilfe von KI in ein leistungsstarkes Werkzeug zur Beantwortung komplexer Fragen, zur Erkennung verborgener Muster und zur Erstellung präziser Vorhersagen verwandeln. Dieser Schritt verwandelt Ihre Infrastruktur in ein dynamisches System, das in der Lage ist, Erkenntnisse auf eine Weise zu gewinnen, die mit herkömmlichen Methoden nicht möglich ist.

KI-gestützte Analyseplattformen kombinieren Maschinelles Lernen, Verarbeitung natürlicher Sprache NLP) und fortschrittliches Datenmanagement , um die Fähigkeiten herkömmlicher Analysetools zu übertreffen. Diese Plattformen verarbeiten riesige Datensätze nahezu in Echtzeit und decken Zusammenhänge und Trends auf, für die menschliche Analysten Wochen brauchen würden.

Das herausragende Merkmal der KI-Analytik ist die Automatisierung. Von der Datenaufbereitung und -bereinigung bis hin zur Modellierung und Visualisierung erledigen diese Plattformen alles und liefern Erkenntnisse und umsetzbare Empfehlungen schneller als je zuvor.

KI-gestützte Analyseplattformen verwenden

KI-gestützte Plattformen sind so konzipiert, dass sie sowohl strukturierte Daten (wie Datenbanken) als auch unstrukturierte Daten (wie Beiträge social media , E-Mails, Bilder und Dokumente) verarbeiten können. Mit natürlichsprachlichen Fähigkeiten können Nutzer Fragen in einfachem Englisch stellen, und die Plattform übersetzt sie in SQL-Abfragen, extrahiert Bilddaten und generiert sofortige Visualisierungen und Erkenntnisse.

Nehmen Sie zum Beispiel die Actian Data Intelligence Platform. Sie nutzt Knowledge-Graph-Technologie und föderierte Governance, um den Datenzugriff zu demokratisieren und gleichzeitig strenge Compliance- und Sicherheitsmaßnahmen einzuhalten. Dieses Gleichgewicht ermöglicht es Unternehmen, KI-Initiativen zu skalieren, ohne die Kontrolle über sensible Daten zu verlieren.

Einer der größten Vorteile von KI-gesteuerten Abfragen ist ihre Fähigkeit, Erkenntnisse zu gewinnen, die nicht von den Annahmen der Datenwissenschaftler beeinflusst sind. Diese Tools enthalten oft vortrainierte Modelle für Maschinelles Lernen für Aufgaben wie Spracherkennung und Gefühlsanalyse, wodurch sie auch für nicht-technische Benutzer zugänglich sind. Achten Sie bei der Auswahl einer Plattform auf Funktionen wie robusteFähigkeiten abfragen natürlicher Sprache, nahtlose Integration mit Ihren bestehenden Datenquellen und Unterstützung für verschiedene Datenformate.

Connect Edge- und IoT

Edge AI bringt die Leistung der Analytik direkt an die Datenquelle. Anstatt IoT zur Verarbeitung in die Cloud zu schicken, ermöglicht Edge AI lokalen Geräten, Daten vor Ort zu verarbeiten und zu analysieren. Dieser Ansatz verringert die Latenzzeit, verbessert den Datenschutz und ermöglicht Entscheidungsfindung in Echtzeit in Bereichen wie Fertigung, autonome Fahrzeuge und Gesundheitsüberwachung.

Während zentralisierte Analysen tiefe Einblicke in große Datenmengen liefern, beschleunigt Edge AI die Entscheidungsfindung , indem sie die Informationen dort bereitstellt, wo sie am meisten benötigt werden - vor Ort.

Das Wachstumspotenzial in diesem Bereich ist enorm. Der Markt für Edge-KI, der im Jahr 2023 auf 14,8 Mrd. USD geschätzt wird, soll bis 2033 auf 163 Mrd. USD anschwellen. Ebenso wird erwartet, dass der Markt für IoT Geräte bis 2030 6,5 Milliarden Dollar erreichen wird. Die Fähigkeit, sofortige Entscheidungen auf der Grundlage lokaler Bedingungen zu treffen, ist ein entscheidender Vorteil, insbesondere in Umgebungen, in denen jede Millisekunde zählt.

Um Edge- und IoT erfolgreich zu integrieren, sollten Sie sich auf diese Schlüsselbereiche konzentrieren:

- Auswahl der Hardware: Wählen Sie Geräte auf der Grundlage ihrer Verarbeitungsleistung, Energieeffizienz und Kompatibilität mit Ihren Anforderungen. Mikrocontroller (MCUs) eignen sich hervorragend für einfachere Aufgaben, während Mikroprozessoren (MPUs) komplexere KI-Arbeitslasten bewältigen können.

- Modelloptimierung: Techniken wie Quantisierung und Pruning helfen bei der Anpassung von KI-Modellen an Edge-Geräte und stellen sicher, dass sie effizient bleiben, ohne die Genauigkeit zu beeinträchtigen.

- Sicherheitsmaßnahmen: Bevorzugen Sie sichere Boot-Prozesse, verschlüsselte Datenspeicherung und starke Authentifizierungsmethoden, um Geräte und Daten zu schützen. Die Erkennung von Anomalie und regelmäßige Firmware-Updates sind ebenfalls entscheidend für die Aufrechterhaltung der Sicherheit.

- Nahtlose Integration: Sorgen Sie für eine reibungslose Integration Ihrer Edge-Lösungen in Cloud und Unternehmensplattformen, um Scalability und Effizienz zu maximieren.

Energieeffizienz ist ein weiterer kritischer Faktor, wenn Unternehmen Tausende von Edge-Geräten einsetzen. Suchen Sie nach Lösungen, die ein Gleichgewicht zwischen Leistung und niedrigem Energieverbrauch herstellen, und ziehen Sie automatisierte Tools in Betracht, die die Deployment und Überwachung von Edge-KI-Systemen vereinfachen. Dies steigert nicht nur die Effizienz, sondern unterstützt auch die Bemühungen um Nachhaltigkeit, wenn Ihr Netzwerk wächst.

Schlussfolgerung: Aufbau einer zukunftssicheren Dateninfrastruktur

Die Schaffung einer auf KI zugeschnittenen Dateninfrastruktur ist die Grundlage für den langfristigen Erfolg Ihres Unternehmens. Die hier skizzierten sieben Schritte schaffen eine starke, einheitliche Grundlage die die Art und Weise, wie Ihr Unternehmen Daten sammelt, verwaltet und nutzt, neu gestaltet - von den ersten Schritten bis hin zu fortgeschrittenen KI-gestützten Erkenntnissen.

Durch die Kombination von Governance, Automatisierung und KI-gesteuerter Intelligenz können Unternehmen messbare Ergebnisse erzielen. So berichten Unternehmen mit ausgereifter Daten- und KI-Governance von finanziellen Leistungsverbesserungen zwischen 21 % bis 49 %. Darüber hinaus schätzt McKinsey, dass KI die Unternehmensgewinne um erstaunliche 4,4 Billionen Dollar jährlich. Diese Zahlen unterstreichen die Dringlichkeit für Unternehmen, in eine robuste Dateninfrastruktur zu investieren.

Dieser Ansatz führt zu einem flexiblen, modularen System, das sich an die sich entwickelnden KI-Technologien und die sich ändernden Geschäftsanforderungen anpassen kann. Flexibilität wird immer wichtiger, da der Markt für Datenintegration von 13,6 Mrd. US-Dollar im Jahr 2023 auf voraussichtlich 43,38 Mrd. US-Dollar im Jahr 2033 anwachsen wird.

"KI hat das Potenzial, unser gesamtes Leben zu verändern." - Jon Lin, Chief Business Officer, Equinix

Dieses Zitat verdeutlicht das transformative Potenzial der erörterten kohärenten Strategien. Durch die Konzentration auf Datenintegration, -qualität und -konformität vermeidet Ihr Unternehmen nicht nur kostspielige Ineffizienzen, sondern fördert auch die Innovation. Echtzeitüberwachung, automatisierte Governance und skalierbar Datenpipelines sorgen für einen reibungsloseren Betrieb und ebnen den Weg für bahnbrechende Fortschritte.

Diese KI-fähige Infrastruktur wird mehr als nur eine technische Plattform - sie entwickelt sich zu einem strategischen Vorteil. Sie beschleunigt die Entscheidungsfindung, senkt die Betriebskosten und stärkt die Compliance-Praktiken. Bedenken Sie: Mitarbeiter verbringen oft bis zu 30 % ihrer Zeit mit der Suche nach Daten und deren Aufbereitung. Mit automatisierten Workflows und einheitlichem Zugriff können Ihre Teams ihre Produktivität erheblich steigern und sich auf höherwertige Aufgaben konzentrieren.

Da KI zunehmend zu einem Eckpfeiler des Wettbewerbsvorteils in allen Branchen wird, stellt Ihre zukunftsorientierte Infrastruktur sicher, dass Ihr Unternehmen bereit ist, neue Chancen zu ergreifen. Gleichzeitig sorgt sie für die Sicherheit und Scalability , die für einen dauerhaften Erfolg erforderlich sind. Die Grundlagen, die Sie heute gelegt haben, stellen sicher, dass Ihre Dateninfrastruktur ein Katalysator für Wachstum bleibt und Ihr Unternehmen in einer KI-gesteuerten Zukunft florieren kann. Durch die Integration von skalierbar Systemen und automatisierten Prozessen verwandelt Ihr Unternehmen seine Daten in einen Motor für kontinuierlichen Fortschritt.

Häufige Fragen

Wie können Unternehmen bei der Vorbereitung auf die Einführung von KI sicherstellen, dass ihre Dateninfrastruktur mit Vorschriften wie HIPAA, SOX oder CCPA übereinstimmt?

Zur Einhaltung von Vorschriften wie HIPAA, SOXund CCPAmüssen sich Unternehmen auf starke Data Governance konzentrieren. Zu den wichtigsten Schritten gehören die Verwendung DatenverschlüsselungEinrichtung von Zugangskontrollenund die Durchführung regelmäßige Audits um sensible Informationen zu schützen. Um potenzielle Risiken zu verringern, muss sichergestellt werden, dass die internen Datenmanagement mit den gesetzlichen Vorschriften übereinstimmen.

Es ist auch wichtig, Datenanbieter sorgfältig zu prüfen, um sicherzustellen, dass sie die Compliance-Anforderungen erfüllen. Die Einbindung von automatisierter Tools für die Überwachung und Berichterstattung kann den Prozess der Einhaltung von Vorschriften bei gleichzeitiger Integration von KI-Lösungen vereinfachen. Durch die Einbettung dieser Maßnahmen in ihre Datensysteme können Unternehmen sicher sein, dass sie die gesetzlichen Anforderungen erfüllen und die mit der Einführung von KI verbundenen Risiken minimieren.

Welche Vorteile bietet die Verwendung einer hybriden Cloud für KI-Workloads, und wie lassen sich damit Leistung und Kostenmanagement verbessern?

Die hybride Cloud bietet einen intelligenten Weg zur verwalten KI-Workloads, da Unternehmen die richtige Umgebung für ihre Bedürfnisse wählen können - sei es On-Premises, in der öffentlichen Cloud oder in einer Kombination aus beidem. Dieses Setup hilft, sensible Daten zu schützen und gleichzeitig die Skalierbarkeit der Cloudfür ressourcenintensive KI-Aufgaben zu nutzen.

Mit KI-gesteuerten Tools können hybride Cloud Ressourcen automatisch anpassen basierend auf den Workload . Das bedeutet, dass Unternehmen eine hohe Leistung beibehalten können, ohne zu viel für ungenutzte Kapazitäten zu bezahlen. Außerdem können Workloads effizient verteilt werden, was eine hohe Verfügbarkeit und schnellere Verarbeitungsgeschwindigkeiten gewährleistet, ohne das Budget zu sprengen.

Kurz gesagt, die hybride Cloud bietet eine praktische Mischung aus Leistung, Kostenmanagement und Kontrolleund eignet sich daher hervorragend für KI-bezogene Projekte.

Wie verbessert KI-gestützte Datenintelligenz die herkömmliche Analytik und welche Vorteile bringt sie für die Aufdeckung von Erkenntnissen und die Erstellung von Prognosen?

KI-gestützte Datenintelligenz hebt die herkömmliche Analytik auf die nächste Stufe, indem sie Automatisierung mit kontinuierlichem Lernen kombiniert. Dieser Ansatz ermöglicht es Unternehmen, große Datenmengen schneller und präziser zu verarbeiten und das Risiko menschlicher Fehler und Verzerrungen zu verringern. Das Ergebnis? Erkenntnisse und Vorhersagen, auf die Sie sich verlassen können.

Zu den herausragenden Vorteilen gehören eine fundiertere Entscheidungsfindung, das frühzeitige Erkennen von Trends und Steigerung der betrieblichen Effizienz. Durch die Automatisierung von Routineaufgaben und das Erkennen von Mustern, die einer manuellen Analyse entgehen könnten, versetzt KI Unternehmen in die Lage, der Zeit immer einen Schritt voraus zu sein und selbstbewusst durch die sich verändernden Marktanforderungen zu navigieren.

Infrastruktur allein reicht nicht aus – Ihre Daten müssen auffindbar und aussagekräftig sein.

Erfahren Sie, wie die Data-Intelligence-Lösungen von Actian Ihre Daten von Grund auf AI-fähig machen.