Table des matières

Les bases de l'observabilité données

Qu'est-ce que Data observabilité?

L'impératif commercial de l'observabilité données

Le rôle technique de l'observabilité données

L'aspect humain des données : Personas d'utilisateur clés et leurs points de douleur

Cas d'utilisation de l observabilité données pour les organisations modernes

6 cas d'utilisation courante par les entreprises

- Services financiers : Gestion des risques et détection des fraudes

- Soins de santé : Sécurité des patients et excellence opérationnelle

- Commerce de détail et commerce électronique : expérience client Optimisation

- Fabrication : Optimisation de la production et contrôle de la qualité

- Télécommunications : Performance des réseaux et service à la clientèle

- Énergie et services publics : Surveillance des infrastructures et conformité réglementaire

8 Cas d'utilisation technique

- pipeline de données Surveillance et récupération automatisée

- Performance du modèle ML et détection de la dérive des données

- Conformité réglementaire et gouvernance données Automatisation

- Optimisation des coûts et gestion des ressources

- Evaluation de la qualité des données et gestion des SLA

- Réponse aux incidents et analyse des causes profondes

- Analyse de l'impact et de l'évolution des données

- Surveillance de la qualité des données

Les bases de l'observabilité données

L'importance des données n'a jamais été aussi grande. Les entreprises traitent et génèrent plus de données que jamais et prennent des décisions commerciales cruciales sur la base de ces données. Pour mieux comprendre ce phénomène, voici un aperçu complet de ce qu'est l'observabilité données et de ce que cela signifie de l'utiliser au quotidien.

Qu'est-ce que Data observabilité?

observabilité données est la capacité de comprendre la santé et l'état des données dans vos systèmes en mesurant la qualité, la fiabilité et la lignée. Elle vous permet d'être le premier à savoir quand : les données sont erronées, ce qui s'est casséet comment y remédier. Un système d'observabilité données sain assurera le bon fonctionnement de votre écosystème de données, en réduisant les problèmes et en améliorant la connaissance des données.

L'observabilité données est une approche holistique qui automatise l'identification et la résolution des problèmes liés aux données, simplifiant ainsi la gestion des systèmes de données et améliorant les performances. Elle englobe la compréhension et la gestion experte de la santé et de la performance des données, des pipelines et des processus métier critiques.

Parmi les principaux exemples deplateformes observabilité données, on peut citer : Acceldata, Actian Data observabilitéAnomalo, Bigeye, Datafold, Great Expectations, Monte Carlo et Soda.

Le contrôle des données, l'évaluation de la qualité et l'intégration avec votre écosystème de données existant sont essentiels à une stratégie de données complète et à la visibilité de l'entreprise. Une solution d'observabilité données dépourvue de cette vision holistique fournit un récit incomplet, limitant les informations que vous pouvez tirer de vos données.

L'impératif commercial de l'observabilité données

L'observabilité données est essentielle pour permettre aux organisations de prendre des décisions éclairées rapidement et efficacement. Les enjeux ne pourraient être plus élevés - Gartner estime que "jusqu'en 2025, au moins 30 % des projets d'IA seront abandonnés après la validation du concept en raison d'une d'une mauvaise qualité des donnéeset que "93 % des équipes ne parviennent pas à détecter les problèmes de données avant qu'ils n'aient un impact sur l'entreprise".

La plupart des organisations considèrent que leurs données ne sont pas fiables, et l'impact des données erronées ne doit pas être sous-estimé. En mai 2022, Unity Software a découvert qu'elle avait intégré des données erronées provenant d'un gros client, ce qui a entraîné une chute de 30 % du cours de l'action de l'entreprise et lui a finalement coûté 110 millions de dollars de pertes de revenus. Le coût de la correction des données erronées augmente de manière exponentielle à chaque étape de leur utilisation.

L'observabilité données est une couche stratégique essentielle pour toute organisation cherchant à maintenir sa compétitivité dans un monde axé sur les données. La capacité à agir rapidement sur la base de données fiables se traduit par une amélioration de l'efficacité opérationnelle, de meilleures relations avec les clients et une rentabilité accrue.

Le rôle technique de l'observabilité données

La fonction première de l'observabilité données est de faciliter l'exploitation fiable des données, et pas seulement de surveiller les données elles-mêmes. L'observabilité données se réfère à la pratique du contrôle, de la gestion et de la maintenance des données de manière à garantir leur qualité, leur disponibilité et leur fiabilité dans les différents processus, systèmes et pipelines au sein d'une organisation.

La réalisation des impératifs commerciaux de l'observabilité données repose en grande partie sur ces 4 Fonctionnalités techniques clés :

- Surveillance des données: Cette fonction est essentielle pour les applications qui nécessitent une action immédiate, telles que les systèmes de détection des fraudes , la gestion des interactions avec les clients et les stratégies de tarification dynamique.

- Détection et résolution automatisées des problèmes: Lesplateformes modernesplateformes observabilité données doivent gérer de grands jeux de données et support efficacement support détection d'anomalie complexes. Cette capacité est particulièrement vitale dans les secteurs de la vente au détail, de la finance et des télécommunications, où la capacité à détecter et à résoudre automatiquement les problèmes est nécessaire pour maintenir l'efficacité opérationnelle et la satisfaction des clients.

- Qualité et accessibilité des données: La qualité des informations est directement liée à la qualité des données ingérées et stockées dans les systèmes. S'assurer que les données sont exactes, propres et facilement accessibles est primordial pour l'efficacité de l'analyse, du reporting et de l'apprentissage modèles d'IA.

- Fonctionnalités avancées: Lesplateformes modernesplateformes observabilité données évoluent pour répondre aux nouveaux défis et aux nouvelles opportunités :

- pilotée par l’IA anomalie Detection: Tirer parti de l'apprentissage automatique pour identifier automatiquement des schémas inhabituels.

- Lignée de données de bout en bout: Permet une visibilité complète des flux de données et des dépendances.

- Analyse automatisée des causes profondes: Soutien au dépannage rapide et à la résolution des problèmes directement dans l'environnement d'observabilité .

L'aspect humain des données : Personas d'utilisateur clés et leurs points de douleur

L observabilité données présente des avantages considérables. Voici quelques exemples de personas et comment ils avantage de l'observabilité données.

- Ingénieurs de données qui sont responsables de la construction et de la maintenance de l'infrastructure de données et des pipelines qui alimentent les systèmes d'observabilité . Ils ont besoin d'une surveillance complète des pipelines de données afin d'identifier et de résoudre les problèmes de manière proactive avant qu'ils n'aient un impact sur les consommateurs en aval et les processus d'entreprise.

- Data Analysts qui se spécialisent dans le traitement et l'analyse des données afin d'en extraire des informations, en s'appuyant sur des données observables de haute qualité pour établir des rapports précis. Ils doivent être certains que les données qu'ils analysent sont exactes et à jour pour fournir des informations fiables aux parties prenantes sans remettre en question la qualité des données.

- Data Scientists qui utilisent des techniques d'analytique avancée et dépendent de données observables et de haute qualité pour l'apprentissage et le déploiement modèles. Ils ont besoin d'une visibilité sur la qualité et l'historique des données pour faire confiance aux jeux de données qui alimentent leurs modèles et comprendre quand la performance du modèle se dégrade en raison de problèmes liés aux données.

- Ingénieurs DevOps qui gèrent l'infrastructure technique soutenant lesplateformes observabilité données et assurent la fiabilité du système. Ils ont besoin de systèmes de surveillance et d'alerte qui les aident à maintenir l'infrastructure soutenant les opérations de données tout en garantissant un temps d'arrêt minimal et des performances optimales.

- Développeurs eninformatique décisionnelle (BI) qui créent des tableaux de bord et des rapports reposant sur des sources de données observables et fiables. Ils ont besoin d'outils d'observabilité données qui s'intègrent à leurs plateformes reporting afin de fournir des tableaux de bord précis et d'alerter les utilisateurs lorsque des problèmes de qualité des données risquent d'affecter leurs rapports.

- Responsables de la conformité qui veillent à ce que les pratiques de gestion des données soient conformes aux exigences réglementaires et avantage de l'observabilité dans le traitement des données. Ils ont besoin d'un suivi complet des données et de pistes d'audit jusqu'au niveau du terrain pour démontrer la conformité aux réglementations et répondre rapidement aux demandes de renseignements sur gouvernance données.

- les responsables informatiques qui supervisent l'infrastructure technologique et ont besoin de visibilité sur les performances et les coûts des solutions d'observabilité données. Ils ont besoin deplateformes observabilité données qui fournissent des mesures claires de retour sur investissement et aident à optimiser les coûts de l'infrastructure de données tout en maintenant des niveaux de service élevés.

- Les Chief Data Officers (CDO) qui dirigent la stratégie de données de l'entreprise et ont besoin d'une visibilité au niveau exécutif sur la santé des données dans l'ensemble de l'organisation. Ils ont besoin de mesures complètes sur la qualité des données, leur utilisation et leur impact sur l'entreprise pour démontrer la valeur de leurs investissements dans les données et identifier les domaines d'amélioration stratégique.

Cas d'utilisation de l observabilité données pour les organisations modernes

Dans cette section, nous présentons des cas d'utilisation courants pour les entreprises et les services informatiques.

6 cas d'utilisation courante par les entreprises

Cette section montre comment observabilité données soutient directement les objectifs et stratégies critiques de l'entreprise.

1. Services financiers : Gestion des risques et détection des fraudes

Améliore l'évaluation des risques et la prévention des fraudes en surveillant les schémas de transaction, la qualité des données et les paramètres de conformité réglementaire dans les...

Exemples :

- Banque: Détecter les anomalies dans les volumes et les modèles de transaction afin d'identifier les fraudes potentielles, tout en garantissant la conformité avec les réglementations anti-blanchiment d'argent grâce à un suivi complet de la traçabilité des données.

- Assurance: Contrôle de la qualité des données relatives aux sinistres et des délais de traitement afin d'identifier les schémas frauduleux et de garantir la précision des modèles d'évaluation des risques.

- Gestion des investissements: Suivi de la fraîcheur et de la qualité des données dans les flux de données du marché pour s'assurer que les décisions de gestion de portefeuille sont basées sur des informations précises et opportunes.

2. Soins de santé : Sécurité des patients et excellence opérationnelle

Permet un contrôle complet de la qualité des données des patients, des résultats des dispositifs médicaux et de l'efficacité du workflow clinique afin d'améliorer les résultats pour les patients et les performances opérationnelles.

Exemples :

- Hôpitaux: Contrôle de la qualité des données de l'enregistrement électronique de la santé (EHR) afin de garantir l'exactitude des informations sur les patients, le dosage des médicaments et les recommandations de traitement.

- Pharmaceutique: Suivi de l'intégrité des données des essais cliniques et de la conformité réglementaire tout au long des processus de développement des médicaments.

- Dispositifs médicaux: Veiller à ce que les données des capteurs IoT des équipements de surveillance des patients conservent leur précision et leur disponibilité pour les décisions de soins critiques.

3. Commerce de détail et commerce électronique : expérience client Optimisation

Améliore l'expérience client grâce au suivi des données clients, des niveaux de stock et des performances du moteur de recommandation. C'est l'équivalent d'un acheteur personnel qui ne dort jamais et qui s'assure en permanence que vos clients reçoivent les bons produits au bon moment.

Exemples :

- plateformes commerce électronique: Contrôle de la qualité des données du catalogue de produits, de l'exactitude des stocks et de la performance des algorithmes de recommandation afin d'éviter la déception des clients et la perte de ventes.

- Commerce de détail omnicanal: Assurer la cohérence données clients entre les points de contact en ligne, mobiles et en magasin pour des expériences d'achat transparentes.

- Chaîne d'approvisionnement: Suivi de la qualité des données d'inventaire et des indicateurs de performance des fournisseurs afin d'optimiser les niveaux de stock et d'éviter les ruptures de stock.

4. Fabrication : Optimisation de la production et contrôle de la qualité

Permet de connaître la qualité des données de production, les performances des équipements et l'efficacité de la Chaîne d'approvisionnement afin d'optimiser les processus de fabrication et de garantir la qualité des produits.

Exemples :

- Automobile: Contrôler les données des capteurs des lignes de production pour garantir les normes de contrôle de la qualité et prévoir les besoins de maintenance de l'équipement.

- Aérospatiale: Suivi des données de traçabilité des composants et des mesures de qualité tout au long du processus de fabrication afin de garantir la sécurité et la conformité aux réglementations.

- Biens de consommation: Analyse des modèles de données de production afin d'optimiser le traitement des lots et de réduire les déchets tout en maintenant les normes de qualité.

5. Télécommunications : Performance des réseaux et service à la clientèle

Aide les entreprises à gérer les données de performance du réseau, les modèles d'utilisation des clients et les mesures de qualité de service afin d'améliorer la fiabilité du réseau et la satisfaction des clients.

Exemples :

- Réseaux mobiles: Surveillance des données relatives à la qualité des appels, des mesures de performance du réseau et des habitudes d'utilisation des clients afin d'optimiser la capacité du réseau et de réduire les interruptions de service.

- Fournisseurs de services Internet: Suivi de l'utilisation de la bande passante, des données sur la disponibilité des services et des mesures de satisfaction de la clientèle afin d'améliorer la prestation des services.

- Communications d'entreprise: Garantir la qualité des données des communications unifiées et la disponibilité des systèmes pour assurer la continuité des activités.

6. Énergie et services publics : Surveillance des infrastructures et conformité réglementaire

Analyse les données relatives à la consommation d'énergie, les mesures de performance du réseau et les données relatives à la conformité environnementale afin de garantir la fiabilité de la prestation de services et le respect de la réglementation.

Exemples :

- Services d'électricité: Contrôle de la qualité des données des compteurs intelligents et des paramètres de performance du réseau pour optimiser la distribution d'énergie et prévoir les besoins de maintenance.

- Pétrole et gaz: Suivi des données des capteurs des pipelines et des informations de surveillance de l'environnement pour garantir la sécurité des opérations et le respect des réglementations.

- Énergies renouvelables: Analyse de la qualité des données météorologiques et des mesures de production d'énergie afin d'optimiser la production d'énergie renouvelable et l'intégration au réseau.

Ces cas d'utilisation montrent comment l observabilité données est devenue l'épine dorsale de la prise de décision fondée sur les données pour les organisations de tous les secteurs. À une époque où les données sont souvent appelées "le nouveau pétrole", l'observabilité données sert de raffinerie, transformant cette ressource brute en un carburant commercial à haut indice d'octane.

8 Cas d'utilisation technique

Vous êtes-vous déjà demandé comment les stratégies d'entreprise se transforment en réalité numérique ? Cette section lève le voile sur la magie technique de l'observabilité données. Nous explorerons huit cas d'utilisation qui montrent comment les technologies d'observabilité données transforment les visions d'entreprise en informations exploitables et en avantages concurrentiels.

1. pipeline de données Monitoring et récupération automatisée

Lesplateformes observabilité données surveillent les pipelines ETL/ELT complexes et peuvent récupérer automatiquement certains types de défaillances, offrant ainsi la résilience informatique nécessaire aux opérations de données critiques.

Caractéristiques principales :

- Surveillance de l'état des pipelines avec des alertes automatisées en cas d'échec des tâches, de dégradation des performances et de problèmes de qualité des données.

- Mécanismes de reprise automatisés pour les défaillances courantes du pipeline, y compris la logique de réessai et les sources de données de repli.

- Recommandations pour l'optimisation des performances basées sur l'historique des schémas d'exécution des pipelines et l'utilisation des ressources.

2. Performance du modèle ML et détection de la dérive des données

Les organisations utilisent l'observabilité données pour surveiller les entrées et sorties des modèles d'apprentissage automatique et d'IA, en détectant la dérive des données qui pourrait dégrader les performances du modèle au fil du temps.

Caractéristiques principales :

- Détection automatisée de la dérive des données à l'aide de méthodes statistiques pour identifier les changements dans la distribution des données d'entrée.

- Contrôle de la performance des modèles avec suivi de l'exactitude, de la précision, du rappel et des paramètres spécifiques à l'entreprise.

- observabilitéentrepôt de données garantissant une qualité de données cohérente pour l'apprentissage modèles et les pipelines d'inférence.

3. Conformité réglementaire et gouvernance données Automatisation

De nombreuses organisations tirent parti de l'observabilité données pour automatiser le contrôle de la conformité, en s'assurant que le traitement des données sensibles répond aux exigences réglementaires telles que GDPR, HIPAA et SOX. C'est comme si vous aviez un agent de conformité numérique qui ne dort jamais et qui détecte tous les problèmes de gouvernance données avant même que les auditeurs ne frappent à votre porte.

Caractéristiques principales :

- Rapports de conformité automatisés avec des modèles prédéfinis pour les frameworks réglementaires courants.

- Contrôle de la confidentialité des données y compris la détection des IPI, le suivi des accès et l'application de la politique de conservation.

- Génération de pistes d'audit avec enregistrement complet des accès aux données, des modifications et des exécutions de pipelines.

- Automatisation de l'application des politiques qui permet de bloquer ou de mettre en quarantaine les données qui violent les règles de gouvernance .

4. Optimisation des coûts et gestion des ressources

Facilite l'allocation intelligente des ressources et l'optimisation des coûts en surveillant les coûts de traitement des données, l'utilisation du stockage et l'efficacité du calcul dans l'infrastructure en nuage et sur site .

Caractéristiques principales :

- Tableaux de bord de l'utilisation des ressources qui fournissent une visibilité sur les coûts de calcul, de stockage et de réseau.

- Recommandations automatisées de mise à l'échelle basées sur les modèles de charge de travail et les exigences de l'entreprise.

- Détection des anomalie coûts qui identifie les pics inattendus dans les dépenses de traitement des données.

- Optimisation des coûts multi-cloud avec des recommandations pour le placement de la charge de travail chez différents fournisseurs de nuages.

5. Evaluation de la qualité des données et gestion des SLA

Les organisations mettent en œuvre des systèmes automatisés d'évaluation de la qualité des données qui mesurent la santé des données par rapport à des accords de niveau de service (SLA) prédéfinis et aux exigences de l'entreprise.

Caractéristiques principales :

- Evaluation automatisée de la qualité des données en utilisant des pondérations configurables pour les différentes dimensions de la qualité.

- Suivi desSLA ) et établissement de rapports avec des tableaux de bord montrant les performances par rapport aux paramètres convenus.

- Alerte proactive lorsque les scores de qualité des données sont inférieurs aux seuils acceptables.

- Analyse des tendances historiques pour identifier les schémas de dégradation et d'amélioration de la qualité des données.

6. Réponse aux incidents et analyse des causes profondes

Lesplateformes modernesplateformes observabilité données permettent la détection automatisée des incidents, le triage et l'analyse des causes profondes Fonctionnalités

Caractéristiques principales :

- Corrélation intelligente des incidents qui regroupe les problèmes connexes et identifie les causes profondes communes.

- Analyse d'impact automatisée montrant quels systèmes et utilisateurs en aval sont affectés par les problèmes de données.

- Gestion collaborative des incidents avec des outils de communication intégrés et l'automatisation des tâches.

- Analyse post-incident avec génération de rapports automatisés et recommandations d'amélioration des processus.

7. Analyse de l'impact et de l'évolution des données

Fournit un suivi complet des données et une analyse d'impact Fonctionnalités qui aident les organisations à comprendre les dépendances des données et à évaluer l'impact potentiel des changements.

Caractéristiques principales :

- Découverte automatisée de la lignée qui permet de cartographier les flux de données dans des écosystèmes de données complexes et multifournisseurs.

- Suivi de la lignée au niveau de la colonne montrant les transformations détaillées et les dépendances au niveau du champ.

- Analyse de l'impact des changements qui permet de prédire quels systèmes en aval seront affectés par les changements en amont.

- Intégration de glossaires professionnels relier les données techniques à la terminologie et aux définitions de l'entreprise.

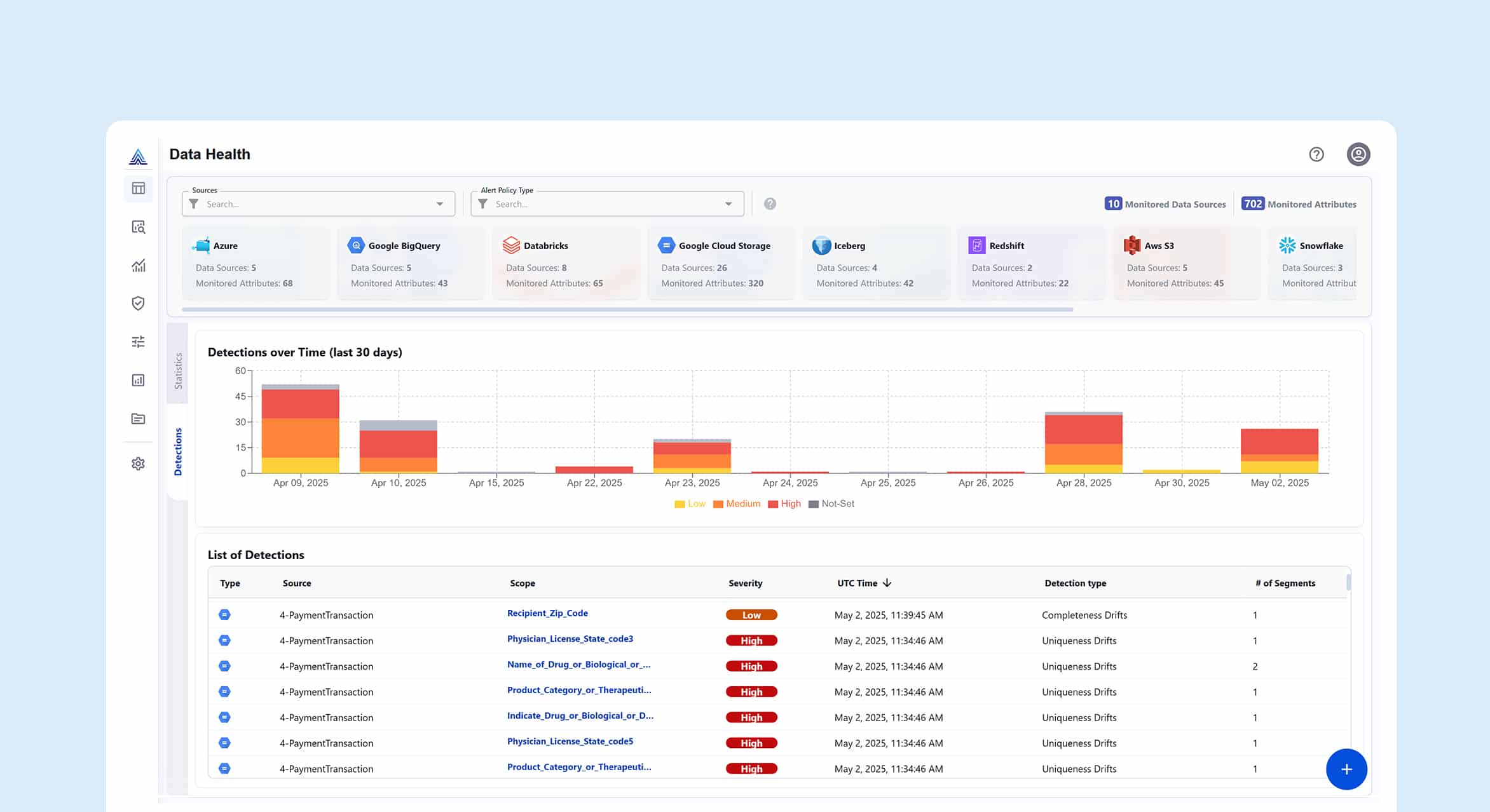

8. Contrôle de la qualité des données

Permet de surveiller en continu les mesures de qualité des données dans les systèmes de traitement streaming et par lots, offrant ainsi une visibilité sur l'état des données au fur et à mesure qu'elles circulent dans les pipelines.

Caractéristiques principales :

- détection desanomalie l'utilisation d'algorithmes d'apprentissage automatique pour identifier les problèmes de qualité dans les données streaming .

- Seuils de qualité configurables avec des règles spécifiques à l'entreprise pour différents types de données et cas d'utilisation.

- Intégration avec les catalogues de données pour mettre à jour automatiquement les métadonnées du patrimoine de données en fonction des résultats du contrôle de la qualité.

Les Fonctionnalités techniques abordées montrent que l observabilité données n'est pas seulement un atout, c'est une nécessité. Alors que les entreprises s'appuient de plus en plus sur les données pour la prise de décision et l'apprentissage, un cadre robuste d'observabilité données peut faire la différence dans la prise d'une bonne décision.

L'observabilité données est passée d'une capacité agréable à avoir à une base essentielle pour les opérations des entreprises modernes. Les entreprises s'appuient de plus en plus sur la prise de décision basée sur les données dans tous les aspects de leurs activités, et le coût des données non fiables est devenu prohibitif. Les entreprises ne peuvent plus se permettre le luxe d'une gestion réactive de la qualité des données, où les problèmes ne sont découverts qu'une fois qu'ils ont eu un impact sur les résultats de l'entreprise. L observabilité données offre la surveillance proactive, la détection automatisée des anomalie et la visibilité complète nécessaires pour protéger ces actifs critiques de l'entreprise. Les entreprises modernes qui ne mettent pas en œuvre desframeworks robustesframeworks observabilité données risquent de se laisser distancer par leurs concurrents qui peuvent prendre des décisions plus rapides et plus précises sur la base de données fiables.

Il est de plus en plus urgent d'adopter l'observabilité données à mesure que les organisations adoptent l'intelligence artificielle et l'apprentissage automatique. Les modèles d'IA ne sont fiables que dans la mesure où les données qui les alimentent le sont. L'observabilité données est donc essentielle pour prévenir la dérive des modèles, garantir la qualité des données d'apprentissage et maintenir des performances d'IA cohérentes dans les environnements de production. Alors que les volumes de données continuent d'exploser, avec création mondiale de données devrait passer de 33 zettaoctets en 2018 à 175 zettaoctets d'ici 2025, les approches de surveillance traditionnelles basées sur l'échantillonnage ne peuvent pas suivre. Les entreprises ont besoin de solutions d'observabilité données évolutif capables de surveiller 100 % de leurs données sans créer d'explosion des coûts de calcul ou de goulots d’étranglement en termes de performances.

C'est ici que Actian Data observabilité brille par sa conception pour répondre aux exigences opérationnelles des environnements de données modernes, en offrant une surveillance continue sur l'ensemble du cycle de vie des données. Elle offre une visibilité granulaire sur l'état des pipelines, l'évolution des schémas, les mesures de qualité des données et les performances de l'infrastructure dans les architectures hybrides et multiclouds, tout en sécurisant vos données en accédant aux métadonnées directement là où elles résident. Grâce à la détection intégrée des anomalie , à la traçabilité automatique et au diagnostic des causes profondes, Actian permet aux équipes chargées des données de détecter et de résoudre les problèmes avant qu'ils ne se propagent, ce qui réduit les temps d'arrêt et minimise l'impact en aval. Son architecture évolutif est conçue pour gérer des charges de travail à haut volume sans surcharge de calcul excessive, ce qui la rend idéale pour les organisations axées sur l'IA et l'analytique qui ont besoin d'une fiabilité totale des données à l'échelle de l'entreprise.

Faites l'expérience de l'observabilité données d'Actian avec une démo personnalisée.