Des données de qualité, une IA fiable : Présentation de l'observabilité données d'Actian

Emma McGrattan

12 mai 2025

Résumé

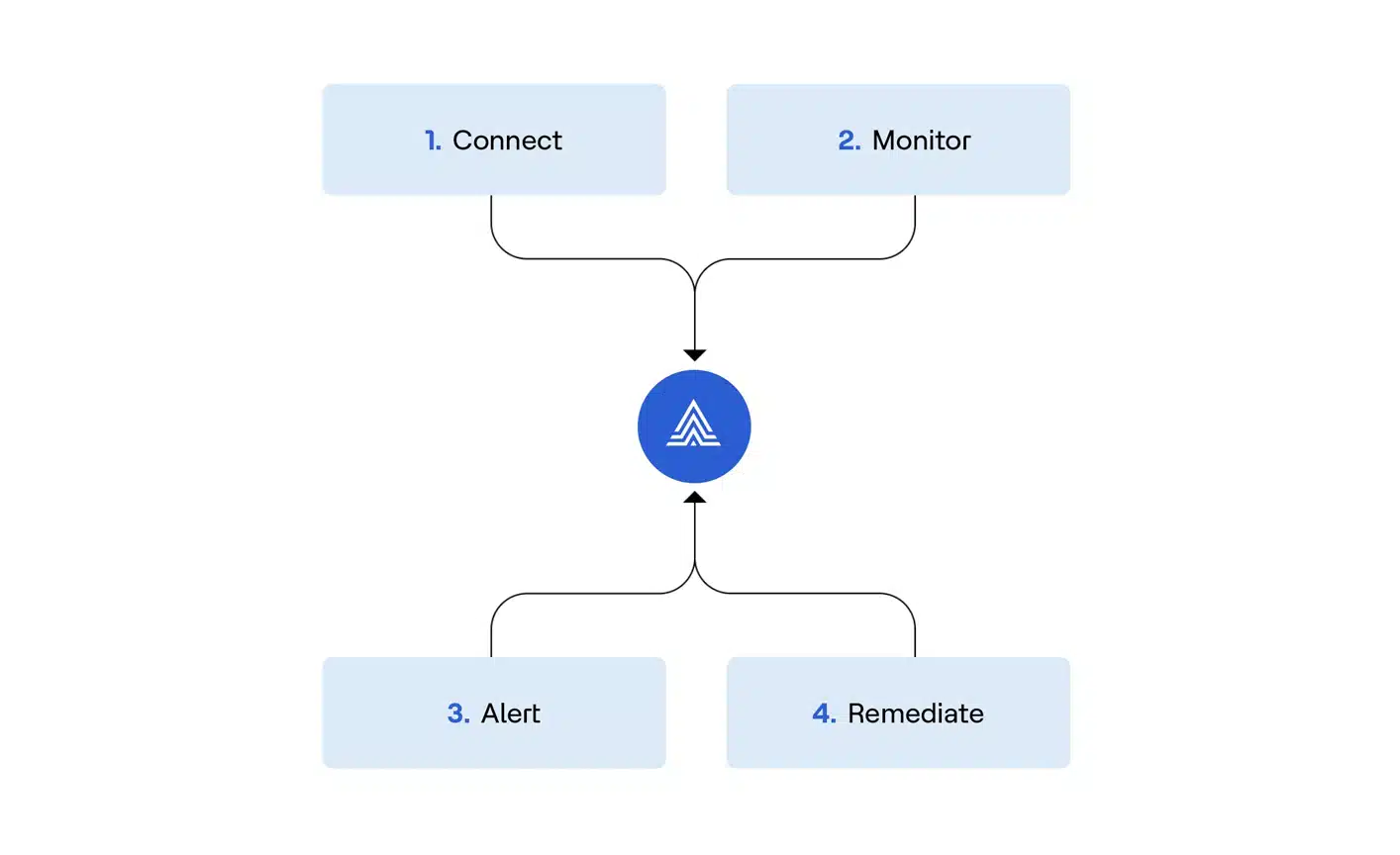

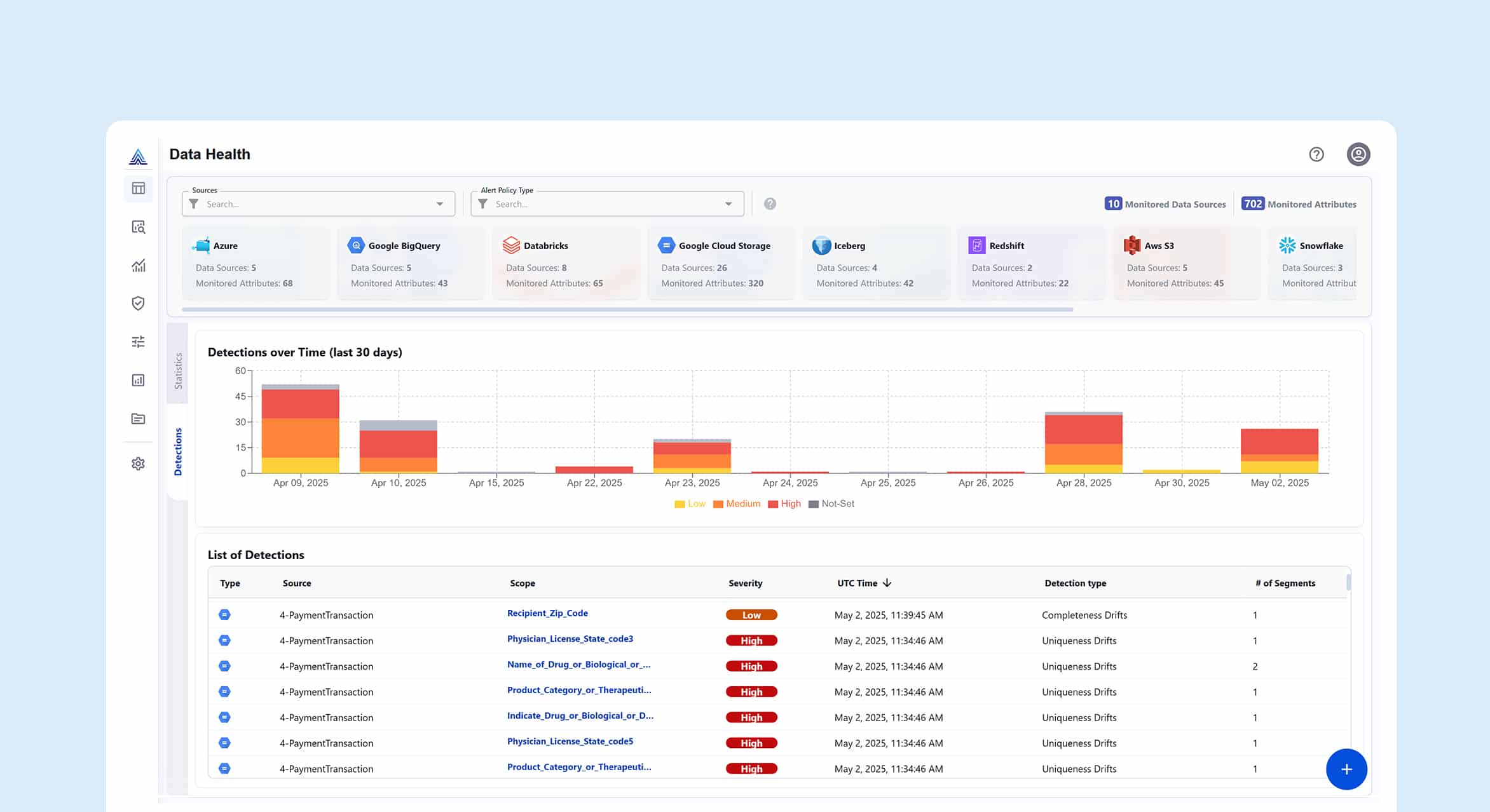

Ce blog présente la plateforme Data observabilité d'Actian - une solution proactive, pilotée par l’IA , conçue pour garantir la fiabilité des données, réduire les coûts du cloud et support IA fiable en surveillant 100 % des pipelines de données en temps réel.

- La surveillance proactive pilotée par l’IA permet de prévenir les problèmes liés aux données : La détection des anomalie par ML identifie la dérive des schémas, les valeurs aberrantes et les problèmes de fraîcheur à un stade précoce du pipeline, avant qu'ils n'aient un impact sur les systèmes en aval.

- Des coûts prévisibles avec une couverture complète des données : Contrairement aux outils basés sur l'échantillonnage, Actian traite chaque enregistrement données sur une couche de calcul isolée, ce qui permet d'assurer une montée en puissance sans coût et d'éviter les pics de facturation dans le nuage.

- Architecture flexible et ouverte pour les piles de données modernes : Prise en charge d'Apache Iceberg et intégration dans les lacs de données, les entrepôts de données et les entrepôts de stockage sans enfermement propriétaire ni dégradation des performances sur les systèmes de production.

Le coût réel de la qualité réactive des données

Gartner® estime que " D'ici 2026, 50 % des entreprises mettant en œuvre des architectures de données distribuées auront adopté des outils d'observabilité données pour améliorer la visibilité sur l'état du patrimoine de données, contre moins de 20 % en 2024 ". Mais l'observabilité données va au-delà de la surveillance - c'est un outil stratégique qui permet de renforcer la confiance dans les données tout en contrôlant les coûts croissants de la qualité des données dans l'ensemble de l'entreprise.

Aujourd'hui, la pile de données de l'entreprise est un patchwork d'anciennes et de nouvelles technologies, complexe, fragmenté et difficile à gérer. Au fur et à mesure que les données passent de l'ingestion au stockage, à la transformation et à la consommation, le risque d'échec se multiplie. Les méthodes traditionnelles ne peuvent plus suivre.

- Les équipes chargées des données perdent jusqu'à 40 % de leur temps à lutter contre les incendies au lieu de se concentrer sur la valeur stratégique.

- Les dépenses liées à l'informatique en nuage continuent d'augmenter, en raison d'approches inefficaces et réactives de la qualité des données.

- Les investissements dans l'IA ne sont pas à la hauteur lorsque les modèles sont construits sur des données peu fiables ou incomplètes.

- Les risques de non-conformité augmentent à mesure que les organisations n'ont pas la visibilité nécessaire pour tracer leurs données et s'y fier.

Les approches actuelles en matière de qualité des données sont figées dans le passé :

1. Le problème de l'héritage

Les méthodes traditionnelles de qualité des données ont conduit à une tempête parfaite d'inefficacité et d'angles morts. À mesure que les volumes de données augmentent, les entreprises se heurtent à la création manuelle de règles, ce qui oblige les ingénieurs à élaborer et à maintenir des milliers de contrôles de qualité dans des systèmes fragmentés. Le résultat ? Un processus à forte intensité de main-d'œuvre qui repose sur un échantillonnage sélectif et qui ne permet pas de détecter les problèmes critiques de qualité des données. Dans le même temps, la surveillance reste axée sur les paramètres d'infrastructure, tels que le processeur et la mémoire, plutôt que sur l'intégrité des données elles-mêmes.

Il en résulte une visibilité fragmentée, où les problèmes d'un système ne peuvent être reliés à ceux d'un autre système, ce qui rend l'analyse des causes profondes presque impossible. Les équipes chargées des données sont bloquées dans une boucle réactive, poursuivant les défaillances en aval au lieu de les prévenir à la source. Cette lutte constante contre les incendies érode la productivité et, plus important encore, la confiance dans les données qui sous-tendent les décisions clés de l'entreprise.

- Les vérifications manuelles basées sur des règles ne sont pas évolutives, ce qui laisse la plupart des jeux de données non surveillés.

- L'échantillonnage pour réduire les coûts introduit des angles morts qui mettent en péril des décisions cruciales.

- La surveillance de l'infrastructure seule ne tient pas compte de ce qui est le plus important : les données elles-mêmes.

- Les outils de surveillance déconnectés empêchent les équipes d'avoir une vue d'ensemble des pipelines.

2. L'hémorragie budgétaire cachée

Le passage à l'infrastructure de données en nuage devait permettre d'optimiser les coûts, mais les approches traditionnelles d'observabilité ont produit l'effet inverse. Alors que les équipes étendent la surveillance à l'ensemble de leur pile de données, les requêtes à forte intensité de calcul entraînent des pics de coûts imprévisibles sur les systèmes de production. La transparence des coûts étant limitée, il est pratiquement impossible de retracer les dépenses ou de planifier les budgets de manière efficace. Les coûts augmentent rapidement avec la montée en charge des données. Les entreprises sont confrontées à un choix difficile : réduire la surveillance et risquer des problèmes non détectés, ou maintenir la couverture et justifier l'escalade des dépenses liées à l'informatique dématérialisée auprès des responsables financiers. Cette imprévisibilité des coûts est aujourd'hui un obstacle majeur à l'adoption d'une observabilité données à l'échelle de l'entreprise.

- Un traitement inefficace entraîne des coûts de calcul et de stockage excessifs.

- La transparence limitée des coûts rend l'optimisation et la budgétisation difficiles.

- L'augmentation des volumes de données amplifie les coûts, ce qui fait de l'évolutivité une préoccupation croissante.

3. Le goulot d'étranglement de l'architecture

La plupart des solutions d'observabilité données créent des menottes architecturales qui limitent considérablement la flexibilité technique et l'évolutivité d'une organisation. Ces solutions sont généralement conçues comme des composants étroitement intégrés qui deviennent profondément Embarqué dans des plateformes cloud ou des technologies de données spécifiques, obligeant les organisations à s'engager à long terme auprès des fournisseurs et limitant les options d'innovation futures.

Lorsque les contrôles de qualité sont exécutés directement sur les systèmes de production, ils sont en concurrence avec les opérations principales de l'entreprise pour l'obtention de ressources critiques, ce qui entraîne souvent une dégradation importante des performances pendant les périodes de pointe, c'est-à-dire précisément au moment où la fiabilité est la plus importante. Les limites architecturales obligent les équipes chargées des données à développer des solutions de contournement complexes et personnalisées pour maintenir les performances, ce qui crée une dette technique et consomme des ressources d'ingénierie précieuses.

- Des solutions étroitement couplées qui vous enferment dans des plateformes spécifiques.

- Dégradation des performances lors de l'exécution des contrôles sur les systèmes de production.

- Utilisation inefficace des ressources nécessitant une ingénierie personnalisée.

Actian apporte une nouvelle approche de la fiabilité des données

L'observabilité données d'Actian représente un changement fondamental, passant d'une lutte réactive contre les incendies à une fiabilité proactive des données. Voici en quoi nous sommes différents :

1. Proactif, pas réactif

TRADITIONNELLE : Découvrir les problèmes de qualité des données après qu'ils aient eu un impact sur les décisions de l'entreprise.

MÉTHODE ACTIANE : pilotée par l’IA , la détection desanomalie permet d'identifier les problèmes dès le début du processus grâce à des connaissances fondées sur la ML.

2. Économie prévisible de l'informatique en nuage

TRADITIONNELLE : Des factures imprévisibles qui augmentent avec le volume de données.

LA VOIE ACTIENNE : Garantie d'absence d'augmentation des coûts grâce à une architecture efficace qui optimise la consommation des ressources.

3. Couverture complète, pas d'échantillonnage

TRADITIONNELLE : L'échantillonnage des données pour réduire les coûts, ce qui crée des zones d'ombre critiques.

LA VOIE ACTIENNE : Couverture de 100 % des données sans compromis grâce à un traitement intelligent.

4. Liberté architecturale

TRADITIONNELLE : enfermement propriétaire avec des options d'intégration limitées.

LA VOIE ACTIENNE : Architecture ouverte avec support native support Apache Iceberg et intégration transparente dans les piles de données modernes.

Impact dans le monde réel

cas d'usage 1 : pipeline de données Efficacité avec "Shift-Left"

Transformez vos opérations de données en détectant les problèmes à la source :

- Mettre en œuvre des contrôles DQ complets aux stades de l'ingestion, de la transformation et de la source.

- Intégrer les flux de travail CI/CD pour les pipelines de données.

- Réduire les coûts de reprise et accélérer la rentabilité.

cas d'usage 2 : Surveillance du cycle de vie de GénAI

Veillez à ce que vos initiatives en matière d'IA apportent une valeur ajoutée à l'entreprise :

- Valider la qualité des données d'apprentissage et les sources de connaissances RAG.

- Surveillez les hallucinations, les biais et la dérive des performances.

- Suivre les paramètres opérationnels du modèle en temps réel.

cas d'usage 3 : Safe libre-service Analytics

Donnez à votre organisation les moyens d'explorer les données en toute confiance :

- Embarquer indicateurs de santé des données en temps réel dans les catalogues et les outils bi

- Surveiller de manière proactive les habitudes d'utilisation du jeu de données .

- Instaurer la confiance par la transparence et la validation.

L'avantage Actian : Cinq facteurs de différenciation qui comptent

- Pas d'échantillonnage de données : 100% de couverture des données pour une observabilité complète.

- Pas de garantie d'augmentation des coûts de l'informatique en nuage : Des économies prévisibles à grande échelle.

- Architecture sécurisée sans copie : Accès aux métadonnées sans copie coûteuse des données.

- évolutif AI Workloads : ML Fonctionnalités conçues pour l'échelle de l'entreprise.

- Support native SupportApache Iceberg : observabilité inégalée des formats de tableaux modernes.

Commencer

Faites une visite guidée du produit et comprenez mieux comment transformer vos opérations de données d'un chaos réactif à un contrôle proactif.

S'abonner au blog d'Actian

Abonnez-vous au blogue d'Actian pour recevoir des renseignements sur les données directement à vous.

- Restez informé - Recevez les dernières informations sur l'analyse des données directement dans votre boîte de réception.

- Ne manquez jamais un article - Vous recevrez des mises à jour automatiques par courrier électronique pour vous avertir de la publication de nouveaux articles.

- Tout dépend de vous - Modifiez vos préférences de livraison en fonction de vos besoins.

S'abonner

(c'est-à-dire sales@..., support...).