Die Datenplattformarchitektur ist die grundlegende Struktur, die die Erfassung, Speicherung, Verarbeitung und Verwaltung von Daten in einem Unternehmen unterstützt. Was eine Datenplattform skalierbar macht, ist ihre Fähigkeit, als Reaktion auf steigende Datenanforderungen zu wachsen, ohne die Leistung oder Zuverlässigkeit negativ zu beeinflussen. Skalierbare Datenarchitekturen sind darauf ausgelegt, riesige Datenmengen effizient zu verarbeiten und einen reibungslosen Betrieb zu gewährleisten, auch wenn das Datenvolumen, die Komplexität und die Notwendigkeit einer breiteren Demokratisierung zunehmen.

Der Aufbau einer skalierbar Datenplattform ist entscheidend für das langfristige Wachstum eines jeden Unternehmens. Mit dem Wachstum von Unternehmen wächst auch die Menge der Daten, die sie verarbeiten, analysieren und speichern müssen. Ohne eine skalierbar Datenplattform-Architektur drohen Unternehmen Engpässe, Ineffizienzen und erhöhte Kosten. In der Tat haben viele der größten Unternehmen von heute - darunter Netflix, Amazon und LinkedIn - ihren Erfolg auf hoch skalierbar, belastbaren und effizienten Datenplattformen aufgebaut.

In diesem Artikel werden die entscheidenden Komponenten einer erfolgreichen, skalierbar Datenplattformarchitektur aufgeschlüsselt. Von der Wahl der richtigen Skalierungsstrategie bis hin zur Optimierung des Datenflusses bietet er umsetzbare Schritte, um sicherzustellen, dass die Datenplattform eines Unternehmens die aktuellen Anforderungen und das zukünftige Wachstum unterstützt.

Die Bedeutung von skalierbar Datenarchitekturen

Die digitale Landschaft entwickelt sich rasant, und Unternehmen in allen Branchen erzeugen täglich riesige Datenmengen. Ob es sich um Kundendaten im Einzelhandel, Patientenakten im Gesundheitswesen oder Finanztransaktionen im Bankwesen handelt, die Menge der zu verarbeitenden und zu speichernden Informationen nimmt ständig zu. Eine skalierbar Datenplattform stellt sicher, dass Unternehmen sowohl den aktuellen Anforderungen als auch den Herausforderungen von morgen ohne Systemeinschränkungen begegnen können.

Scalability ist von entscheidender Bedeutung, da Unternehmen neue Technologien wie künstliche Intelligenz (KI), Maschinelles Lernen (ML) und Advanced Analytics einführen, die alle große Datenmengen benötigen, um effektiv zu arbeiten. Die Fähigkeit, wachsende Datenmengen effizient zu verarbeiten, ermöglicht es Unternehmen, in einer data-driven Welt agil und wettbewerbsfähig zu bleiben.

Einbindung von Stakeholdern in den Designprozess

Der Aufbau einer effektiven Datenplattformarchitektur erfordert die Zusammenarbeit zwischen verschiedenen Abteilungen. Durch die Einbindung der wichtigsten Interessengruppen von Anfang an wird sichergestellt, dass die Architektur mit den Geschäftszielen übereinstimmt und die individuellen Bedürfnisse der verschiedenen Teams berücksichtigt.

- IT-Teams: Sicherstellen, dass die Datenplattform technisch solide ist und die Anforderungen an Scalability erfüllt.

- Business-Analysten: Bereitstellung von Erkenntnissen darüber, wie die Daten für die Entscheidungsfindung verwendet werden, und Sicherstellung, dass die Architektur Data Analytics unterstützt.

- Sicherheitsteams: Erstellung von Protokollen zum Schutz sensibler Informationen und zur Einhaltung von Datenschutzbestimmungen.

Die frühzeitige Einbindung dieser Interessengruppen hilft, potenzielle Herausforderungen zu erkennen und sicherzustellen, dass die Plattform den technischen und geschäftlichen Anforderungen entspricht.

Aufbau effizienter Daten-Pipelines für Scalability

Das Herzstück einer jeden skalierbar Datenplattform ist die Datenpipeline - das System, das den Datenfluss von der Aufnahme über die Umwandlung bis hin zur Speicherung verwaltet. Eine effiziente Pipeline stellt sicher, dass die Daten unabhängig vom Volumen nahtlos durch das System fließen.

Aufbau einer effektiven Pipeline:

- Automatisieren Sie den Dateneingang: Richten Sie einen automatischen Dateneingang aus mehreren Quellen ein, einschließlich Datenbanken, APIs und Streaming .

- Datenumwandlung und -bereinigung: Bereinigen und standardisieren Sie eingehende Daten, um Beständigkeit und usability zu gewährleisten. Durch die Automatisierung dieser Prozesse werden manuelle Eingriffe reduziert und die Scalability verbessert.

- Optimierung der Datenspeicherung: Speichern Sie Daten in Formaten, die für den jeweiligen Anwendungsfall optimiert sind, sei es in einer Cloud oder in On-Premises skalierbar Datenspeicherlösungen.

Eine gut konzipierte Datenpipeline stellt sicher, dass eine skalierbar Datenplattform steigende Arbeitslasten bei gleichbleibender Leistung und Zuverlässigkeit bewältigen kann.

Horizontale vs. vertikale Skalierung

Beim Entwurf einer skalierbar Datenbankarchitektur ist es wichtig, zwei grundlegende Skalierungsmethoden zu kennen: die horizontale Skalierung und die vertikale Skalierung. Diese Strategien bieten unterschiedliche Ansätze zur Erweiterung der Systemkapazität und -leistung.

Horizontale Skalierung

Dabei werden weitere Server (oder Knoten) zu einem System hinzugefügt, wodurch die Workload auf mehrere Rechner verteilt wird. Wenn die Daten wachsen, können neue Server nahtlos hinzugefügt werden, um die erhöhte Nachfrage zu bewältigen. Diese Methode wird häufig in Cloud Architekturen verwendet, da sie eine nahezu unbegrenzte Skalierung ermöglicht.

Vorteile:

- Einfach in Cloud zu implementieren.

- Ermöglicht eine nahezu unbegrenzte Scalability.

- Verringert das Risiko von Einzelausfällen (Single Points of Failure).

Vertikale Skalierung

Bei der vertikalen Skalierung wird die Leistung der bestehenden Infrastruktur durch die Aufrüstung von Hardwarekomponenten erhöht, z. B. durch Hinzufügen von mehr CPU, RAM oder Speicherplatz zu einem einzelnen Server. Die vertikale Skalierung ist zwar für bestimmte Arbeitslasten effektiv, hat aber ihre Grenzen, da nur eine bestimmte Menge aufgerüstet werden kann, bevor eine Obergrenze erreicht wird.

Vorteile:

- Einfach zu implementieren für kleinere Systeme.

- Die Anwendungen müssen nicht wesentlich geändert werden.

- Ideal für Workloads, die eine hohe Verarbeitungsleistung auf einzelnen Knoten erfordern.

Die Entscheidung zwischen horizontaler und vertikaler Skalierung hängt von den Anforderungen eines Unternehmens ab. Für die meisten Datenplattformen auf Unternehmensebene wird jedoch die horizontale Skalierung aufgrund ihrer Flexibilität und langfristigen Scalability bevorzugt.

Optimieren mit Datenpartitionierung, Sharding und Redundanz

Sobald sich ein Unternehmen für einen Skalierungsansatz entschieden hat, sind Datenpartitionierung, Sharding und Redundanz für die Optimierung der Leistung unerlässlich.

- Datenpartitionierung: Bei der Partitionierung werden große Datensätze in kleinere, überschaubare Teile unterteilt, die in der Regel auf logischen Gruppierungen wie Datumsbereichen oder Regionen basieren. Dies verbessert die abfragen und ermöglicht einen schnelleren Datenabruf durch Begrenzung des Suchumfangs.

- Sharding: Sharding geht noch einen Schritt weiter und verteilt die Daten auf mehrere Server. Jeder Shard ist eine unabhängige Datenbank, die eine Teilmenge der Daten enthält, was eine verbesserte skalierbar Datenverarbeitung und -speicherung ermöglicht. Diese Technik ist entscheidend für Anwendungen mit hohem Datenverkehr, da sie dazu beiträgt, die Last auf mehrere Server zu verteilen.

- Datenredundanz und -replikation: Um Datenverfügbarkeit und Fehlertoleranz zu gewährleisten, werden bei der Datenredundanz Informationen über mehrere Server oder Standorte hinweg repliziert. Wenn ein Server ausfällt, sorgen redundante Systeme dafür, dass die Daten zugänglich bleiben, um Serviceunterbrechungen zu vermeiden.

Durch den Einsatz von Partitionierung, Sharding und Redundanz können Unternehmen skalierbar Datenarchitekturen erstellen, die auch bei steigendem Datenvolumen eine hohe Leistung bieten.

Nutzung von Cloud und hybriden Lösungen

Im Zuge der zunehmenden digitalen Transformation von Unternehmen ist die Cloud zu einem wichtigen Instrument für die Scalability geworden. Cloud bieten On-Demand-Ressourcen, die sich automatisch an die Anforderungen einer Plattform anpassen können, wenn die Daten wachsen.

- Cloud Hyperscaler: Cloud wie AWS, Microsoft Azure, Actian DataConnect und Google Cloud bieten automatische Skalierungsfunktionen, die die Rechenleistung und den skalierbar Datenspeicher auf der Grundlage des Datenverkehrs und der Datenmengen anpassen. Dies macht manuelle Skalierungsmaßnahmen überflüssig und stellt sicher, dass die Plattform Nachfrageschwankungen bewältigen kann.

- Hybride Lösungen: Hybride Datenarchitekturen ermöglichen eine nahtlose Integration für Unternehmen, die eine Kombination aus On-Premises und Cloud benötigen. Daten können aus Compliance- oder Sicherheitsgründen lokal gespeichert werden, während die Scalability der Cloudfür die Verarbeitungsleistung genutzt wird.

Cloud bieten eine effiziente Möglichkeit, eine skalierbar Datenplattform aufzubauen und zu pflegen, ohne große Vorabinvestitionen in die Infrastruktur zu tätigen.

Sicherstellung von Leistung und Verfügbarkeit mit Lastenausgleich

Um eine optimale Leistung aufrechtzuerhalten, ist der Lastenausgleich entscheidend. Lastausgleicher verteilen den eingehenden Netzwerkverkehr auf mehrere Server, um sicherzustellen, dass kein einzelner Server überlastet wird, wodurch Engpässe vermieden und die Verfügbarkeit der Datenplattform verbessert werden.

- Dynamischer Lastenausgleich: Moderne Load Balancer nutzen Algorithmen, um die aktuelle Serverlast zu ermitteln und den Datenverkehr entsprechend zu lenken. Dies verhindert eine Überlastung des Systems und gewährleistet eine gleichbleibende Leistung.

- Failover-Schutz: Im Falle eines Serverausfalls können Load Balancer den Datenverkehr automatisch auf funktionierende Server umleiten und so die Unterbrechung minimieren.

Die Integration des Lastenausgleich in Ihre skalierbar Datenbankarchitektur gewährleistet, dass die Leistung auch bei steigender Nachfrage konstant bleibt.

Beispiele für die Architektur der skalierbar Datenplattform

Ein Verständnis dafür, wie erfolgreiche Unternehmen ihre skalierbar Datenplattformarchitekturen gestalten, kann wertvolle Erkenntnisse liefern. Nachfolgend finden Sie Beispiele für Architekturen von Unternehmen wie Netflix und Amazon, die zeigen, wie sie Scalability nutzen, um große Datenmengen zu verarbeiten.

1. Die skalierbar Microservices-Architektur von Netflix

Netflix ist bekannt für seine Microservices-basierte Architektur, die große Anwendungen in kleinere, unabhängige Prozesse aufteilt. Dadurch kann Netflix verschiedene Teile seiner Plattform je nach Bedarf skalieren, z. B. Nutzer , Streaming oder Inhaltsempfehlungsmaschinen. Jeder Microservice kann unabhängig bereitgestellt und horizontal skaliert werden.

Hier ist ein vereinfachtes Modell der Netflix-Architektur:

Diese Architektur ermöglicht es Netflix, bestimmte Dienste nach On Demand zu skalieren und so einen unterbrechungsfreien Service auch bei Spitzenauslastung zu gewährleisten.

2. Die E-Commerce-Architektur von Amazon

Die skalierbar Datenbankarchitektur von Amazon unterstützt die riesige E-Commerce-Plattform, über die täglich Millionen von Transaktionen abgewickelt werden. Amazon nutzt eine Kombination aus horizontaler Skalierung, Datenpartitionierung und Sharding, um seine Bestände, Kundenaufträge und Logistik effizient zu verwalten.

Hier sehen Sie eine Darstellung der Architektur von Amazon:

Diese Architektur ermöglicht es Amazon, die großen und dynamischen Arbeitslasten seiner E-Commerce-Plattform zu bewältigen, indem die Aufgaben auf viele kleinere Datenbanken verteilt werden.

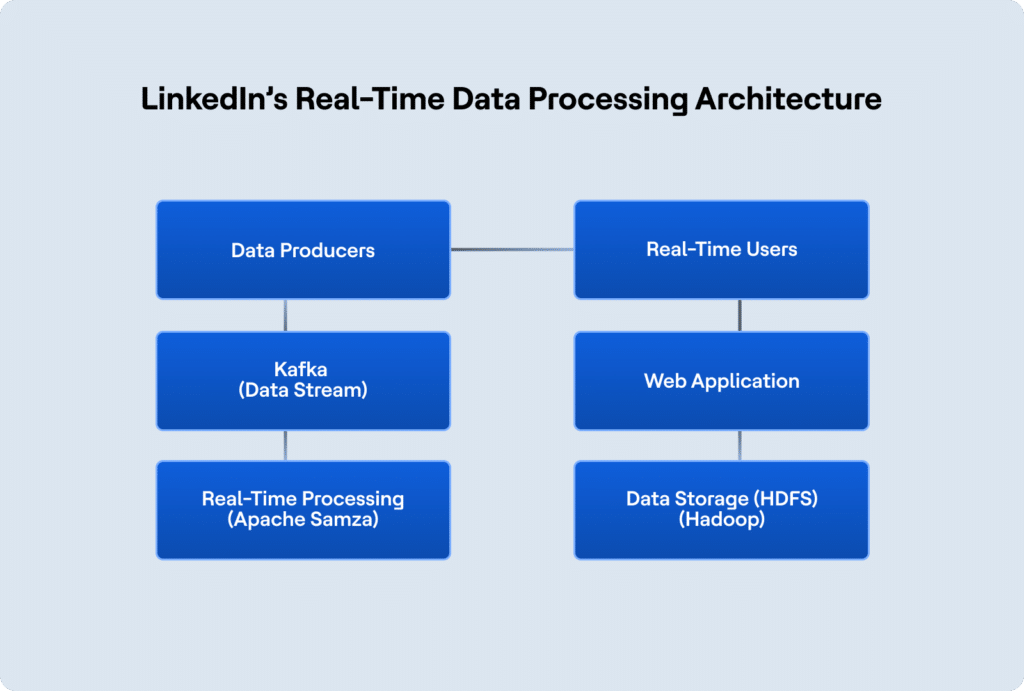

3. Die Echtzeit-Datenverarbeitungsarchitektur von LinkedIn

Die Architektur von LinkedIn ist darauf ausgelegt, großen Dateneingang und -verarbeitung in Echtzeit zu bewältigen und sicherzustellen, dass die Mitglieder Aktualisierungen (z. B. News-Feed-Posts und Jobempfehlungen) sofort erhalten. LinkedIn nutzt Apache Kafka für Streaming und Hadoop für die verteilte Datenspeicherung.

Hier sehen Sie, wie LinkedIn seine Datenplattformarchitektur strukturiert:

Diese Architektur ermöglicht es LinkedIn, Daten in Echtzeit zu verarbeiten und gleichzeitig sicherzustellen, dass die Plattform mit der wachsenden Zahl von Nutzern und Funktionen skaliert werden kann.

Actian und die Data Intelligence Plattform

Die Actian Data Intelligence Platform wurde speziell dafür entwickelt, Unternehmen bei der Vereinheitlichung, verwalten und dem Verständnis ihrer Daten in hybriden Umgebungen zu unterstützen. Sie vereint Metadaten , Governance, Lineage, Qualitätsüberwachung und Automatisierung in einer einzigen Plattform. So können Teams sehen, woher die Daten kommen, wie sie verwendet werden und ob sie internen und externen Anforderungen entsprechen.

Durch seine zentrale Schnittstelle unterstützt Actian Erkenntnis über Datenstrukturen und -flüsse und erleichtert so die Anwendung von Richtlinien, die Lösung von Problemen und die abteilungsübergreifende Zusammenarbeit. Die Plattform hilft auch dabei, Daten mit dem geschäftlichen Kontext zu verbinden, damit Teams Daten effektiver und verantwortungsvoller nutzen können. Die Plattform von Actian ist so konzipiert, dass sie mit sich entwickelnden Datenökosystemen skaliert und eine konsistente, intelligente und sichere Datennutzung im gesamten Unternehmen unterstützt. Fordern Sie Ihr persönliches Demo an.