Streaming de données en continu deviennent rapidement des outils essentiels pour les entreprises modernes qui ont besoin d'un traitement rapide et en temps réel des données. De nos jours, les entreprises reçoivent des données provenant de nombreuses sources différentes, allant des appareils mobiles aux services en nuage. pipeline destreaming efficaces les aident à recevoir les données cruciales et opportunes dont elles ont besoin pour assurer la réussite de leur entreprise. Des applications bancaires mobiles et GPS à la détection des fraudes en temps réel et aux cas d'utilisation de la maintenance prédictive, les organisations du monde entier s'appuient sur ces pipelines pour obtenir des informations et des actions opportunes qui stimulent leurs activités.

Dans ce guide complet, nous examinerons ce que sont les streaming pipelines de données en continu leur fonctionnement, leurs avantages, etc. Plongeons dans l'histoire.

Qu'est-ce qu'un pipeline de données Streaming ?

Unpipeline de données streaming est un système qui traite et transfère continuellement des données en en temps réel. Contrairement au traitement traditionnel par traitement par lots qui travaillent avec des jeux de données statiques, pipeline destreaming gèrent des données en mouvementLes pipelines de traitement en continu, qui effectuent des analyses des données en temps réel et des transformations au fur et à mesure que les données arrivent.

Ces pipelines capturent des données provenant de diverses sources, les traitent immédiatement et les livrent sans attendre la fin du processus de collecte des données. Streaming flux de données sont essentiels pour les entreprises qui ont besoin de données rapidement et qui ne peuvent pas se permettre d'attendre de longs délais de traitement.

Comment fonctionnent les pipelines de Streaming ?

Les données ont plusieurs points de contact lorsqu'elles transitent par pipeline destreaming s. Pour expliquer le fonctionnement de ces pipelines, voici comment les données circulent des sources aux utilisateurs finaux :

- Sources de données: Il s'agit notamment des appareils IoT, des applications, des sites web, des bases de données et des API tierces qui génèrent des flux de données continus.

- ingestion de données: Des outils comme Apache Kafka ingèrent des données streaming temps réel en les capturant et en les transférant vers le pipeline pour traitement.

- Analyse des données en temps réel: Il s'agit de transformer et d'analyser des données en en temps réel à l'aide de frameworks tels que Flink ou Spark Streaming.

- Stockage de données: Les données traitées sont souvent stockées dans des bases de données ou lacs de données afin de support analyses des données en temps réel et les requêtes futures.

- Consommateurs de données: Les données traitées sont mises à la disposition d'applications, de tableaux de bord, d'algorithmes d'apprentissage automatique ou d'autres utilisateurs qui les consomment en temps réel et les présentent aux responsables des données.

Pipelines de données Streaming vs. ETL traditionnel

Les processus traditionnels d'extraction, de transformation et de chargement (ETL) utilisent généralement traitement par lots. Les données sont collectées sur une période donnée, transformées et chargées dans un système cible. streaming revanche, les ETL en continu appliquent des transformations et chargent les données au fur et à mesure qu'elles sont produites, ce qui permet une analyse et une prise de décision immédiates. Cet aspect est essentiel pour des applications telles que les détecteurs de fraude financière, qui doivent traiter les données en quelques millisecondes plutôt qu'en quelques heures.

Avantages des pipelines de données Streaming

Streaming de données en continu offrent plusieurs avantages aux organisations qui ont besoin d'un traitement rapide et efficace des données. En voici cinq :

1. Amélioration de la prise de décision

Le pipeline deStreaming permettent d'informations en temps réel, ce qui permet aux entreprises de prendre des décisions fondées sur des données à la vitesse de l'activité. Par exemple, les institutions financières peuvent détecter les fraudes au fur et à mesure des transactions, évitant ainsi les pertes en temps en temps réel.

2. Réduction du temps de latence

En traitant les données au fur et à mesure qu'elles arrivent, pipeline destreaming réduisent considérablement le décalage entre la génération et la consommation des données. Cet aspect est crucial dans des secteurs tels que les soins de santé, où une seconde peut faire la différence entre la vie et la mort.

3. Agilité et évolutivité

Le pipeline deStreaming sont très évolutif en fonction des besoins de l'entreprise, ce qui permet de s'adapter facilement aux fluctuations des volumes de données. Qu'il s'agisse d'une poignée de sources de données ou de millions, les entreprises peuvent s'adapter aux fluctuations des volumes de données, cloud-native pipelines de données peuvent gérer la charge efficacement.

4. Tolérance de panne

La tolérance aux pannes est la capacité d'un système de données à continuer à fonctionner si l'une de ses parties tombe en panne. De nombreux outils de streaming , comme DataFlow - support tolérance aux pannes, de sorte que le pipeline continue de fonctionner sans heurts même en cas de défaillance d'un de ses composants.

5. Efficacité des coûts

Le traitement des données en temps réel permet aux entreprises d'identifier les inefficacités et d'optimiser leurs opérations en cours de route, ce qui se traduit par des économies au fil du temps. Le traitement de données plus petites en en temps réel peut également réduire le besoin de stockage plus important par rapport au traitement par lots.

Meilleures pratiques pour les architectures depipeline de données Streaming

La conception d'unpipeline de données performant commence par une architecture soigneusement élaborée. Voici quelques éléments à prendre en compte lors de la création d'une telle architecture :

Traitement Streaming ou traitement par lots

Alors que traitement par lots est utile pour certaines charges de travail analytiques, pipeline destreaming sont une excellente option lorsqu'un traitement de données faible latence est nécessaire. Toutefois, les architectures hybrides qui utilisent à la fois le traitement par lots et le streaming peuvent parfois constituer la meilleure approche en offrant les avantages de chacun.

gestion des données décentralisée gestion des données

Les architectures de streaming modernes avantage d'une approche décentralisée de la gestion des données. Au lieu de s'appuyer sur un entrepôt de données central, les organisations peuvent gérer et traiter les données en mouvement à travers différents lacs de données natifs du nuage pour une plus grande agilité.

Langages déclaratifs

L'utilisation de langages tels que SQL pour les streaming de données en continu simplifie leur conception et leur maintenance. Cette approche permet aux développeurs de se concentrer sur ce que sur ce que le pipeline doit faire plutôt que sur comment comment il doit être réalisé.

Intégration continue et livraison continue (CI/CD)

L'intégration de pipelines CI/CD dans les flux de données est cruciale pour maintenir une disponibilité et des performances élevées dans les pipelines de streaming. pipelines. Des tests réguliers, l'automatisation du déploiement et la surveillance garantissent que les modifications apportées au pipeline sont mises en œuvre de manière sûre et efficace.

Data gouvernance

La mise en œuvre de politiques de gouvernance données appropriées est essentielle pour garantir la qualité et la conformité des données. Lors de la création d'une architecture de gouvernance données qui comprend pipeline destreaming il est important de suivre le cheminement des données, de garantir la confidentialité et de respecter les lois sur la conformité des données.

Comment mettre en œuvre et intégrer des pipelines de données Streaming ?

Une fois que les organisations ont créé une architecture solide pour leurs pipelines, il est temps de les intégrer dans le système de données et de les faire travailler. Voici un guide étape par étape pour faciliter l l'intégration des données:

1. Évaluer l'infrastructure

Avant de mettre en place des pipelines, évaluez l'infrastructure actuelle pour vous assurer qu'elle est compatible avec les exigences du traitement des données en temps réel. Tenez compte de la capacité du réseau, des exigences en matière de stockage et de la capacité d'évolution.

2. Choisir les bons outils

Le choix de la bonne plateforme est essentiel pour la réussite du pipeline. Apache Kafka et Actian DataFlow sont des choix populaires, car ils offrent des fonctionnalités robustes pour le streaming, la tolérance aux pannes et l'évolutivité. Actian DataFlow, en particulier, fournit de puissantes analyses des données en temps réel et des Fonctionnalités mise en œuvre, ce qui facilite la gestion de flux de données complexes. flux de données complexes.

3. Normaliser le schéma

La normalisation du schéma de données garantit la cohérence des formats de données entre les différents systèmes, ce qui permet de réduire les erreurs et d'assurer une intégration harmonieuse entre les différentes parties du pipeline destreaming .

4. Surveillance et alertes en temps réel

Les pipelines deStreaming ont besoin d'une surveillance en temps réel pour détecter les goulots d’étranglement, les défaillances ou les problèmes de performance. Mettez en place des alertes qui informent les parties prenantes des problèmes potentiels avant qu'ils n'aient un impact sur la santé globale du pipeline.

5. déploiement

Enfin, déployer le pipeline destreaming à l'aide de services natifs dans le nuage ou de solutions sur site , en fonction des besoins de l'organisation. Veillez à ce que des processus CI/CD soient en place pour les mises à jour et la maintenance futures.

Défis communs et comment les surmonter

Construire et maintenir streaming de données en continu peuvent présenter des difficultés. Voici comment relever les défis les plus courants :

cohérence données

Il peut être difficile d'assurer la cohérence entre plusieurs systèmes de streaming , en particulier lorsqu'il s'agit de données distribuées. La mise en œuvre d'un traitement "exactly-once" et l'utilisation de modèles d'approvisionnement en événements peuvent aider.

Volumes de données élevés

La gestion de gros volumes de données en en temps réel peut surcharger les pipelines. Pour réduire le risque, utilisez le partage ou le partitionnement pour diviser les données en morceaux gérables et améliorer l'efficacité du traitement.

Exigences en matière de faible latence

Obtenir une faible latence peut être un défi, en particulier lorsque les données doivent traverser plusieurs systèmes. Optimisez le pipeline en utilisant des frameworks traitement in-memory comme Apache Flink et réduisez les sauts inutiles entre les systèmes.

Équilibrer les besoins de traitement

Certaines données nécessitent un traitement complexe, ce qui peut ralentir le pipeline. Pour équilibrer les performances, envisagez d'utiliser des architectures microservices pour répartir la charge de travail.

Cas d'utilisation Streaming pipeline de données Streaming réussi

Les donnéesStreaming se prêtent bien à une série de cas d'utilisation dans le monde réel. Il s'agit notamment de

Détecter plus rapidement les fraudes pour les services financiers

Les banques et les sociétés de traitement des paiements s'appuient fortement sur streaming de données en continu pour détection des fraudes et analyses des données en temps réel. En analysant les données des transactions au fur et à mesure qu'elles se produisent, institutions financières peuvent identifier et bloquer les activités frauduleuses.

Permettre le suivi des patients en temps réel dans le secteur de la santé

Dans le secteur secteur de la santé, le pipeline destreaming s permettent de surveillance des patients en temps réel en temps réel. Par exemple, les moniteurs de fréquence cardiaque et d'autres appareils IoT diffusent des données en continu vers des systèmes basés sur le cloud, où des algorithmes d'IA peuvent immédiatement détecter des anomalies et alerter le personnel médical.

Fournir des recommandations personnalisées dans le commerce de détail

Les détaillants utiliser pipeline destreaming pour alimenter moteurs de recommandations personnalisées aux clients. En analysant les habitudes d'achat et les préférences en en temps réel, des entreprises comme Amazon peuvent faire des suggestions instantanées de produits qui stimulent les ventes.

Actian et la plate-forme d'intelligence des données

Actian Data Intelligence Platform est conçue pour aider les entreprises à unifier, gérer et comprendre leurs données dans des environnements hybrides. Elle rassemble la gestion des métadonnées , la gouvernance, le lignage, le contrôle de la qualité et l'automatisation en une seule plateforme. Les équipes peuvent ainsi savoir d'où viennent les données, comment elles sont utilisées et si elles répondent aux exigences internes et externes.

Grâce à son interface centralisée, Actian offre une insight en temps réel des structures et des flux de données, ce qui facilite l'application des politiques, la résolution des problèmes et la collaboration entre les services. La plateforme aide également à relier les données au contexte commercial, ce qui permet aux équipes d'utiliser les données de manière plus efficace et plus responsable. La plateforme d'Actian est conçue pour s'adapter à l'évolution des écosystèmes de données, favorisant une utilisation cohérente, intelligente et sécurisée des données dans l'ensemble de l'entreprise. Demandez votre démo personnalisée.

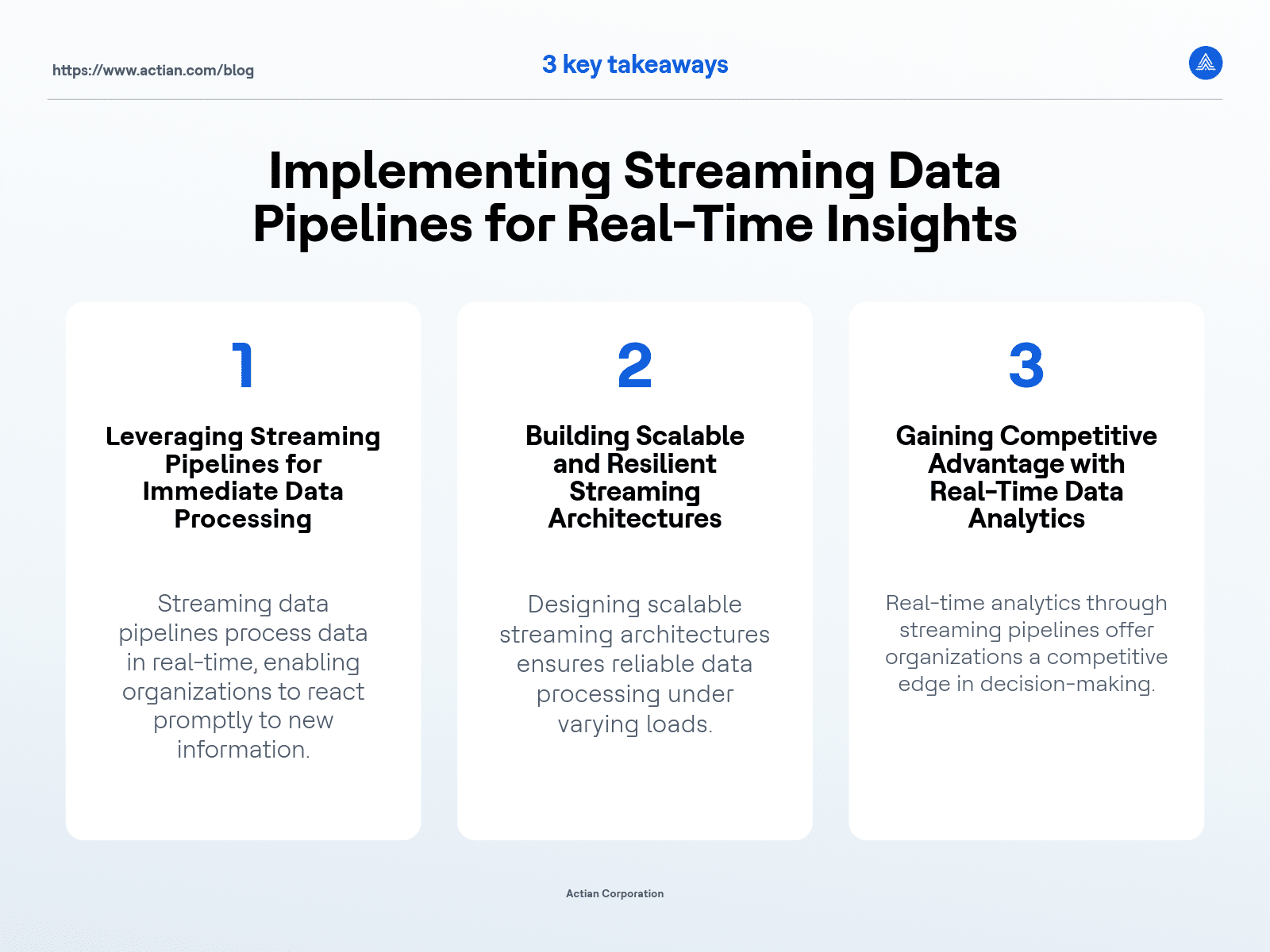

Principaux enseignements