Dateneingang ist der Prozess des Sammelns und Importierens von Daten aus verschiedenen Quellen in ein zentrales Lager zur Speicherung und Analyse. Er ist ein wichtiger Bestandteil jeder Datenmanagement , um sicherzustellen, dass Unternehmen über verschiedene Systeme hinweg effizient auf Daten zugreifen und diese nutzen können. Zu den wichtigsten Aspekten des Dateneingang gehören:

- Sammeln von Daten aus verschiedenen Quellen (Anwendungen, Cloud, Datenbanken, IoT usw.).

- Unterstützung für Batch- oder Echtzeit-Ingestion je nach Geschäftsanforderungen.

- Beständigkeit, -qualität und -sicherheit während des Ingestionsprozesses.

- Integration von Daten in nachgelagerte Systeme zur Analyse oder operativen Nutzung.

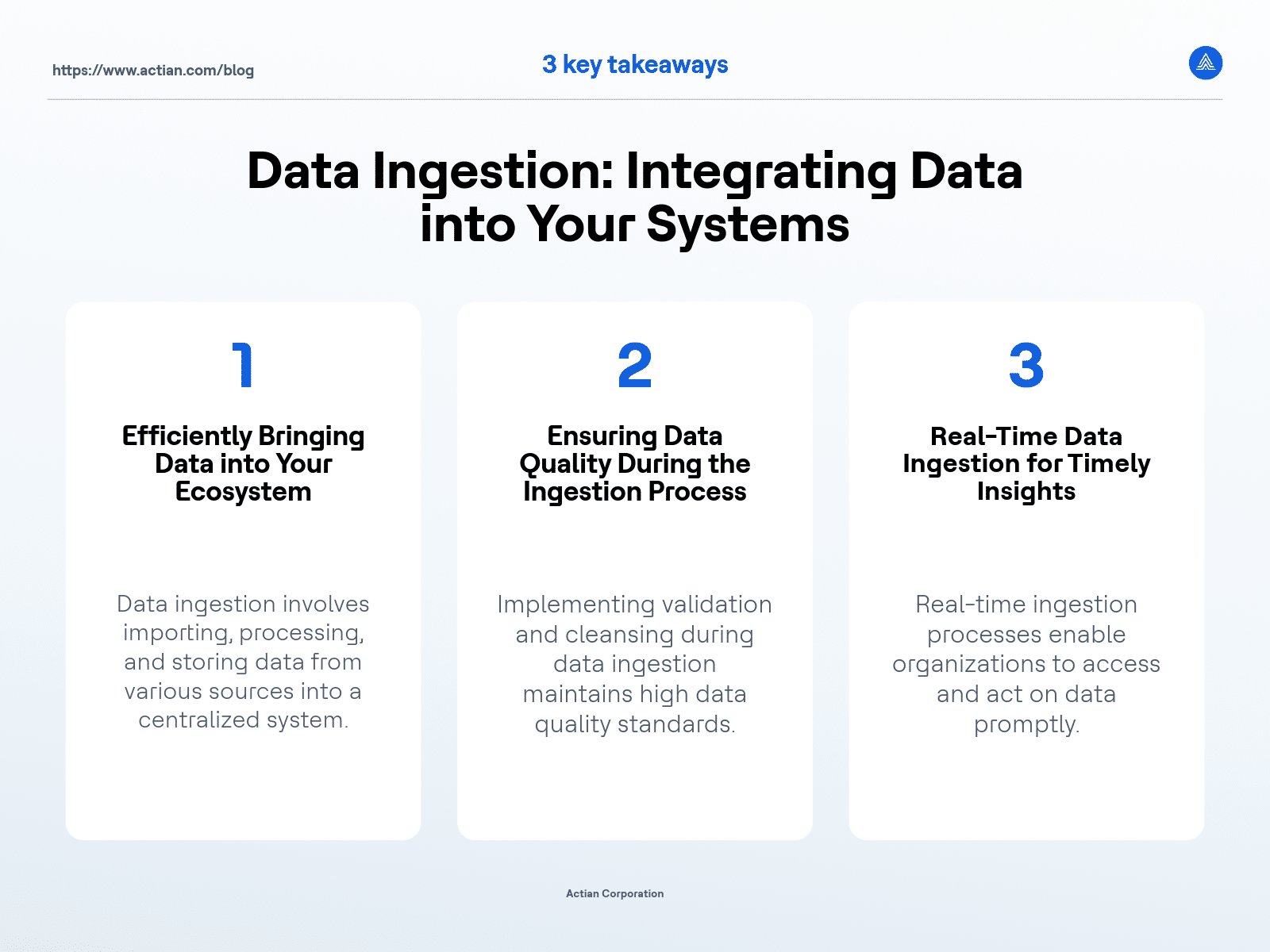

Was ist Data Ingestion?

Dateneingang ist für jedes moderne Unternehmen, das sich bei der Entscheidungsfindung auf Daten stützt, unerlässlich. In seiner einfachsten Form ist er der erste Schritt beim Verschieben von Daten aus verschiedenen Quellen in eine zentralisierte Datenplattform zur Speicherung, Verarbeitung oder Analyse. Unabhängig davon, ob es sich bei der Quelle um eine Cloud, eine On-Premises oder eine IoT handelt, stellt der Dateneingang sicher, dass die Informationen ordnungsgemäß formatiert und organisiert werden, damit sie später in einer Datenpipeline.

Ohne adäquaten Dateneingang stehen Unternehmen vor vielen Herausforderungen, von unvollständigen Datensätzen bis hin zu ineffizienter Verarbeitung, die die Analyse verzögern kann. Die Flexibilität bei der Aufnahme von Daten in großem Umfang - ob in Echtzeit oder durch Stapelverarbeitung - wirkt sich direkt auf die Fähigkeit eines Unternehmens aus, wettbewerbsfähige Erkenntnisse zu gewinnen und seine Abläufe zu optimieren.

Wo der Dateneingang in der Datenpipeline liegt

Der Dateneingang bildet die grundlegende Schicht der Datenpipelinedie Daten von den Quellen zu den Repositories transportiert, wo sie analysiert oder gespeichert werden können. Innerhalb der breiteren Pipeline ist der Dateneingang der Prozess, der sicherstellt, dass alle relevanten Daten aus verschiedenen Eingängen in einem konsistenten und nutzbaren Format in ein System gebracht werden.

In einer typischen Datenpipeline folgt auf die Aufnahme der Daten eine Datentransformation. Die aufgenommenen Daten werden bereinigt, formatiert und angereichert, bevor sie in einem Data Warehouse, Daten-Lake oder einem anderen Speichersystem gespeichert oder in eine Zielanwendung übertragen werden. Von dort aus können sie verarbeitet, abgefragt oder zur Gewinnung von Erkenntnissen durch Analysetools verwendet werden. Ohne einen angemessenen Dateneingang kann die gesamte Datenpipeline zusammenbrechen und zu Verzögerungen, unvollständigen Datensätzen oder Fehlern in der Geschäftsberichterstattung führen.

Arten von Dateneingang

Je nach Geschwindigkeit und Häufigkeit der Dateneingang gibt es zwei Hauptformen des Dateneingang :

Charge Dateneingang

Bei dieser Methode werden die Daten in regelmäßigen Abständen gesammelt und verarbeitet. Sie ist ideal für Unternehmen, die keine Aktualisierungen in Echtzeit benötigen, z. B. Unternehmen, die nächtliche Berichte erstellen oder große Mengen an historischen Daten verarbeiten.

Dateneingang

Wie der Name schon sagt, nimmt diese Methode Daten auf, sobald sie erstellt werden, und bietet nahezu sofortige Aktualisierungen. Die Aufnahme von Daten in Echtzeit ist für Anwendungen wie die Betrugserkennung, bei der sofortige Maßnahmen auf der Grundlage der neuesten Daten erforderlich sind, unerlässlich.

Die Entscheidung zwischen Batch- und Echtzeit-Ingestion hängt davon ab, wie die Daten verwendet werden. Die meisten Unternehmen verwenden jedoch eine Kombination aus beidem, je nach den spezifischen Datenströmen, um die es geht.

Methoden des Dateneingang

Verschiedene Dateneingang können angewandt werden, um unterschiedliche Geschäftsanforderungen kennenlernen . WelchesFramework letztendlich verwendet wird, hängt von den Datenquellen und den Anforderungen eines Unternehmens an die Dateneingabe ab. Nachfolgend finden Sie eine Aufschlüsselung der gängigen Dateneingang :

- Ingestion durch Parameter: Diese Methode ermöglicht den Dateneingang auf der Grundlage vordefinierter Parameter, wie Zeitintervalle oder bestimmte Auslöser. Ein Unternehmen kann zum Beispiel Parameter festlegen, so dass die Verkaufsdaten alle 24 Stunden aufgenommen werden.

- Einlesen von Array-Daten: Das Einlesen von strukturierten Array-Daten - wie Tabellen oder Matrizen - beinhaltet in der Regel die Verarbeitung mehrerer Zeilen und Spalten von Informationen. Dies wird üblicherweise bei der Übernahme von Datenbanken oder Tabellenkalkulationen verwendet.

- Aufzeichnung Entry: Diese im Bankwesen und bei Finanzdienstleistungen übliche Methode nimmt einzelne Transaktionsdatensätze auf, sobald sie generiert werden. Aufgrund des kritischen Charakters der Daten ist für diese Systeme in der Regel eine Erfassung in Echtzeit erforderlich.

- Aufzeichnung Ingestion: Viele Unternehmen verlassen sich auf die Aufnahme von Daten aus flachen Dateien - wie CSV oder JSON - die strukturierte oder halbstrukturierte Daten speichern. Diese Methode wird häufig für die Aufnahme archivierter Daten verwendet.

- Ingesting von Cloud : Mit dem Aufkommen des Cloud Computing ist die direkte Aufnahme von Daten aus Cloud Diensten oder Anwendungen üblich geworden.Dateneingang umfasst die Erfassung von Daten aus Cloud wie AWS oder Google Cloud und unterstützt häufig die Datenintegration für weitere Analysen.

- Ingesting von Handels- und Spieldaten: Beide Branchen sind in hohem Maße auf Dateneingang angewiesen. Eine Aktienhandelsplattform kann beispielsweise Echtzeit-Marktdaten aufnehmen, um Preise sofort zu aktualisieren, während Spieleplattformen Interaktionsdaten von Spielern erfassen, um UX und Personalisierung zu verbessern.

- Ingesting von Datenbankeinträgen: Bei der Übernahme von Daten aus relationalen oder nicht-relationalen Datenbanken werden Daten aus mehreren Tabellen abgerufen, um sicherzustellen, dass die Daten konsistent und aktuell sind. Dies kann je nach den Anforderungen des Systems entweder im Stapel oder in Echtzeit erfolgen.

- Einspeisung von Daten in eine Datenbank: Für viele Unternehmen ist das Ziel für die aufgenommenen Daten eine Datenbank. Dieser Prozess beinhaltet die Umwandlung von Rohdaten in strukturierte Formate, die effizient organisiert werden können.

- Streaming Dateneingang: Diese Methode wird verwendet, wenn Daten kontinuierlich erzeugt werden und in Echtzeit verarbeitet werden müssen. Unternehmen können zum Beispiel Apache Kafka verwenden, um kontinuierliche Ströme von Protokolldaten, Aktualisierungen social media oder Sensordaten zu verarbeiten.

- Dateneingang: Mit der zunehmenden Verbreitung von IoT wird die Erfassung von Daten aus Sensoren, Geräten und Anwendungen immer wichtiger. IoT Dateneingang ermöglicht es Unternehmen, Gerätedaten in Echtzeit zu erfassen und zu analysieren, um Einblicke in den Maschinenzustand, den Energieverbrauch oder das Nutzer zu erhalten.

Herausforderungen und bewährte Praktiken beim Dateneingang

Was wäre der Dateneingang trotz seiner Bedeutung ohne seine Herausforderungen? Um einen effizienten, genauen und skalierbar Dateneingang zu gewährleisten, müssen mehrere Hürden genommen werden:

- Beständigkeit: Bei der Arbeit mit multiple data kann es schwierig sein, die Konsistenz der Daten zu gewährleisten, vor allem wenn sie in Echtzeit aufgenommen werden.

- Verarbeitung in Echtzeit: Da der Bedarf an sofortigen Erkenntnissen wächst, kann der Dateneingang in Echtzeit die Systemressourcen belasten und Änderungen der Infrastruktur erfordern, um kontinuierliche Datenströme zu verarbeiten.

- Datenqualität: Die Aufnahme von Rohdaten führt häufig zu Inkonsistenzen oder unvollständigen Datensätzen und kann auch zu unnötigen Kosten aufgrund der Verarbeitung nicht benötigter oder ungenauer Daten führen. Die Implementierung geeigneter Bereinigungs- und Validierungsprozesse ist entscheidend.

Bewährte Praktiken für einen erfolgreichen Dateneingang umfassen:

- Verwendung von Datenintegrationsplattformen, die die Aufnahme von Daten aus verschiedenen Quellen rationalisieren.

- Vorrangige Scalability , um zu gewährleisten, dass der Ingestionsprozess bei wachsendem Datenvolumen und zunehmender Komplexität größere Mengen effizient verarbeiten kann.

- Implementierung von Überwachungssystemen zur Erkennung von Engpässen oder Fehlern während des Ingestionsprozesses.

Wenn Unternehmen diese Praktiken befolgen, können sie sicherstellen, dass ihre Ingestionsprozesse effizient, zuverlässig und skalierbar sind.

Die Rolle der Datenintegration bei der Vereinfachung der Datenübernahme

Datenintegration ist entscheidend für die Vereinfachung des Ingestionsprozesses, indem Daten aus verschiedenen Quellen in einem einheitlichen System kombiniert werden. Für Unternehmen, die multiple data verarbeiten - z. B. Cloud, IoT und Datenbanken - beseitigt ein integrierter Ansatz für den Dateneingang Silos und verbessert die Datenverfügbarkeit im gesamten Unternehmen.

Mit einer Datenintegrationsplattform auf Unternehmensebene kann ein Unternehmen zum Beispiel die Aufnahme von Daten aus Cloud und internen Datenbanken automatisieren und so eine nahtlose Datenpipeline. Integrationsplattformen können auch die Umwandlung von Daten übernehmen, um sicherzustellen, dass sie das erforderliche Zielformat einhalten. Dies beschleunigt den Aufnahmeprozess und stellt sicher, dass die Daten einheitlich formatiert, bereinigt und für die Analyse bereit sind.

Die Datenintegration ist das Rückgrat eines gut optimierten Ingestionsprozesses, der die Komplexität der Verwaltung verschiedener Datenströme reduziert und eine rechtzeitige und genaue Datenlieferung gewährleistet.

Actian und die Data Intelligence Plattform

Die Actian Data Intelligence Platform wurde speziell dafür entwickelt, Unternehmen bei der Vereinheitlichung, verwalten und dem Verständnis ihrer Daten in hybriden Umgebungen zu unterstützen. Sie vereint Metadaten , Governance, Lineage, Qualitätsüberwachung und Automatisierung in einer einzigen Plattform. So können Teams sehen, woher die Daten kommen, wie sie verwendet werden und ob sie internen und externen Anforderungen entsprechen.

Durch seine zentrale Schnittstelle unterstützt Actian Erkenntnis über Datenstrukturen und -flüsse und erleichtert so die Anwendung von Richtlinien, die Lösung von Problemen und die abteilungsübergreifende Zusammenarbeit. Die Plattform hilft auch dabei, Daten mit dem geschäftlichen Kontext zu verbinden, damit Teams Daten effektiver und verantwortungsvoller nutzen können. Die Plattform von Actian ist so konzipiert, dass sie mit sich entwickelnden Datenökosystemen skaliert und eine konsistente, intelligente und sichere Datennutzung im gesamten Unternehmen unterstützt. Fordern Sie Ihr persönliches Demo an.

Wichtigste Erkenntnisse