La arquitectura de la plataforma de datos es la estructura fundamental que soporta la recopilación, el almacenamiento, el procesamiento y la gestión de datos dentro de una organización. Lo que hace que una plataforma de datos sea escalable es su capacidad para crecer en respuesta a las crecientes demandas de datos sin afectar negativamente al rendimiento o la fiabilidad. Las arquitecturas de datos escalables están diseñadas para gestionar cantidades masivas de datos de forma eficiente, garantizando un funcionamiento sin problemas a medida que aumentan el volume de données, la complejidad y la necesidad de una mayor democratización.

Crear una plataforma de datos escalable es crucial para respaldar el crecimiento a largo plazo de cualquier empresa. A medida que las organizaciones crecen, también lo hace el volumen de datos que deben manejar, analizar y almacenar. Sin una arquitectura de plataforma de datos escalable, las empresas se enfrentan a cuellos de botella, ineficiencias y mayores costes. De hecho, muchas de las mayores empresas actuales, como Netflix, Amazon y LinkedIn, han construido su éxito sobre plataformas de datos altamente escalables, resistentes y eficientes.

Este artículo desglosa los componentes críticos que conforman una arquitectura de plataforma de datos exitosa y escalable. Desde la elección de la estrategia de escalado adecuada hasta la optimización de los flujos de datos, proporcionará medidas prácticas para garantizar que la plataforma de datos de una organización satisface las necesidades actuales y el crecimiento futuro.

La importancia de las arquitecturas de datos escalables

El panorama digital evoluciona rápidamente y las empresas de todos los sectores generan grandes cantidades de datos a diario. Ya se trate de datos de clientes en el comercio minorista, historiales de pacientes en la sanidad o transacciones financieras en la banca, el volumen de información que debe procesarse y almacenarse no deja de crecer. Una plataforma de datos escalable garantiza que las empresas puedan hacer frente tanto a las demandas actuales como a los retos del mañana sin limitaciones del sistema.

La escalabilidad es crucial a medida que las empresas adoptan nuevas tecnologías como la inteligencia artificial (IA), el aprendizaje automático (ML) y analytique avancée , todas las cuales requieren grandes cantidades de datos para funcionar con eficacia. La capacidad de gestionar eficientemente volúmenes de datos cada vez mayores permite a las organizaciones seguir siendo ágiles y competitivas en un mundo impulsado por los datos.

Participación de las partes interesadas en el proceso de diseño

Crear una arquitectura de plataforma de datos eficaz requiere la colaboración de varios departamentos. Implicar a los principales interesados desde el principio garantiza que la arquitectura se alinee con los objetivos empresariales y aborde las necesidades específicas de los distintos equipos.

- Equipos de TI: Garantizar que la plataforma de datos es técnicamente sólida y cumple los requisitos de escalabilidad.

- Analistas de negocio: Aportar ideas sobre cómo se utilizarán los datos para la prise de décision, garantizando que la arquitectura sea compatible con el análisis de datos.

- Equipos de seguridad: Establecer protocolos para proteger la información sensible y garantizar el cumplimiento de la normativa de protección de datos.

El compromiso temprano con estas partes interesadas ayuda a identificar posibles retos y garantiza que la plataforma cumpla los requisitos técnicos y empresariales.

Creación de canalizaciones de datos eficientes para la escalabilidad

En el corazón de cualquier plataforma de datos escalable se encuentra pipeline de données , el sistema que gestiona el flujo de datos desde la ingesta hasta la transformación y el almacenamiento. Una canalización eficiente garantiza que los datos circulen sin problemas por el sistema, independientemente de su volumen.

Construir una cadena de suministro eficaz:

- Automatice la ingesta de ingestion de données: Configure la ingestion de données automática ingestion de données desde múltiples fuentes, incluidas bases de datos, API y datos de flujo en tiempo real.

- Transformación y limpieza de datos: Limpie y estandarice los datos entrantes para garantizar la cohérence y la facilidad de uso. La automatización de estos procesos reduce la intervención manual y mejora la escalabilidad.

- Optimización del almacenamiento de datos: Almacene los datos en formatos optimizados para los casos de uso, ya sea en una arquitectura de datos en la nube o en soluciones de almacenamiento de datos escalables sur site .

Un pipeline de données bien diseñado garantiza que una plataforma de datos escalable pueda gestionar cargas de trabajo cada vez mayores manteniendo el rendimiento y la fiabilidad.

Escalado horizontal frente a vertical

A la hora de diseñar una arquitectura de base de datos escalable, es esencial comprender dos métodos de escalado fundamentales: el escalado horizontal y el escalado vertical. Estas estrategias ofrecen distintos enfoques para ampliar la capacidad y el rendimiento del sistema.

Escala horizontal

Esto implica añadir más servidores (o nodos) a un sistema, lo que distribuye la carga de trabajo entre varias máquinas. A medida que crecen los datos, pueden añadirse sin problemas nuevos servidores para gestionar el aumento de la demanda. Este método se utiliza popularmente en arquitecturas basadas en la nube, ya que permite un escalado casi ilimitado.

Ventajas:

- Fácil de implantar en entornos de nube.

- Permite una escalabilidad casi infinita.

- Reduce el riesgo de puntos únicos de fallo.

Escala vertical

El escalado vertical aumenta la potencia de la infraestructura existente mediante la actualización de componentes de hardware, como la adición de más processeur, RAM o almacenamiento a un único servidor. Aunque es eficaz para cargas de trabajo específicas, el escalado vertical tiene sus límites, ya que no se puede ampliar todo lo que se quiera antes de llegar a un tope.

Ventajas:

- Fácil de implantar en sistemas pequeños.

- No es necesario modificar las aplicaciones de forma significativa.

- Ideal para cargas de trabajo que requieren una gran capacidad de procesamiento en nodos individuales.

La elección entre escalado horizontal y vertical depende de las necesidades de cada organización. Sin embargo, para la mayoría de las plataformas de datos empresariales, el escalado horizontal es preferible por su flexibilidad y escalabilidad a largo plazo.

Optimización con partición de datos, fragmentación y redundancia

Una vez que una organización selecciona un enfoque de escalado, la partición de datos, la fragmentación y la redundancia se convierten en elementos esenciales para optimizar el rendimiento.

- Partición de datos: La partición divide los grandes conjuntos de datos en partes más pequeñas y manejables, normalmente basadas en agrupaciones lógicas como intervalos de fechas o regiones. Esto mejora el rendimiento de las consultas y permite una récupération des données más rápida récupération des données al limitar el alcance de las búsquedas.

- Sharding: La fragmentación va un paso más allá al distribuir los datos entre varios servidores. Cada fragmento es una base de datos independiente que contiene un subconjunto de los datos, lo que permite mejorar la escalabilidad del procesamiento y almacenamiento de datos. Esta técnica es fundamental para aplicaciones con mucho tráfico, ya que ayuda a equilibrar las cargas entre varios servidores.

- Redundancia y replicación de datos: Para garantizar la disponibilidad de los datos y la tolerancia a fallos, la redundancia de datos replica la información en varios servidores o ubicaciones. Si falla un servidor, los sistemas redundantes garantizan que los datos sigan siendo accesibles, evitando interrupciones del servicio.

Aprovechando la partición, la fragmentación y la redundancia, las organizaciones pueden crear arquitecturas de datos escalables que mantengan un alto rendimiento aunque aumente volume de données .

Aprovechar los servicios en la nube y las soluciones híbridas

A medida que las empresas avanzan hacia una mayor transformación digital, la arquitectura de datos en la nube se ha convertido en una herramienta esencial para la escalabilidad. Los servicios en la nube ofrecen recursos bajo demanda que pueden ajustarse automáticamente para satisfacer las necesidades de una plataforma a medida que crecen los datos.

- Hiperescaladores basados en la nube: Las plataformas en la nube como AWS, Microsoft Azure, Actian DataConnect y Google Cloud ofrecen funciones de autoescalado que ajustan la potencia informática y el almacenamiento de datos escalable en función del tráfico y los volúmenes de datos. Esto elimina la necesidad de esfuerzos manuales de escalado y garantiza que la plataforma pueda hacer frente a las fluctuaciones de la demanda.

- Soluciones híbridas: Las arquitecturas de datos híbridas permiten una integración perfecta para las empresas que necesitan una combinación de infraestructura sur site y en la nube. Los datos pueden almacenarse localmente por motivos de seguridad o cumplimiento de normativas, al tiempo que se aprovecha la escalabilidad de la nube para la potencia de procesamiento.

Las soluciones en la nube ofrecen una forma eficaz de crear y mantener una plataforma de datos escalable sin una inversión inicial significativa en infraestructura.

Garantizar el rendimiento y la disponibilidad con équilibrage de charge

Para mantener un rendimiento óptimo, el équilibrage de charge es crucial. Los equilibradores de carga distribuyen el tráfico de red entrante entre varios servidores para garantizar que ninguno se sature, evitando cuellos de botella y mejorando la disponibilidad de la plataforma de datos.

- équilibrage de charge dinámico: Los equilibradores de carga modernos utilizan algoritmos para evaluar la carga actual del servidor y dirigir el tráfico en consecuencia. Esto evita sobrecargar el sistema y garantiza un rendimiento constante.

- Protección contra fallos: En caso de fallo de un servidor, los equilibradores de carga pueden redirigir automáticamente el tráfico a servidores que funcionen, minimizando las interrupciones.

La incorporación équilibrage de charge a su arquitectura de base de datos escalable garantiza que el rendimiento se mantenga estable a medida que aumenta la demanda.

Ejemplos de arquitectura de plataformas de datos escalables

Entender cómo las organizaciones de éxito diseñan sus arquitecturas de plataformas de datos escalables puede aportar información valiosa. A continuación se presentan ejemplos reales de arquitecturas utilizadas por empresas como Netflix y Amazon, que muestran cómo aprovechan la escalabilidad para gestionar grandes volúmenes de datos.

1. La arquitectura de microservicios escalable de Netflix

Netflix es conocida por su arquitectura basada en microservicios, que divide las grandes aplicaciones en procesos más pequeños e independientes. Esto permite a Netflix escalar diferentes partes de su plataforma según sea necesario, como la autenticación de usuarios, el streaming de vídeo o los motores de recomendación de contenidos. Cada microservicio puede desplegarse de forma independiente y escalarse horizontalmente.

He aquí un modelo simplificado de la arquitectura de Netflix:

Esta arquitectura permite a Netflix escalar servicios específicos en à la demande, garantizando un servicio ininterrumpido incluso durante los picos de uso.

2. Arquitectura de comercio electrónico de Amazon

La arquitectura de base de datos escalable de Amazon soporta su amplia plataforma de comercio electrónico, que gestiona millones de transacciones diarias. Amazon utiliza una combinación de escalado horizontal, partición de datos y fragmentación para gestionar eficazmente su inventario, los pedidos de los clientes y la logística.

He aquí una representación de la arquitectura de Amazon:

Esta arquitectura permite a Amazon gestionar las grandes y dinámicas cargas de trabajo de su plataforma de comercio electrónico distribuyendo las tareas entre muchas bases de datos más pequeñas.

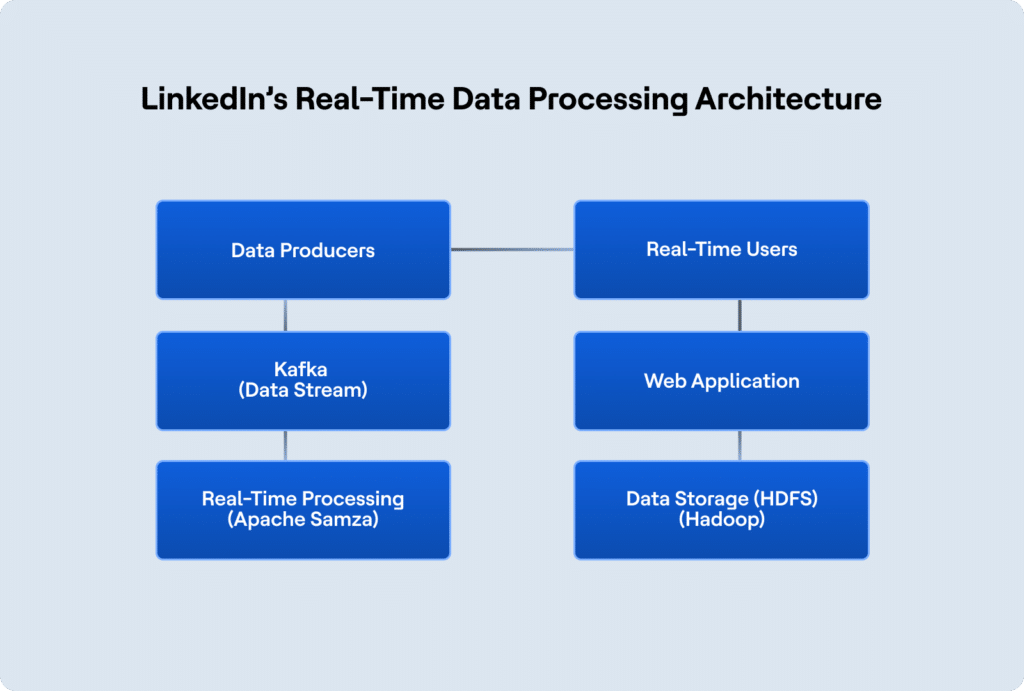

3. Arquitectura de procesamiento de datos en tiempo real de LinkedIn

La arquitectura de LinkedIn está diseñada para gestionar ingestion de données a gran escala y su procesamiento en tiempo real, garantizando que los miembros reciban las actualizaciones (como las publicaciones de noticias y las recomendaciones de trabajo) al instante. LinkedIn utiliza Apache Kafka para el flujo de datos en tiempo real y Hadoop para el almacenamiento de datos distribuidos.

Así es como LinkedIn estructura la arquitectura de su plataforma de datos:

Esta arquitectura permite a LinkedIn gestionar el procesamiento de datos en tiempo real, al tiempo que garantiza que la plataforma pueda escalar con el creciente número de usuarios y funciones.

Actian y la plataforma de inteligencia de datos

Actian Data Intelligence Platform está diseñada para ayudar a las organizaciones a unificar, gestionar y comprender sus datos en entornos híbridos. Reúne la gestión de metadatos, la gobernanza, el linaje, la supervisión de la calidad y la automatización en una única plataforma. Esto permite a los equipos ver de dónde proceden los datos, cómo se utilizan y si cumplen los requisitos internos y externos.

A través de su interfaz centralizada, Actian permite conocer en tiempo real las estructuras y flujos de datos, lo que facilita la aplicación de políticas, la resolución de problemas y la colaboración entre departamentos. La plataforma también ayuda a conectar los datos con el contexto empresarial, lo que permite a los equipos utilizar los datos de forma más eficaz y responsable. La plataforma de Actian está diseñada para escalar con ecosistemas de datos en evolución, apoyando un uso de datos consistente, inteligente y seguro en toda la empresa. Solicite su demostración personalizada.