Leitfaden zum Datenqualitätsmanagement #2 - Die Herausforderungen der Datenqualität

Der Begriff Datenqualität bezieht sich auf die Fähigkeit eines Unternehmens, die Qualität seiner Daten im Laufe der Zeit zu erhalten. Glaubt man einigen Datenexperten, so ist die Verbesserung der Datenqualität das Allheilmittel für alle unsere geschäftlichen Probleme und sollte daher oberste Priorität haben.

Wir glauben, dass dies nuanciert sein sollte: Datenqualität ist ein Mittel unter anderen, um die Unsicherheiten bei der Erreichung der Unternehmensziele zu begrenzen.

In dieser Artikelserie gehen wir auf alles ein, was Datenexperten über Datenqualitätsmanagement (DQM) wissen müssen:

- Die neun Dimensionen der Datenqualität

- Die mit der Datenqualität verbundenen Herausforderungen und Risiken

- Die wichtigsten Merkmale von Datenqualitätsmanagement-Tools

- Der Datenkatalog zum DQM

Die Herausforderungen der Datenqualität für Unternehmen

Initiativen zur Verbesserung der Datenqualität werden in der Regel von Organisationen umgesetzt, um Konformitätsanforderungen kennenlernen und Risiken zu reduzieren. Sie sind unverzichtbar für eine zuverlässige Entscheidungsfindung. Leider gibt es viele Stolpersteine, die Initiativen zur Verbesserung der Datenqualität behindern können. Nachfolgend sind einige Beispiele aufgeführt:

- Das exponentielle Wachstum der Datenmenge, -geschwindigkeit und -vielfalt macht das Umfeld komplexer und unsicherer.

- Zunehmender Druck durch Konformitätsvorschriften wie GDPR, BCBS 239 oder HIPAA.

- Die Teams sind zunehmend dezentralisiert, und jedes Team hat sein eigenes Fachgebiet.

- IT- und Datenteams sind überlastet und haben keine Zeit, Datenqualitätsprobleme zu lösen.

- Die Datenaggregationsprozesse sind komplex und langwierig.

- Es kann schwierig sein, Daten aus verschiedenen Quellen zu standardisieren.

- Änderungskontrollen zwischen Systemen sind komplex.

- Die Umsetzung von Governance-Maßnahmen ist schwierig.

Es gibt aber auch zahlreiche Chancen, die es zu nutzen gilt. Qualitativ hochwertige Daten ermöglichen es Unternehmen, Innovationen mit künstlicher Intelligenz zu fördern und ein personalisierteres Customer-Experience zu gewährleisten. Vorausgesetzt, es gibt genügend hochwertige Daten.

Gartner hat sogar prognostiziert, dass bis zum Jahr 2022 85 % der KI-Projekte aufgrund von Verzerrungen in den Daten, Algorithmen oder von den für das Datenmanagement zuständigen Teams fehlerhafte Daten produzieren werden.

Verringerung des Risikos durch Verbesserung der Datenqualität

Schlechte Datenqualität sollte als Risiko betrachtet werden, und Software zur Qualitätsverbesserung ist eine mögliche Lösung zur Verringerung dieses Risikos.

Bearbeitung eines Qualitätsproblems

Wenn wir den obigen Gedanken akzeptieren, sollte jedes Qualitätsproblem in mehreren Phasen angegangen werden:

1. Identifizierung von Risiken: In dieser Phase geht es darum, die Risiken zu suchen, zu erkennen und zu beschreiben, die dazu beitragen können, dass die Organisation ihre Ziele nicht erreicht - unter anderem aufgrund mangelnder Datenqualität.

2. Die Risikoanalyse: In dieser Phase geht es darum, die Art des Risikos und seine Merkmale zu verstehen. Dazu gehören die Faktoren für die Ähnlichkeit der Ereignisse und ihre Folgen, die Art und die Bedeutung dieser Folgen usw. Hier sollte versucht werden, die Ursachen für die schlechte Qualität der Marketingdaten zu ermitteln. Wir könnten zum Beispiel anführen:

- Schlechte Nutzer mit dem Quellsystem, was zu Tippfehlern führt;

- Eine fehlende Überprüfung der Vollständigkeit, Genauigkeit, Gültigkeit, Einzigartigkeit, Beständigkeit oder Aktualität der Daten;

- Es fehlt an einfachen Mitteln, um die Nachvollziehbarkeit, Klarheit und Verfügbarkeit der Daten zu gewährleisten;

- Das Fehlen eines Governance-Prozesses und die Auswirkungen auf die Unternehmensteams.

3. Risikobewertung: Ziel dieser Phase ist es, die Ergebnisse der Risikoanalyse mit den festgelegten Risikokriterien zu vergleichen. Sie trägt dazu bei, festzustellen, ob weitere Maßnahmen für die Entscheidungsfindung erforderlich sind - z. B. Beibehaltung der derzeitigen Mittel, Durchführung weiterer Analysen usw.

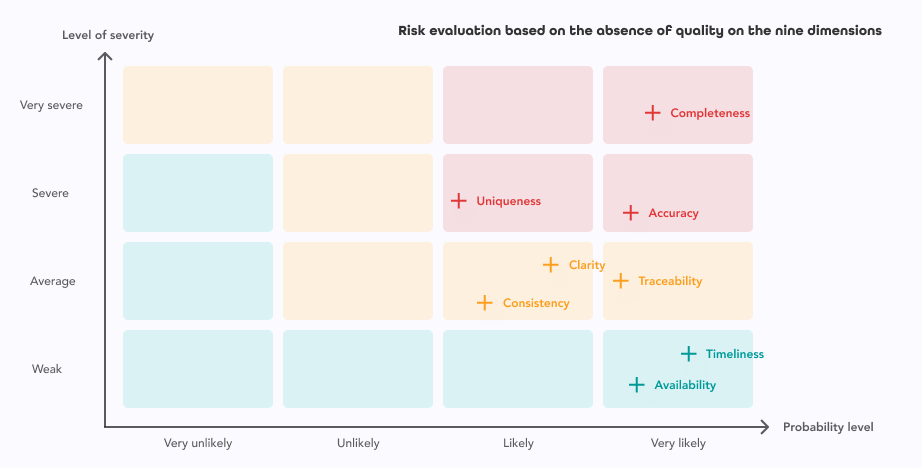

Konzentrieren wir uns auf die neun Dimensionen der Datenqualität und bewerten wir die Auswirkungen schlechter Qualität auf jede dieser Dimensionen:

Die Werte für die Wahrscheinlichkeit und den Schweregrad sollten von den Hauptbeteiligten festgelegt werden, da sie die betreffenden Daten am besten kennen.

4. Risiko Verarbeitung: In dieser Bearbeitungsphase werden die verfügbaren Optionen zur Risikominderung festgelegt und umgesetzt. Diese Bearbeitung beinhaltet auch die Fähigkeit, die Nützlichkeit der ergriffenen Maßnahmen zu bewerten und festzustellen, ob das Restrisiko akzeptabel ist oder nicht - und in diesem letzten Fall eine weitere Bearbeitung in Betracht zu ziehen.

Die Verbesserung der Datenqualität ist also kein Ziel an sich:

- Ihre Kosten müssen auf der Grundlage der Unternehmensziele bewertet werden.

- Die durchzuführenden Behandlungen müssen anhand jeder Qualitätsdimension bewertet werden.

Holen Sie sich unseren Leitfaden zum Datenqualitätsmanagement für data driven Organisationen

Wenn Sie weitere Informationen über Datenqualität und DQM wünschen, laden Sie unseren kostenlosen Leitfaden herunter: "Leitfaden zum Datenqualitätsmanagement" jetzt herunterladen! Laden Sie das eBook herunter.