Actian Data Beobachtbarkeit: Eine Plattform für die Zukunft

Einführung von Actian Data Beobachtbarkeit: Hochwertige Daten, zuverlässige KI

Zusammenfassung

Dieser Blog stellt Beobachtbarkeit Data Beobachtbarkeit von Actianvor – eine proaktive, KI-gestützte Lösung, die darauf ausgelegt ist, die Zuverlässigkeit von Daten zu gewährleisten, Cloud zu senken und vertrauenswürdige KI zu unterstützen, indem sie 100 % der Datenpipelines in Echtzeit überwacht.

- Proaktive KI-gestützte Überwachung verhindert Datenprobleme: Die ML-gesteuerte Anomalie identifiziert Schemadrift, Ausreißer und Aktualitätsprobleme frühzeitig in der Pipeline - bevor sie sich auf nachgelagerte Systeme auswirken.

- Vorhersehbare Kosten bei vollständiger Datenabdeckung: Im Gegensatz zu stichprobenbasierten Tools verarbeitet Actian jede Aufzeichnung auf einer isolierten Rechnerebene und bietet so eine kostenneutrale Ausfallsicherheit und vermeidet Cloud .

- Flexible, offene Architektur für moderne Datenstapel: Unterstützt Apache Iceberg und lässt sich ohne Lieferanten-Lock-in Leistungseinbußen in Produktionssystemen in Data Lakes, Lakehouses und Warehouses integrieren.

Die wahren Kosten reaktiver Datenqualität

Gartner® schätzt: „Bis 2026 werden 50 % der Unternehmen, die verteilte Datenarchitekturen implementieren, Data Observability Tools einsetzen, um einen besseren Blick auf den Zustand der Datenlandschaft zu erhalten, gegenüber weniger als 20 % im Jahr 2024.“ Aber Beobachtbarkeit geht über Überwachung hinaus – sie ist ein strategischer Weg, um Vertrauen in Daten aufzubauen und gleichzeitig die steigenden Kosten für die Datenqualität im gesamten Unternehmen in Schach zu halten.

Der heutige Unternehmensdatenstapel ist ein Flickenteppich aus alten und neuen Technologien – komplex, fragmentiert und schwer zu verwalten. Da die Daten von der Erfassung über die Speicherung und Umwandlung bis hin zur Nutzung fließen, vervielfacht sich das Risiko, dass es zu Fehlern kommt. Traditionelle Methoden können da nicht mehr mithalten.

- Datenteams verlieren bis zu 40 % ihrer Zeit mit „Brandbekämpfung“, statt dass sie sich auf den strategischen Wert konzentrieren.

- Cloud steigen weiter an, was auf ineffiziente und reaktive Ansätze zur Datenqualität zurückzuführen ist.

- KI-Investitionen greifen zu kurz, wenn Modelle auf unzuverlässigen oder unvollständigen Daten beruhen.

- Die Compliance-Risiken nehmen zu, da Unternehmen nicht über die nötige Transparenz verfügen, um ihre Daten zu verfolgen und ihnen zu vertrauen.

Die heutigen Datenqualitätskonzepte sind in der Vergangenheit verhaftet:

1. Das Legacy-Problem

Herkömmliche Datenqualitätsmethoden haben zu einer wahren Flut an Ineffizienz und blinden Flecken geführt. In dem Maße, in dem das Datenvolumen wächst, haben Unternehmen mit dem manuellen Erstellen von Regeln zu kämpfen und sind gezwungen, Tausende von Qualitätsprüfungen in fragmentierten Systemen zu erstellen und zu pflegen. Das Ergebnis? Ein arbeitsintensiver Prozess, der sich auf selektive Stichproben stützt und kritische Datenqualitätsprobleme unentdeckt lässt. Gleichzeitig konzentriert sich die Überwachung weiterhin auf Infrastrukturmetriken wie CPU und Arbeitsspeicher und nicht auf die Integrität der Daten an sich.

Das Ergebnis ist eine fragmentierte Visibility, bei der Probleme in einem System nicht mit Problemen in anderen Systemen in Verbindung gebracht werden können. Dadurch ist eine Ursachenanalyse nahezu unmöglich. Datenteams sind in einer reaktiven Schleife gefangen und jagen nachgelagerten Fehlern hinterher, anstatt sie an der Quelle zu verhindern. Diese ständige Bekämpfung einzelner Brandherde untergräbt die Produktivität und, was noch wichtiger ist, das Vertrauen in die Daten, die die Grundlage für wichtige Geschäftsentscheidungen bilden.

- Manuelle, regelbasierte Prüfungen sind nicht skalierbar, so dass die meisten Datensätze nicht überwacht werden.

- Stichproben zur Kostensenkung führen zu blinden Flecken, die kritische Entscheidungen gefährden.

- Die Überwachung der Infrastruktur allein vernachlässigt das Wichtigste: die Daten selbst.

- Unverbundene Überwachungstools verhindern, dass Teams einen Gesamtüberblick über die Pipelines haben.

2. Der verborgene Haushaltsabfluss

Der Umstieg auf Cloud sollte eigentlich zu einer Kostenoptimierung führen – doch herkömmliche Beobachtbarkeit haben das Gegenteil bewirkt. Da Teams die Überwachung auf ihren gesamten Datenbestand ausweiten, führen rechenintensive Abfragen zu unvorhersehbaren Kostenanstiegen in Produktionssystemen. Bei begrenzter Kostentransparenz ist es nahezu unmöglich, Ausgaben nachzuvollziehen oder Budgets effektiv zu planen. Mit der Datenmenge steigen auch die Kosten – und zwar schnell. Unternehmen stehen vor einer schwierigen Entscheidung: entweder die Überwachung reduzieren und das Risiko nicht erkannter Probleme eingehen oder die Abdeckung beibehalten und den Finanzverantwortlichen Cloud steigenden Cloud rechtfertigen. Diese Unvorhersehbarkeit der Kosten ist heute ein wesentliches Hindernis für die Einführung Beobachtbarkeit auf Unternehmensebene.

- Die ineffiziente Verarbeitung verursacht übermäßige Rechen- und Speicherkosten.

- Die begrenzte Kostentransparenz macht die Optimierung und Budgetierung zu einer Herausforderung.

- Die anwachsenden Datenmengen lassen die Kosten in die Höhe schnellen und machen die Scalability zu einem immer größeren Problem.

3. Der Flaschenhals Architektur

Die meisten Observability-Lösungen legen der Architektur Fesseln an, wodurch die technische Flexibilität und Scalability eines Unternehmens stark einschränkt wird. Diese Lösungen sind in der Regel als eng integrierte Komponenten konzipiert, die tief in bestimmte Cloud-Plattformen oder Datentechnologien eingebettet sind, wodurch Unternehmen in langfristige Anbieterverpflichtungen gezwungen werden und bei zukünftigen Innovationen eingeschränkt sind.

Wenn Qualitätsprüfungen direkt auf Produktionssystemen ausgeführt werden, konkurrieren sie um kritische Ressourcen mit den Kerngeschäftsvorgängen und verursachen oft erhebliche Leistungseinbußen in Spitzenzeiten – genau dann, wenn Zuverlässigkeit am wichtigsten ist. Einschränkungen in der Architektur zwingen Datenteams dazu, zur Aufrechterhaltung der Perfromance komplexe, benutzerdefinierte technische Workarounds zu entwickeln, wodurch „technische Schulden“ entstehen und wertvolle technische Ressourcen verbraucht werden.

- Eng gekoppelte Lösungen, die Sie an bestimmte Plattformen binden.

- Leistungseinbußen bei der Durchführung von Prüfungen auf Produktionssystemen.

- Ineffiziente Ressourcennutzung, die gesonderte Entwicklung erfordert.

Actian mit innovativem Ansatz zur Datenzuverlässigkeit

Actian Data Beobachtbarkeit steht für einen grundlegenden Wandel von reaktiver Brandbekämpfung zu proaktiver Datensicherheit. Hier ist unser Unterschied:

1. Proaktiv statt reaktiv

Traditionelle Methode: Entdeckung von Datenqualitätsproblemen, nachdem diese bereits Auswirkungen auf Geschäftsentscheidungen hatten.

Actian-Methode:KI-gestützte Anomalie , die Probleme mithilfe von ML-gestützten Erkenntnissen frühzeitig im Prozess aufdeckt.

2. Vorhersehbare, wirtschaftliche Cloud

Traditionelle Methode: Unvorhersehbare Cloud , die mit Datenvolumen steigen.

Actian-Methode: Keine Kostensteigerungen dank einer effizienten Architektur, die den Ressourcenverbrauch optimiert.

3. Vollständige Erfassung, kein Sampling

Traditionelle Methode: Daten werden zur Kosteneinsparung nur stichprobenartig erfasst, wodurch kritische Blindspots entstehen.

Actian-Methode: 100 % Datenabdeckung ohne Kompromisse durch intelligente Verarbeitung.

4. Freiheit in der Architektur

Traditionelle Methode:Lieferanten-Lock-in begrenzten Integrationsmöglichkeiten.

Actian-Methode: Offene Architektur mit nativer Apache Iceberg-Unterstützung und nahtloser Integration in moderne Datenstacks.

Auswirkungen auf die reale Welt

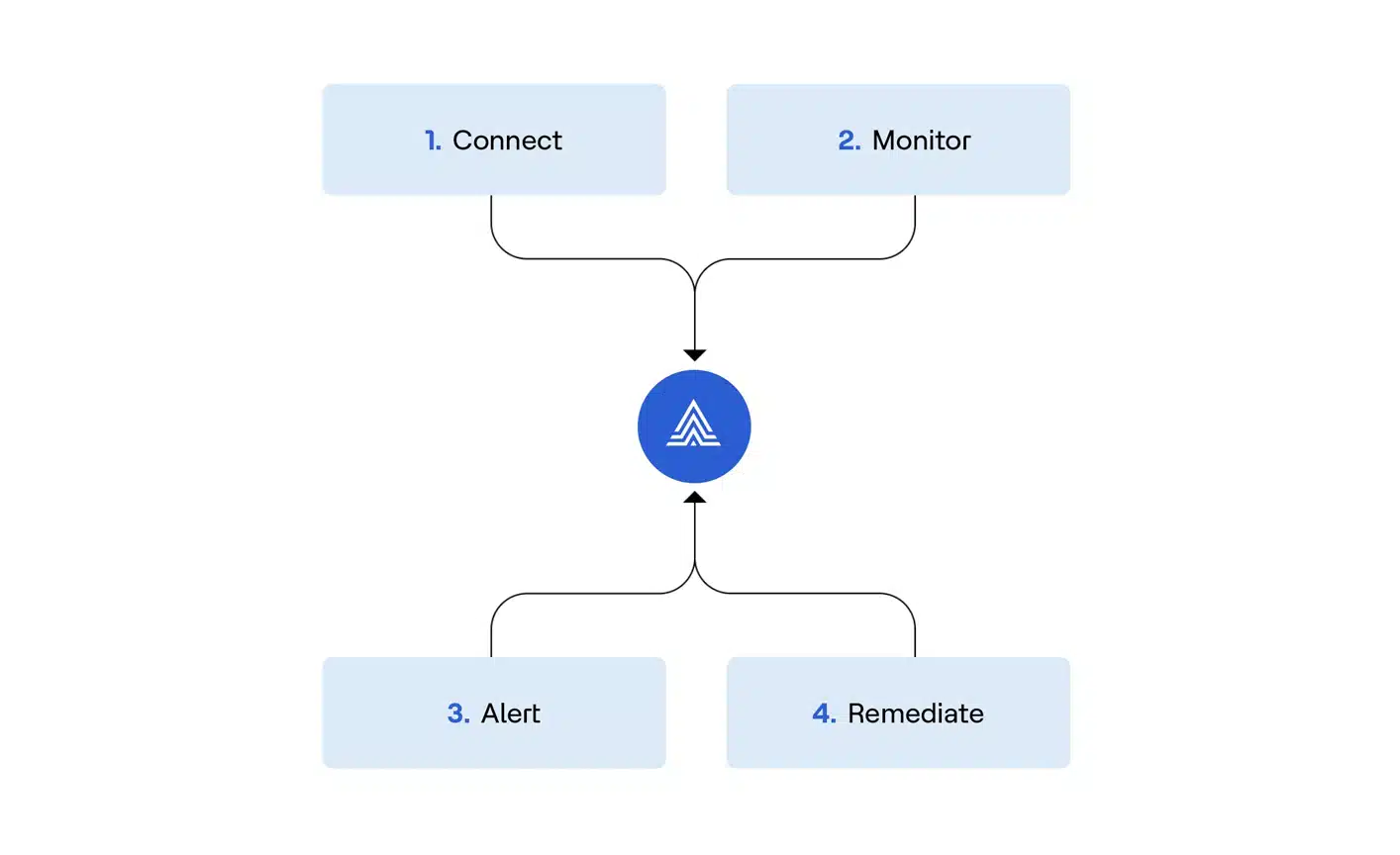

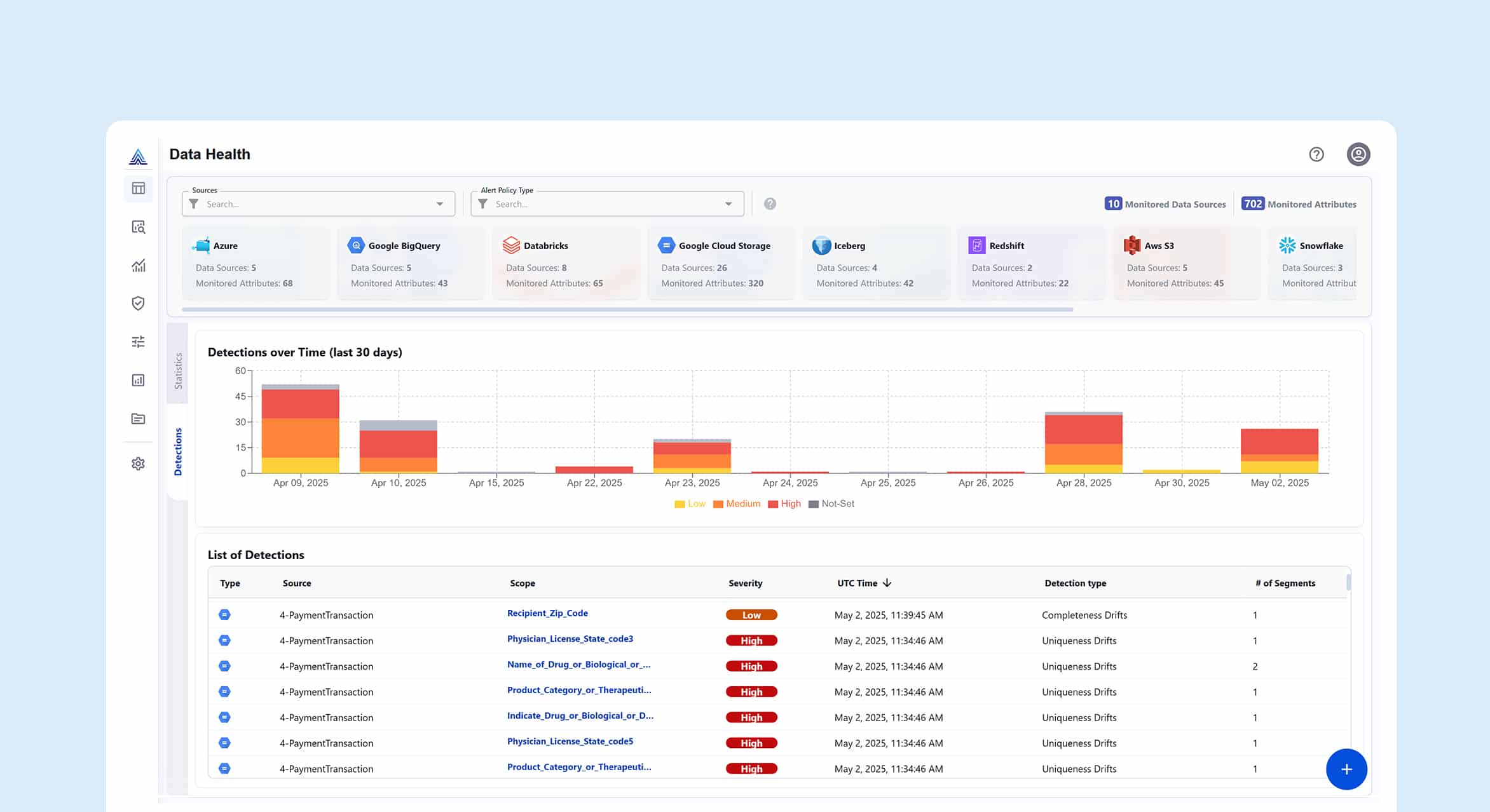

Werfen wir einen kurzen Blick darauf, wie Beobachtbarkeit Data Beobachtbarkeit von Actian im Alltag eines Unternehmens oder einer Organisation funktioniert.

Use Case 1: Effiziente Datenpipeline mit „Shift-Left“

Transformieren Sie Ihre Datenprozesse, indem Sie Probleme an der Quelle erkennen:

- Implementieren Sie umfassende DQ-Prüfungen in den Phasen Ingestion, Transformation und Source.

- Integration in CI/CD-Workflows für Datenpipelines.

- Reduzieren Sie die Nacharbeitskosten und beschleunigen Sie die Time-to-Value.

Use Case 2: Überwachung des Lebenszyklus von GenAI

Stellen Sie sicher, dass Ihre KI-Initiativen auch von geschäftlichem Nutzen sind:

- Validierung der Qualität der Training und der RAG-Wissensquellen.

- Achten Sie auf Halluzinationen, Verzerrungen und Leistungsabweichungen.

- Verfolgen Sie die Betriebskennzahlen des Modells in Echtzeit.

Use Case 3: Sichere Self-Service Analytics

Ermöglichen Sie Ihrem Unternehmen eine sichere Datenexploration:

- einbetten von einbetten -Gesundheitsindikatoren in Kataloge und BI-Tools.

- Überwachen Sie Datensätze und deren Nutzungsmuster proaktiv.

- Schaffen Sie Vertrauen durch Transparenz und Validierung.

Der Vorteil mit Actian: Fünf markante Unterscheidungsmerkmale

- Kein Data Sampling: 100%ige Datenerfassung für umfassende Beobachtbarkeit.

- Keine extrem steigenden Cloud-Ausgaben: Vorhersehbare Wirtschaftlichkeit im großen Maßstab.

- Gesicherte Null-Kopie-Architektur: Zugriff auf Metadaten ohne kostspielige Datenkopien.

- Skalierbare KI-Workloads: ML-Funktionen für Unternehmen.

- Unterstützung von Native Apache Iceberg: Unerreichte Beobachtbarkeit für moderne Tabellenformate.

Übernehmen Sie die Kontrolle über Ihre Daten mit Actian Data Beobachtbarkeit

Gehen Sie auf Produkttour! Sie erfahren, wie Sie Ihre Datenoperationen vor reaktivem Chaos bewahren und stattdessen proaktiv kontrollieren können.