Streaming Daten-Pipelines werden immer mehr zu unverzichtbaren Tools für moderne Unternehmen, die eine schnelle Datenverarbeitung in Echtzeit benötigen. Heutzutage erhalten Unternehmen Daten aus vielen verschiedenen Quellen - von mobilen Geräten bis hin zu Cloud - und effiziente Streaming s helfen ihnen, die für den Geschäftserfolg wichtigen Daten zeitnah zu erhalten. Von mobilen Bankgeschäften und GPS-Anwendungen bis hin zu Betrugserkennung und vorausschauender Wartung verlassen sich Unternehmen auf der ganzen Welt auf diese Pipelines, um zeitnahe Einblicke und Maßnahmen zu erhalten, die ihr Geschäft vorantreiben.

In diesem umfassenden Leitfaden werden wir untersuchen, was Streaming Daten-Pipelines sind, wie sie funktionieren, welche Vorteile sie bieten und vieles mehr. Lassen Sie uns eintauchen.

Was sind Streaming Data Pipelines?

Eine Streaming Datenpipeline ist ein System, das kontinuierlich Daten in Echtzeit verarbeitet und überträgt. Im Gegensatz zur traditionellen Stapelverarbeitung Pipelines, die mit statischen Datensätzen arbeiten, Streaming s verarbeiten Daten in Bewegungund führen Echtzeitanalysen und Transformationen durch, sobald die Daten eintreffen.

Diese Pipelines erfassen Daten aus verschiedenen Quellen, verarbeiten sie sofort und stellen sie bereit, ohne auf den Abschluss des Datenerfassungsprozesses zu warten. Streaming Daten-Pipelines sind von entscheidender Bedeutung für Unternehmen, die Daten schnell benötigen und sich keine langen Verarbeitungszeiten leisten können.

Wie funktionieren Streaming ?

Daten durchlaufen auf ihrem Weg mehrere Berührungspunkte Streaming s. Um die Funktionsweise dieser Pipelines zu erläutern, wird im Folgenden der Daten fließen von den Quellen zu den Endnutzern:

- Daten-Quellen: Dazu gehören IoT , Anwendungen, Websites, Datenbanken und APIs von Drittanbietern, die kontinuierliche Datenströme erzeugen.

- Dateneingang: Tools wie Apache Kafka ingest Streaming indem sie diese erfassen und zur Verarbeitung an die Pipeline weiterleiten.

- Data Analytics in Echtzeit: Dies beinhaltet die Umwandlung und Analyse von Daten in Echtzeit mithilfe von Frameworks wie Flink oder Spark Streaming.

- Speicherung von Daten: Die verarbeiteten Daten werden häufig in Datenbanken oder Datenseen um Echtzeitanalysen und zukünftige Abfragen zu unterstützen.

- Datenverbraucher: Die verarbeiteten Daten werden Anwendungen, Dashboards, Algorithmen des Maschinelles Lernen oder anderen Nutzern zur Verfügung gestellt, die sie in Echtzeit verbrauchen und den Datenverwaltern präsentieren.

Streaming Data Pipelines im Vergleich zu herkömmlichem ETL

Herkömmliche ETL-Prozesse (Extrahieren, Transformieren und Laden) verwenden in der Regel Stapelverarbeitung. Dabei werden die Daten über einen bestimmten Zeitraum gesammelt, umgewandelt und in ein Zielsystem geladen. Im Gegensatz dazu werden bei Streaming ETL-Pipelines die Daten umwandeln und laden, sobald sie produziert werden, und ermöglichen so eine sofortige Analyse und Entscheidungsfindung. Dies ist von entscheidender Bedeutung für Anwendungen wie die Erkennung von Finanzbetrug, bei denen Daten innerhalb von Millisekunden und nicht erst nach Stunden verarbeitet werden müssen.

Vorteile von Streaming Data Pipelines

Streaming Daten-Pipelines bieten eine Reihe von Vorteilen für Unternehmen, die eine schnelle und effiziente Datenverarbeitung benötigen. Hier sind fünf wichtige Vorteile:

1. Verbesserte Entscheidungsfindung

Streaming s ermöglichen Real-Time-Insights, so dass Unternehmen data-driven Entscheidungen in der Geschwindigkeit ihres Geschäfts treffen können. So können Finanzinstitute beispielsweise Betrug erkennen, während Transaktionen stattfinden, und Verluste in Echtzeit verhindern.

2. Geringere Latenzzeit

Durch die Verarbeitung von Daten, sobald sie ankommen, Streaming s die Zeitspanne zwischen Datengenerierung und Datenverbrauch erheblich verkürzen. Dies ist in Branchen wie dem Gesundheitswesen entscheidend, wo eine Sekunde über Leben und Tod entscheiden kann.

3. Agilität und Scalability

Streaming-Pipelines sind je nach Geschäftsanforderungen hochgradig skalierbar, sodass sie sich leicht an schwankende Datenmengen anpassen lassen. Unabhängig davon, ob Unternehmen mit einer Handvoll oder Millionen von Datenquellen arbeiten, Cloud-nativeDaten-Pipelines können die Last effizient bewältigen.

4. Fehlertoleranz

Fehlertoleranz ist die Fähigkeit eines Datensystems, seinen Betrieb fortzusetzen, wenn einer seiner Bestandteile ausfällt. Viele Streaming - wie DataFlow - unterstützen die Fehlertoleranz, so dass die Pipeline auch dann reibungslos weiterläuft, wenn Komponenten ausfallen.

5. Kosteneffizienz

Die Datenverarbeitung in Echtzeit ermöglicht es Unternehmen, Ineffizienzen zu erkennen und Abläufe zu optimieren, was im Laufe der Zeit zu Kosteneinsparungen führt. Die Verarbeitung kleinerer Datenpakete in Echtzeit kann auch den Bedarf an größerem Speicherplatz im Vergleich zur Stapelverarbeitung.

Bewährte Praktiken fürDatenpipeline

Die Entwicklung einer leistungsstarkenDatenpipeline beginnt mit einer sorgfältig konstruierten Architektur. Hier sind einige Überlegungen zur Erstellung einer solchen:

Streaming vs. Batch-Verarbeitung

Während Stapelverarbeitung für einige analytische Workloads hilfreich ist, Streaming s eine gute Option, wenn niedrige Latenz der Datenverarbeitung erforderlich ist. Allerdings können hybride Architekturen, die sowohl Stapelverarbeitung als auch Streaming nutzen, manchmal der beste Ansatz sein, da sie die Vorteile beider Verfahren bieten.

Dezentrales Datenmanagement

Moderne Streaming-Architekturen profitieren von einem dezentralen Datenmanagement-Ansatz. Anstatt sich auf ein zentrales Data Warehouse zu verlassen, können Unternehmen Daten in Bewegung über verschiedene Cloud-native Data Lakes verwalten und verarbeiten und damit mehr Agilität erreichen.

Deklarative Sprachen

Mit Sprachen wie SQL für Streaming Daten-Pipelines vereinfacht deren Entwicklung und Wartung. Dieser Ansatz ermöglicht es Entwicklern, sich auf das zu konzentrieren was was die Pipeline tun soll und nicht wie sie getan werden sollte.

Fortlaufende Integration/kontinuierliche Bereitstellung (CI/CD)

Die Einbindung von CI/CD-Pipelines in Datenflüsse ist entscheidend für die Aufrechterhaltung einer hohen Verfügbarkeit und Leistung in Streaming s. Regelmäßige Tests, Deployment und Überwachung sorgen dafür, dass Änderungen an der Pipeline sicher und effizient umgesetzt werden.

Data Governance

Die Umsetzung geeigneter Data Governance ist unerlässlich, um die Datenqualität und die Einhaltung von Vorschriften zu gewährleisten. Beim Aufbau einer Data Governance , die Folgendes umfasst Streaming s einschließt, ist es wichtig, die Datenherkunft zu verfolgen, den Datenschutz zu gewährleisten und die Gesetze zur Datenkonformität einzuhalten.

Implementierung und Integration von Streaming Data Pipelines

Sobald Unternehmen eine solide Architektur für ihre Pipelines erstellt haben, ist es an der Zeit, sie in das Datensystem zu integrieren und sie in Betrieb zu nehmen. Hier finden Sie eine schrittweise Anleitung für die Datenintegration:

1. Bewertung der Infrastruktur

Bevor Sie Pipelines implementieren, sollten Sie die aktuelle Infrastruktur bewerten, um sicherzustellen, dass sie mit den Anforderungen der Echtzeit-Datenverarbeitung kompatibel ist. Berücksichtigen Sie die Kapazität des Netzwerks, die Speicheranforderungen und die Skalierbarkeit.

2. Wählen Sie die richtigen Werkzeuge

Die Auswahl der richtigen Plattform ist entscheidend für den Erfolg der Pipeline. Apache Kafka und Actian DataFlow sind eine beliebte Wahl, da sie robuste Funktionen für Streaming, Fehlertoleranz und Scalability bieten. Insbesondere Actian DataFlow bietet leistungsstarke Echtzeitanalysen und Fähigkeiten, die den Umgang mit komplexen Datenflüsse.

3. Schema vereinheitlichen

Die Standardisierung des Datenschemas gewährleistet konsistente Datenformate über verschiedene Systeme hinweg, was zur Reduzierung von Fehlern beiträgt und eine reibungslose Integration zwischen verschiedenen Teilen der Streaming .

4. Echtzeit-Überwachung und -Warnungen

Streaming s müssen in Echtzeit überwacht werden, um Engpässe, Ausfälle oder Leistungsprobleme zu erkennen. Richten Sie Warnmeldungen ein, die die Beteiligten über potenzielle Probleme informieren, bevor sie sich auf den Gesamtzustand der Pipeline auswirken.

5. Deployment

Setzen Sie schließlich die Streaming je nach den Anforderungen des Unternehmens mit Cloud Diensten oder On-Premises Lösungen. Stellen Sie sicher, dass CI/CD-Prozesse für künftige Aktualisierungen und Wartung vorhanden sind.

Häufige Herausforderungen und wie man sie überwindet

Aufbau und Pflege von Streaming Daten-Pipelines kann Herausforderungen mit sich bringen. Hier erfahren Sie, wie Sie einige der häufigsten Herausforderungen meistern:

Beständigkeit

Die Sicherstellung der Beständigkeit über mehrere Streaming hinweg kann schwierig sein, insbesondere wenn es um verteilte Daten geht. Die Implementierung einer einmaligen Verarbeitung und die Verwendung von Event-Sourcing-Mustern können helfen.

Hohe Datenvolumina

Die Verwaltung großer Datenmengen in Echtzeit kann Pipelines überlasten. Um das Risiko zu verringern, sollten Sie die Daten durch Sharding oder Partitionierung in überschaubare Teile aufteilen und die Verarbeitungseffizienz verbessern.

Anforderungen an niedrige Latenzzeiten

Niedrige Latenzzeiten können eine Herausforderung sein, insbesondere wenn Daten mehrere Systeme durchlaufen müssen. Optimieren Sie die Pipeline mit in-memory wie Apache Flink und reduzieren Sie unnötige Sprünge zwischen Systemen.

Ausgleich des Verarbeitungsbedarfs

Einige Daten erfordern eine komplexe Verarbeitung, was die Pipeline verlangsamen kann. Um die Leistung auszugleichen, sollten Sie Microservices-Architekturen verwenden, um die Workload zu verteilen.

Erfolgreiche Anwendungsfälle derDatenpipeline

DasStreaming von Daten eignet sich gut für eine Reihe von realen Anwendungsfällen. Dazu gehören:

Schnellere Betrugserkennung für Finanzdienstleistungen

Banken und Zahlungsabwickler verlassen sich stark auf Streaming Datenpipelines für Betrugserkennung und Echtzeitanalysen. Durch die Analyse von Transaktionsdaten bei der Durchführung von Transaktionen, Finanzinstitute können Finanzinstitute betrügerische Aktivitäten erkennen und unterbinden.

Ermöglicht Patientenüberwachung in Echtzeit im Gesundheitswesen

In der Gesundheitsbranche, Streaming s Leistung Echtzeit-Patientenüberwachungs Systeme. So streamen beispielsweise Herzfrequenzmesser und andere IoT Daten an Cloud Systeme, in denen KI-Algorithmen Anomalien sofort erkennen und das medizinische Personal alarmieren können.

Personalisierte Empfehlungen für den Einzelhandel

Einzelhändler verwenden Streaming s zum Betrieb von personalisierte Kundenempfehlungsmaschinen. Durch die Analyse von Kaufmustern und Präferenzen in Echtzeit können Unternehmen wie Amazon sofortige Produktvorschläge machen, die den Umsatz steigern.

Actian und die Data Intelligence Plattform

Die Actian Data Intelligence Platform wurde speziell dafür entwickelt, Unternehmen bei der Vereinheitlichung, verwalten und dem Verständnis ihrer Daten in hybriden Umgebungen zu unterstützen. Sie vereint Metadaten , Governance, Lineage, Qualitätsüberwachung und Automatisierung in einer einzigen Plattform. So können Teams sehen, woher die Daten kommen, wie sie verwendet werden und ob sie internen und externen Anforderungen entsprechen.

Durch seine zentrale Schnittstelle unterstützt Actian Erkenntnis über Datenstrukturen und -flüsse und erleichtert so die Anwendung von Richtlinien, die Lösung von Problemen und die abteilungsübergreifende Zusammenarbeit. Die Plattform hilft auch dabei, Daten mit dem geschäftlichen Kontext zu verbinden, damit Teams Daten effektiver und verantwortungsvoller nutzen können. Die Plattform von Actian ist so konzipiert, dass sie mit sich entwickelnden Datenökosystemen skaliert und eine konsistente, intelligente und sichere Datennutzung im gesamten Unternehmen unterstützt. Fordern Sie Ihr persönliches Demo an.

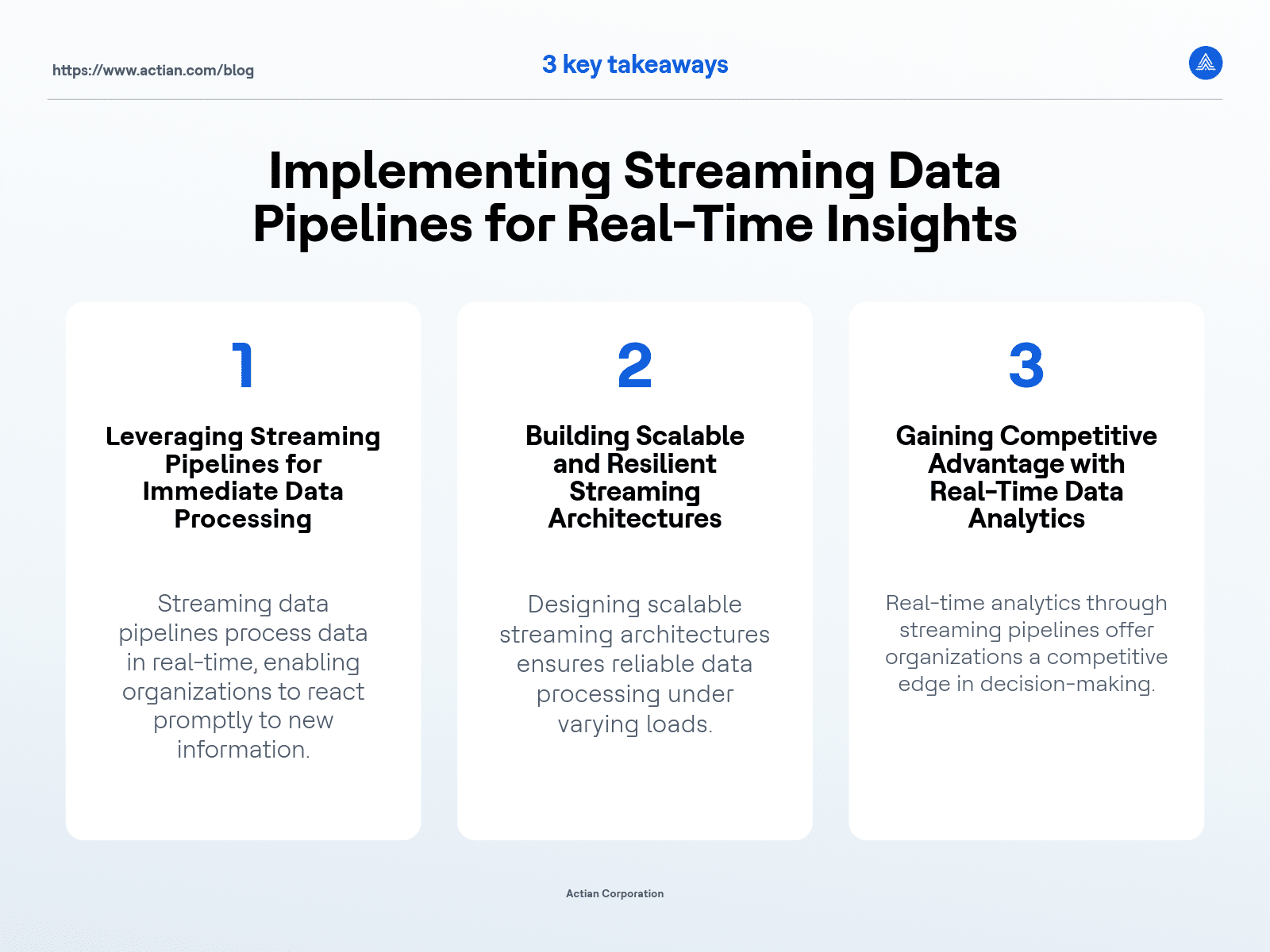

Wichtigste Erkenntnisse