Eine Enterprise Data Platform (EDP) unterstützt analytische Anwendungen, indem sie Zugang zu multiple data wie Data Warehouses und Data Lakes bietet. Im Gegensatz zu herkömmlichen Enterprise Data Warehouses versucht eine EDP nicht, alle analytischen Daten an einem einzigen Ort zu zentralisieren. Die EDP fungiert als Index für alle wesentlichen Datenbestände in einem Unternehmen. Die EDP katalogisiert Datenbestände mit Hilfe von Metadaten und hostet ihre eigenen Data Warehouses.

Schaffung der Unternehmensdatenplattform

Eine EDP muss so konzipiert sein, dass die Benutzer die benötigten Daten und Analysen leicht finden können. Die EDP muss ein rollenbasiertes Sicherheitszugangssystem unterstützen, um den Zugriff auf die Assets zu beschränken, die eine bestimmte Person oder Unternehmensgruppe einsehen darf. Moderne Datenplattformen, wie z.B. die Actian Data Platform von Actian, können mit bestehenden Sicherheitssystemen, wie z.B. Active Directory, zusammenarbeiten, um Datensätze der Sicherheitsrolle des Nutzerzuzuordnen.

Die EDV muss über eigene Data Warehouses verfügen, die das Laden von Batch-Daten unterstützen und Zugang zu Streaming bieten. Nicht intern gespeicherte Daten, wie z. B. einige halbstrukturierte und unstrukturierte Daten, müssen über Datenintegrationskonnektoren zugänglich sein.

Bestehende Data Lakes, wie z. B. Hadoop-Cluster, können an die EDP angeschlossen werden, aber die EDP sollte in der Lage sein, auf die von Hadoop verwendeten Dateiformate, wie Parquet und ORC, zuzugreifen.

Schlüsselfunktionen einer Unternehmensdatenplattform

- Dateneingang erleichtern die Bereitstellung mit Konnektoren und Dienstprogrammen wie parallelen Schnellladern.

- Die Datenspeicherung muss unterschiedliche Datenformate verarbeiten, indem Tabellen als Zeilen für OLTP-Anwendungen (On-Line Transaction Processing) und als Spaltenformate für Data Analytics gespeichert werden.

- Die Datenverarbeitung stellt die Funktionen zur Abfrage von Daten, zur Parallelisierung von Operationen und zur Verwaltung von Beständigkeit und Zustimmung für die EDV bereit.

- Funktionen der Benutzeroberfläche. Dazu gehören Konnektoren zu Business Intelligence (BI) Tools, APIs wie Open Database Connectivity (ODBC) und direkte Konnektoren zu operativen Systemen.

- Die Datenpipeline ist für den geordneten Fluss der Daten aus verschiedenen Quellsystemen in die Analysedatenbank verantwortlich.

Skalierung der EDP

Eine EDP muss hybride Data-Warehouse-Instanzen vor Ort und Cloud unterstützen. Ersteres kann aus Compliance-Gründen eine Anforderung sein. Cloud bieten bei Bedarf eine elastische Skalierung der Rechen- und Speicherinfrastruktur, um mit den wachsenden Nutzer Schritt zu halten.

Universelle Konnektivität

Auf die EDV muss von eingebettet Structured Query Language(SQL) Anwendungen aus zugegriffen werden, daher werden APIs zur Unterstützung von Skripten und Entwicklungssprachen benötigt. BI-Tools müssen mit der EDP verbunden werden, damit die Benutzer analytische Daten abfragen und visualisieren können.

Vorteile einer Unternehmensdatenplattform

Im Folgenden werden einige Gründe für die Einrichtung einer Unternehmensdatenplattform genannt:

- Eine EDP macht wertvolle Datenbestände leicht auffindbar. Das Unternehmen kann die besten Datenquellen kuratieren und ihre Nutzung fördern, indem es sie in die EDP aufnimmt.

- Die EDP erhöht die Nutzung der wertvollsten Datenbestände, da mehr Benutzer bevorzugte Datenversionen gemeinsam nutzen, anstatt eigene, nicht verwaltete Kopien zu erstellen. Die Kosten für die Pflege von mehr Beständen als benötigt werden, werden vermieden, indem sich die Organisation auf die hochwertigsten Datenquellen konzentriert.

- Verringerung der Duplizierung von Datensätzen in Silos durch Förderung der Wiederverwendung vorhandener Daten, die sonst übersehen werden könnten.

- Flexibilität bei der Unterstützung multiple data , wodurch bestehende Investitionen in Big Data und Data Warehouses aufgewertet werden. Die EDP schreibt nicht vor, dass bestehende Data Warehouses vollständig ersetzt werden müssen. Wenn Systeme modernisiert werden, können sie als Repositories der ersten Ebene in die EDP aufgenommen werden.

- Sie verbessert die Einhaltung von Vorschriften, da die EDV angemessene Sicherheitskontrollen durchführen kann.

- Ermöglicht eine schnellere Deployment neuer Datenquellen unter Verwendung vorhandener Instanzen als Vorlagen.

- Schafft eine Grundlage für Data Mesh- und Data Fabric-Initiativen. Sowohl Data Meshes als auch Data Fabrics tragen dazu bei, die Qualität der Datenbestände zu erhöhen und die Verwaltungskosten zu senken.

Nutzung von Actian als Unternehmensdatenplattform

Nachfolgend finden Sie einige Schlüsselfunktionen, die die Actian Data Platform zu einer soliden Grundlage für eine EDV-Anwendung machen:

- Integrierte Verbindungen zu Hunderten von Datenquellen.

- Planer für Datenpipeline .

- Vertikale Speicherung für Relationstabellen, um den Bedarf an traditionellen Datenbankindizes zu eliminieren.

- Unterstützung für externe Datenformate, einschließlich Hadoop Spark.

- Verteilte abfragen .

- Vektorverarbeitung auf handelsüblichen Prozessoren.

- Cloud .

- Cloud.

- Programmierung von APIs und Integration von BI-Tools.

Zentrale Sichtbarkeit für verteilte Daten

Die Unternehmensdatenplattform kann Data Warehouses vor Ort und in Cloud bereitstellen und nutzt Funktionen wie einen Datenkatalog, verteilte Abfragen und Datenkonnektoren zu externen Datenquellen, um die Navigation zu verteilten Daten zu vereinfachen.

Datenpipeline

Da sich betriebliche Datenquellen im Laufe der Zeit ändern, könnenETL-Pipelines (Extract Transform Load) verwendet werden, um die von der EDP verwalteten Data Warehouses zu aktualisieren. Eingehende Daten können transformiert, gefiltert und normalisiert werden, bevor sie in den Data Warehouses, mit denen die EDP verbunden ist, gespeichert werden. Extract Load Transform (ELT) bietet eine Alternative zu ETL, bei der hochgeladene Daten bereinigt und nach Bedarf in ein Data Warehouse transformiert werden. Datenintegrationstechnologie kann komplette Datenpipelines verwalten , von vordefinierten Konnektoren bis hin zu Planungsfunktionen für die Ausführung von Pipelineskripten. Eine umfassendere Datenintegrationstechnologie bietet eine unternehmensweite Überwachung von Datenpipelines mit der Möglichkeit, Vorgänge zu überprüfen, fehlgeschlagene Skripte erneut zu starten und bei Problemen eine Warnung auszusprechen.

Actian und die Data Intelligence Plattform

Die Actian Data Intelligence Platform wurde speziell dafür entwickelt, Unternehmen bei der Vereinheitlichung, verwalten und dem Verständnis ihrer Daten in hybriden Umgebungen zu unterstützen. Sie vereint Metadaten , Governance, Lineage, Qualitätsüberwachung und Automatisierung in einer einzigen Plattform. So können Teams sehen, woher die Daten kommen, wie sie verwendet werden und ob sie internen und externen Anforderungen entsprechen.

Durch seine zentrale Schnittstelle unterstützt Actian Erkenntnis über Datenstrukturen und -flüsse und erleichtert so die Anwendung von Richtlinien, die Lösung von Problemen und die abteilungsübergreifende Zusammenarbeit. Die Plattform hilft auch dabei, Daten mit dem geschäftlichen Kontext zu verbinden, damit Teams Daten effektiver und verantwortungsvoller nutzen können. Die Plattform von Actian ist so konzipiert, dass sie mit sich entwickelnden Datenökosystemen skaliert und eine konsistente, intelligente und sichere Datennutzung im gesamten Unternehmen unterstützt. Fordern Sie Ihr persönliches Demo an.

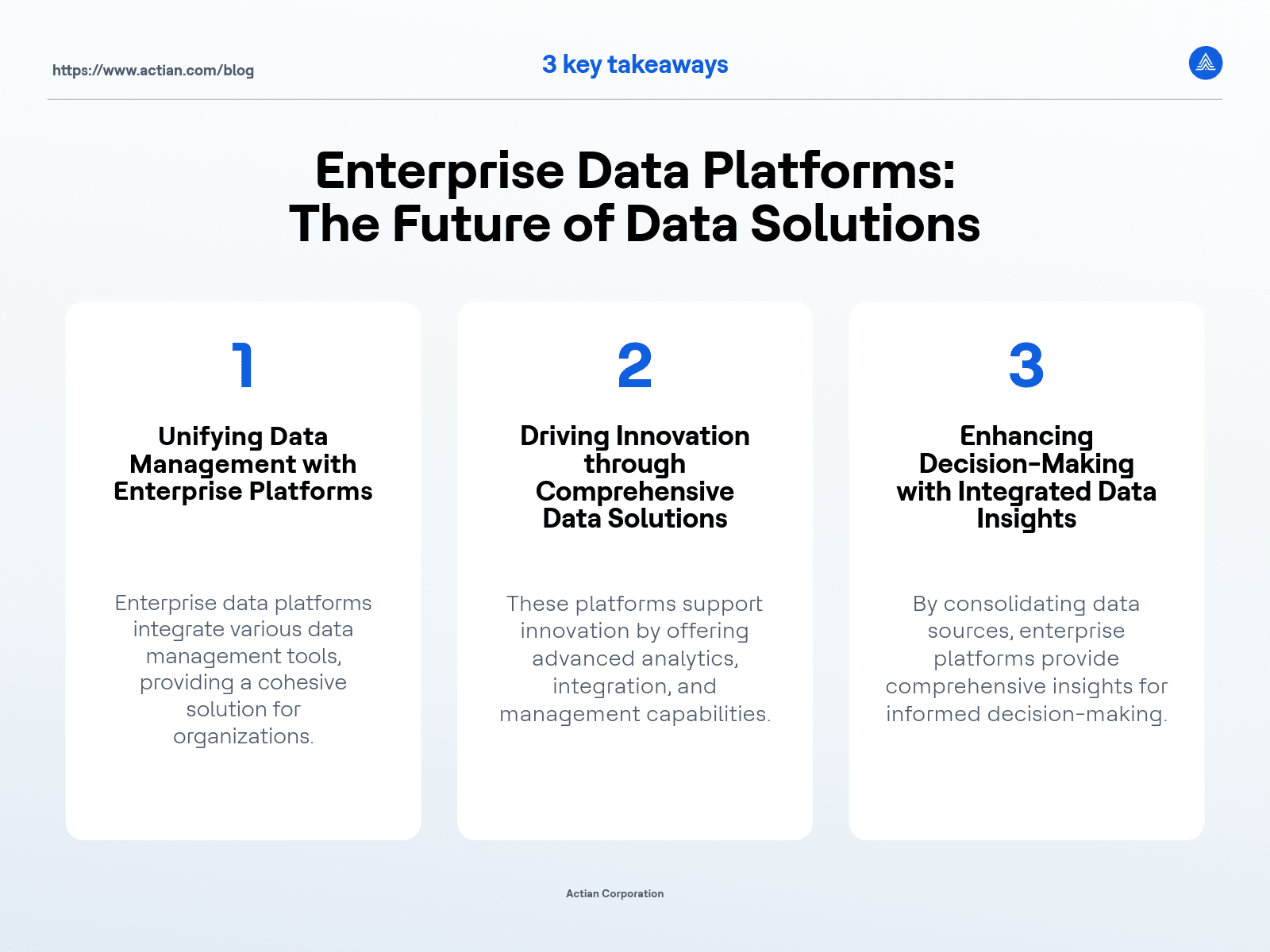

Wichtigste Erkenntnisse