Datenqualität und Data Observability: Warum Sie beides brauchen

Da Daten immer mehr in den Mittelpunkt der Entscheidungsfindung rücken, haben zwei Prioritäten für Datenverantwortliche Vorrang: Datenqualität und Beobachtbarkeit. Beide spielen eine entscheidende Rolle bei der Aufrechterhaltung der Zuverlässigkeit, Genauigkeit und Konformität von Unternehmensdaten.

Zusammen bieten Datenqualitäts- und Beobachtbarkeit eine leistungsstarke Grundlage für die Bereitstellung vertrauenswürdiger Daten für KI und andere Anwendungsfälle. Da die Datensysteme ein schnell wachsendes Datenvolumen aufweisen, stellen Unternehmen fest, dass dieses Wachstum zu einer erhöhten Datenkomplexität führt.

Datenpipelines umfassen oft ein breites Spektrum an Quellen, Formaten, Systemen und Anwendungen. Ohne die richtigen Tools und Frameworks können selbst kleine Datenprobleme schnell eskalieren, was zu ungenauen Berichten, fehlerhaften Modellen und kostspieligen Compliance-Verstößen führt.

Gartner stellt fest, dass bis 2026 50 % der Unternehmen, die verteilte Datenarchitekturen implementieren, Tools für die Beobachtbarkeit einsetzen werden, um die Transparenz der Datenlandschaft zu verbessern. 2024 waren es noch weniger als 20 %. Hier erfahren Sie, wie Datenqualität und Beobachtbarkeit Unternehmen helfen:

Vertrauen aufbauen und Vertrauen in die Datenqualität haben

Jede Geschäftsentscheidung, die die Beteiligten treffen, hängt von der Vertrauenswürdigkeit ihrer Daten ab. Wenn Daten ungenau, unvollständig, inkonsistent oder veraltet sind, wird dieses Vertrauen gebrochen. Unvollständige Daten können sich beispielsweise negativ auf das Patientenerlebnis im Gesundheitswesen auswirken, oder falsch positive Ergebnisse bei Kreditkartentransaktionen, die einen Kauf fälschlicherweise als betrügerisch einstufen, untergraben das Vertrauen der Kunden.

Deshalb ist ein gut durchdachter Framework die Datenqualität von grundlegender Bedeutung. Es stellt sicher, dass die Daten brauchbar und genau sind und mit den Geschäftsanforderungen übereinstimmen.

Mit soliden Datenqualitätsprozessen können die Teams:

- Erkennen und korrigieren Sie Fehler frühzeitig in der Pipeline.

- Sicherstellung der Beständigkeit über verschiedene Systeme hinweg.

- Überwachen Sie kritische Aspekte wie Vollständigkeit, Genauigkeit und Aktualität.

- Daten mit Governance- und Compliance-Anforderungen in Einklang bringen.

Durch die Einbettung von Qualitätsprüfungen in den gesamten Datenlebenszyklus können Teams und Stakeholder mit Zuversicht Entscheidungen treffen. Das liegt daran, dass sie den Daten hinter jedem Bericht, dashboard und Modell vertrauen können. Wenn Unternehmen die Beobachtbarkeit Daten in ihr Framework einbeziehen, erhalten sie einen Echtzeit-Einblick in den Zustand ihrer Daten und können so Probleme erkennen und beheben, bevor sie die Entscheidungsfindung beeinträchtigen.

Aktuelle und sich entwickelnde Datenanforderungen kennenlernen

Herkömmliche Datenqualitätstools und manuelle Prozesse sind bei großen Datenumgebungen oft unzureichend. Stichprobenmethoden oder oberflächliche Prüfungen können zwar offensichtliche Probleme aufdecken, übersehen aber häufig tiefer liegende Anomalien - und decken selten die eigentliche Ursache auf.

Wenn Datenumgebungen an Umfang und Komplexität zunehmen, muss die Datenqualitätsarchitektur mitwachsen. Das bedeutet:

- Überwachung aller Daten, nicht nur von Stichproben.

- Validierung verschiedener Datentypen und -formate.

- Integration von Kontrollen in Datenprozesse und Arbeitsabläufe.

- Unterstützung von offenen Datenformaten.

Unternehmen brauchen Lösungen, die Qualitätskontrollen über große, verteilte Datenmengen hinweg durchführen können. Und diese Lösungen dürfen die Produktionssysteme nicht verlangsamen oder Kostenineffizienzen verursachen. Hier bietet eine moderne Lösung für Beobachtbarkeit einen unvergleichlichen Mehrwert.

Umfassende Beobachtbarkeit als Qualitätsmonitor

Um die leistungsstarke Rolle der Beobachtbarkeit zu verstehen, stellen Sie sich diese als eine Echtzeit-Sensorschicht über den Datenpipelines eines Unternehmens vor. Sie überwacht kontinuierlich den Zustand der Pipeline, erkennt Anomalien und identifiziert die Grundursachen, bevor Probleme in den Downstream gelangen. Im Gegensatz zu statischen Qualitätsprüfungen bietet die Beobachtbarkeit proaktive, stets aktuelle Einblicke in den Zustand der Unternehmensdaten.

Eine moderne Beobachtbarkeit , wie Actian Data Beobachtbarkeit, erhöht den Wert eines Framework:

- Automatisierte Erkennung von Anomalie . Identifizieren Sie Probleme mit der Datenqualität, der Aktualität und den benutzerdefinierten Geschäftsregeln ohne manuelle Eingriffe.

- Analyse der Grundursache. Verstehen, wo und warum Probleme aufgetreten sind, was eine schnellere Lösung ermöglicht.

- Kontinuierliche Überwachung. Sicherstellung der Pipeline-Integrität und Verhinderung von Datenfehlern, die sich auf die Benutzer auswirken.

- Keine blinden Flecken bei der Probenahme. Überwachen Sie 100 % der Daten des Unternehmens, nicht nur eine Teilmenge.

Stichprobenverfahren mögen kosteneffizient erscheinen, aber sie können kritische blinde Flecken in den Daten verursachen. So kann eine Anomalie , die nur 2 % der Datensätze betrifft, vom Datenteam völlig übersehen werden, bis sie ein KI-Modell bricht oder zu unerwarteter Kundenabwanderung führt.

Durch die 100-prozentige Datenabdeckung für eine umfassende und genaue Beobachtbarkeit eliminiert Actian Data Beobachtbarkeit blinde Flecken und die Risiken, die mit Stichprobendaten verbunden sind.

Warum Unternehmen Datenqualität und Beobachtbarkeit brauchen

Unternehmen müssen sich nicht zwischen Datenqualität und Beobachtbarkeitentscheiden Beobachtbarkeitarbeiten zusammen. Wenn sie kombiniert werden, ermöglichen sie:

- Proaktive Vorbeugung, nicht reaktive Problemlösung.

- Schnellere Problemlösung mit Transparenz über den gesamten Lebenszyklus der Daten.

- Größeres Vertrauen durch kontinuierliche Validierung und Transparenz.

- KI-fähige Daten durch Bereitstellung von sauberen, konsistenten Daten.

- Höhere Effizienz durch Verringerung des Zeitaufwands für die Identifizierung von Fehlern.

Die Unfähigkeit, Datenqualität, Herkunft und Zugriffsmuster effektiv zu überwachen, erhöht das Risiko der Nichteinhaltung von Vorschriften. Dies kann zu finanziellen Strafen, Rufschädigung durch Datenfehler und potenziellen Sicherheitsverletzungen führen. Gesetzliche Vorschriften machen Datenqualität nicht nur zu einem geschäftlichen, sondern auch zu einem rechtlichen Gebot.

Die Implementierung solider Datenqualitätspraktiken beginnt mit der Einbettung automatisierter Prüfungen während des gesamten Datenlebenszyklus. Zu den wichtigsten Maßnahmen gehören die Datenvalidierung, um sicherzustellen, dass die Daten den erwarteten Formaten und Bereichen entsprechen, die Erkennung von Duplikaten, um Redundanzen zu beseitigen, und Beständigkeit in allen Systemen.

Mit Hilfe von Kreuzvalidierungsverfahren kann die Datengenauigkeit durch den Vergleich mehrerer Quellen überprüft werden, während die Datenprofilierung Anomalien, fehlende Werte und Ausreißer aufdeckt. Diese Schritte verbessern nicht nur die Zuverlässigkeit, sondern dienen auch als Grundlage für automatisierte Beobachtbarkeit zur Überwachung, Warnung und Aufrechterhaltung des Vertrauens in Unternehmensdaten.

Ohne vollständige Transparenz und aktive Datenüberwachung bleiben Fehler, auch solche, die sensible Daten betreffen, leicht unentdeckt, bis größere Probleme oder Verstöße auftreten. Die Implementierung von Datenqualitätspraktiken, die durch Beobachtbarkeit unterstützt werden, hilft Organisationen:

- Kontinuierliche Validierung der Daten anhand der Richtlinienanforderungen.

- Überwachen Sie Zugang, Frische und Abstammung.

- Automatisieren Sie Warnungen bei Anomalien, Richtlinienverstößen oder fehlenden Daten.

- Verringerung des Risikos von Compliance-Verstößen und Audits.

Durch die Integration von Qualität und Transparenz in die Data Governance können Unternehmen den Anforderungen der Regulierungsbehörden einen Schritt voraus sein.

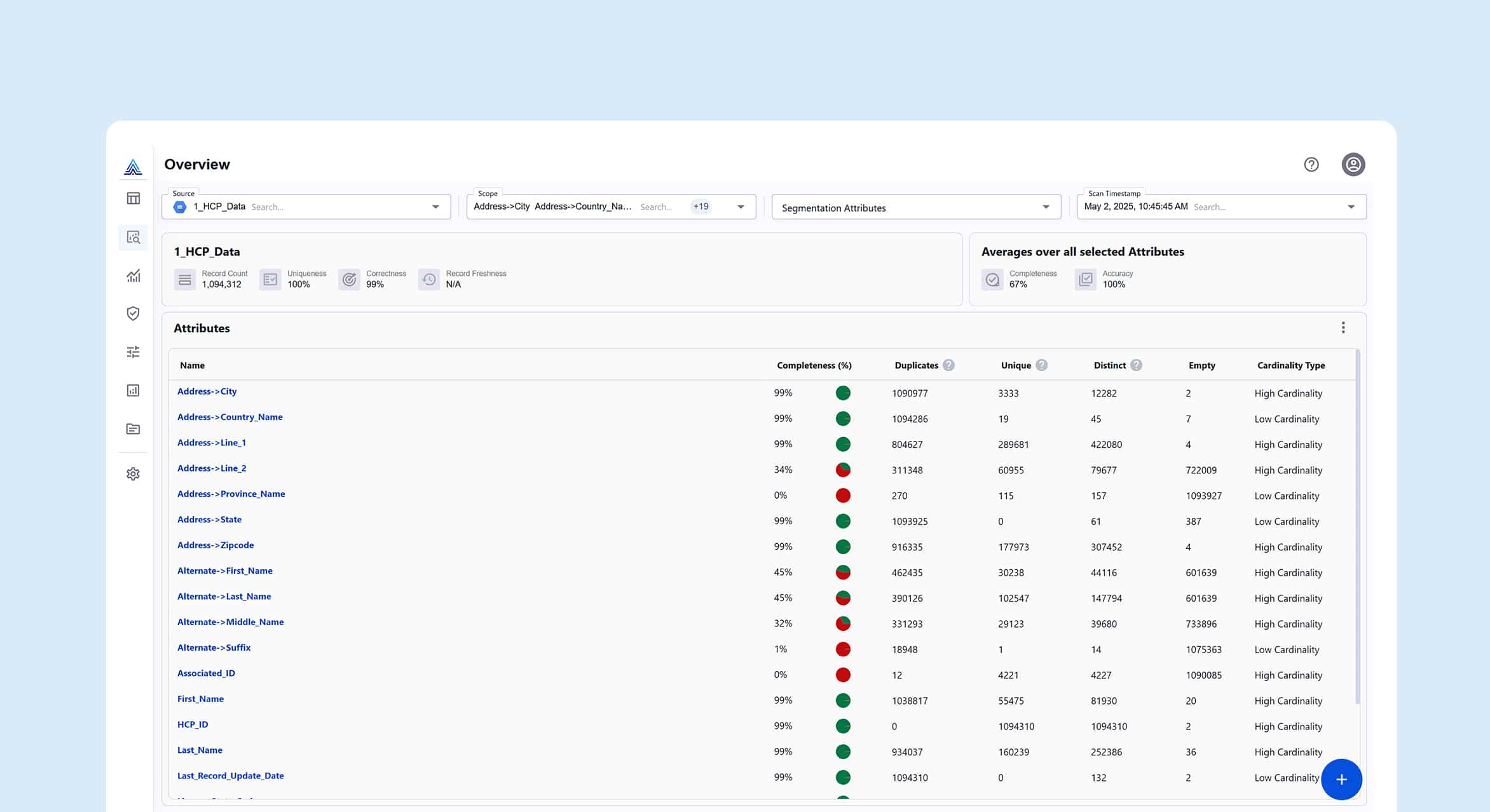

Actian Data Beobachtbarkeit hilft bei der Sicherstellung der Datenzuverlässigkeit

Actian Data Beobachtbarkeit wurde zur Unterstützung großer, verteilter Datenumgebungen entwickelt, in denen Zuverlässigkeit, Skalierbarkeit und Leistung entscheidend sind. Sie bietet vollständige Transparenz über komplexe Pipelines, die Cloud Data Warehouses, Data Lakes und Streaming umfassen.

Mithilfe von KI und Maschinelles Lernen überwacht Actian Data Beobachtbarkeit proaktiv die Datenqualität, erkennt und behebt Anomalien und gleicht Datendiskrepanzen aus. Es ermöglicht Organisationen zu:

- Die Ursachen werden automatisch aufgedeckt.

- Überwachen Sie Datenpipelines mit allen Daten - ohne Stichproben.

- Integrieren Sie die Beobachtbarkeit in bestehende Daten-Workflows.

- Vermeiden Sie die bei anderen Tools üblichen Cloud .

Unternehmen, die es mit der Datenqualität ernst meinen, müssen über statische Qualitätsprüfungen oder Ad-hoc-Dashboards hinaus denken. Sie benötigen Beobachtbarkeit , damit die Daten korrekt und konform sind und für den nächsten use case bereitstehen.

Actian Data Beobachtbarkeit liefert die Fähigkeiten , die benötigt werden, um von einer reaktiven Problemlösung zu einem proaktiven, sicheren Datenmanagement zu gelangen. Erfahren Sie, wie die Lösung Beobachtbarkeit für komplexe Datenarchitekturen bietet.