¿Qué se entiende por ETL Pipeline?

La canalización ETL describe los componentes de una pipeline de données que extrae los datos de origen, los transforma y los carga en un almacén de datos de destino.

¿Por qué utilizar ETL Pipelines?

Las canalizaciones ETL conectan y automatizan las operaciones de extracción, transformación y carga de datos desde las fuentes de datos a un almacén de datos de destino. El atributo clave es que puede gestionarse como un único proceso de extremo a extremo.

¿Qué es un pipeline de données?

Un pipeline de données données es un proceso más amplio que ETL, ya que describe el movimiento general de datos más allá de ETL, como la creación de un lago de datos como repositorio intermedio de datos sin procesar en un almacén de datos de alto rendimiento. Por ejemplo, se puede utilizar un complejo pipeline de données para extraer datos en bruto de muchos sistemas operativos en un lago de datos de puesta en escena. A continuación, se puede utilizar un proceso ETL para transformar y cargar los datos en un almacén de datos para el análisis de datos o para ayudar a entrenar modelos de aprendizaje automático.

¿Cuál es la diferencia entre ETL Pipeline y pipeline de données?

Un proceso ETL puede ser un subconjunto de un pipeline de données más amplio. A diferencia de ETL, las partes de la pipeline de données más amplia pueden consolidar datos sin ninguna transformación en un destino intermedio, como un lago de datos de Hadoop. Por ejemplo, es posible que desee consolidar los registros de mainframe, CRM y sitios web en un lago de datos de almacenamiento en AWS S3. A continuación, utilice un proceso ETL para extraer los datos fusionados del lago de datos de S3 en una serie de transformaciones de datos antes de cargar los datos dignos de análisis en un almacén de datos. Aquí es donde se puede utilizar una herramienta de visualización de datos como Tableau para obtener información empresarial.

Cómo construir un ETL Pipeline en Python

Un canal ETL puede crearse manualmente con Python o utilizarse para invocar operadores de herramientas compatibles con ETL. Los ingenieros de datos suelen utilizar Python para crear canalizaciones ETL. Esta tarea resulta más fácil con herramientas como Luigi y Apache Airflow, de código abierto, para gestionar los flujos de trabajo. Para mover los datos se pueden utilizar operaciones de copia de archivos locales o FTP. Los trabajos de Actian DataConnect pueden invocarse desde Python y utilizarse para perfilar, extraer, transformar y cargar datos.

Pygrametl es un marco ETL de Python de código abierto que puede representar tablas de dimensiones y hechos como objetos de Python. Para crear un canal ETL en Pygrametl, siga estos pasos:

- Importe datos de archivos fuente de formularios a tablas de dimensiones y hechos de Pygrametl.

- Utilice el módulo Python psycopg2 para conectarse al almacén de datos de destino.

- Utilice el módulo SQLSource para Embarquer sentencias SQL SELECT en la fuente Python utilizada para extraer datos.

- Realice la transformación de los datos extraídos fila por fila e inserte los datos transformados en el almacén de datos de destino.

Apache Airflow puede utilizarse para crear flujos de trabajo ETL componiendo un grafo acíclico dirigido (DAG), que expresa las relaciones y dependencias entre las tareas ETL.

Con Airflow, se importan las bibliotecas necesarias y se definen los argumentos por defecto para cada tarea del DAG. La definición del objeto DAG puede incluir parámetros para programar el propietario, el intervalo de ejecución de la gestión de excepciones y los reintentos.

Actian DataConnect es una solución completa y escalable para construir y operar sofisticados pipelines ETL. Puede utilizar su interfaz visual de apuntar y hacer clic para conectar, perfilar, limpiar y asignar fuentes de datos a destinos y crear flujos de trabajo de procesos basados en reglas empresariales. Una vez creados, los procesos ETL pueden reutilizarse. Las canalizaciones ETL pueden ejecutarse, supervisarse y gestionarse independientemente de dónde se desplieguen, ya sea en la nube de Actian, su VPC, centro de datos o un servicio Embarqué .

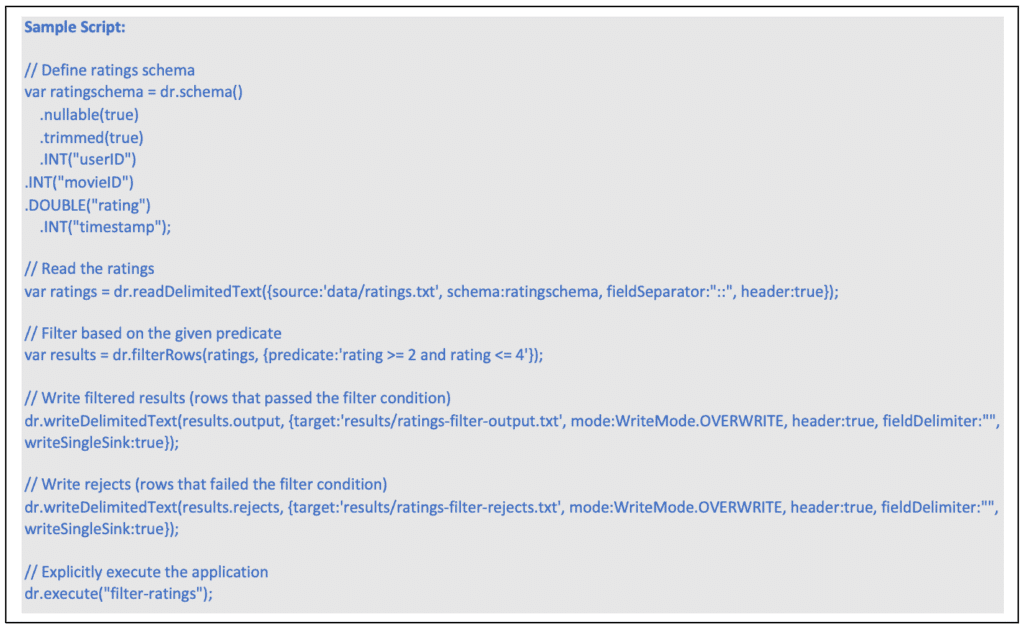

Actian DataFlow puede utilizarse para crear ETL pipelines. DataFlow utiliza un dialecto JavaScript extendido para orquestar una serie de operaciones de manipulación de datos.

A continuación se muestra un ejemplo de aplicación DataFlow para la extracción y transformación de datos. Estos son los pasos a seguir:

- Crear un esquema que defina la estructura de los datos que se van a leer.

- Cree un lector de archivos y defina las propiedades del lector.

- Cree un operador de filtro para los datos leídos, definiendo la condición de filtro como una expresión predicada.

- Maneja los datos que pasan la condición del filtro escribiéndolos en un archivo local.

- Maneja los datos que no cumplen la condición del filtro escribiéndolos en otro archivo local.

- Ejecuta explícitamente la aplicación DataFlow compuesta, proporcionando un nombre que será útil para la depuración y la creación de perfiles.

Actian DataFlow proporciona los siguientes operadores de transformación de datos a nivel de campo:

- Operador DeriveFields para calcular nuevos campos.

- Operador DiscoverEnums para descubrir tipos de datos enumerados.

- Operador MergeFields para fusionar campos.

- Operador RemoveFields para eliminar campos.

- Operador RetainFields para retener campos.

- Operador SelectFields para seleccionar campos.

- Operador RemapFields para renombrar campos.

- Operador SplitField para dividir campos.

- Operador RowsToColumns para convertir filas en columnas (pivote).

- Operador ColumnsToRows para convertir columnas en filas (Unpivot).

Actian DataFlow proporciona cargadores de datos que pueden cargar directamente la Plataforma de Datos Actian como un flujo desde tipos de archivo HDFS como Apache AVRO. Cuando se utiliza la capacidad de carga directa, los datos se transmiten desde el puerto de entrada directamente al motor vectorial. La carga directa puede ejecutarse en paralelo y admite la ejecución dentro de un entorno de clúster como Hadoop. La carga directa puede utilizarse para copiar datos desde HDFS a una instancia de Actian Data Platform. Cuando se ejecuta dentro de un Cluster Hadoop, las operaciones de lectura de los datos, formateo y envío a la Actian Data Platform se ejecutan en un entorno distribuido, aprovechando al máximo los recursos de Hadoop.

¿Cuáles son las ventajas de los ETL Pipelines?

- Proporcione datos precisos y coherentes allí donde su empresa los necesite.

- Los flujos de trabajo ETL pueden gestionarse y ejecutarse como una unidad para reducir los costes de administración.

- Los flujos de trabajo se pueden planificar para ampliarlos a toda la empresa y reducir los tiempos de aprendizaje y los errores.

- Herramientas como DataConnect proporcionan una plataforma de integración de datos de bajo código para desplegar casos de uso más complejos con mayor rapidez.

- Hacer cumplir las normas de calidad de los datos.

- Estandarice las canalizaciones ETL para aprovechar datos más fiables y gobernados.

- Las herramientas de integración de datos como DataConnect ofrecen una completa biblioteca de conectores preconstruidos.

- Los datos se pueden perfilar en una fase temprana de la cadena de producción para mantener una mayor calidad de los datos que permita tomar decisiones posteriores con confianza.

- Programar los movimientos de datos para que coincidan con los requisitos de los conjuntos de datos de origen y los almacenes de datos de destino.

- Las canalizaciones ETL pueden utilizarse como componentes dentro de canalizaciones de datos más amplias.

¿Qué es un ETL Pipeline?

Necesitamos datos de alta calidad en una base de datos para realizar análisis de datos útiles. Para obtener datos sin procesar de más de una fuente y convertirlos en un formato que respalde las decisiones empresariales se utiliza un proceso de extracción, transformación y carga en tres pasos, también conocido como ETL.

Obtenga más información sobre el conjunto de productos y soluciones de Actian y cómo pueden ayudar a su empresa a gestionar los dolores de cabeza de la gestion des données .

Actian y la plataforma de inteligencia de datos

Actian Data Intelligence Platform está diseñada para ayudar a las organizaciones a unificar, gestionar y comprender sus datos en entornos híbridos. Reúne la gestión de metadatos, la gobernanza, el linaje, la supervisión de la calidad y la automatización en una única plataforma. Esto permite a los equipos ver de dónde proceden los datos, cómo se utilizan y si cumplen los requisitos internos y externos.

A través de su interfaz centralizada, Actian permite conocer en tiempo real las estructuras y flujos de datos, lo que facilita la aplicación de políticas, la resolución de problemas y la colaboración entre departamentos. La plataforma también ayuda a conectar los datos con el contexto empresarial, lo que permite a los equipos utilizar los datos de forma más eficaz y responsable. La plataforma de Actian está diseñada para escalar con ecosistemas de datos en evolución, apoyando un uso de datos consistente, inteligente y seguro en toda la empresa. Solicite su demostración personalizada.