Observabilidad de datos de Actian: una plataforma para el futuro

Presentamos Actian Data Observability: datos de calidad, IA fiable

Resumen

Este blog presenta la plataforma de observabilidad de datos de Actian, una solución proactiva basada en inteligencia artificial diseñada para garantizar la fiabilidad de los datos, reducir los costes de la nube y respaldar una inteligencia artificial fiable mediante la supervisión del 100 % de los flujos de datos en tiempo real.

- La supervisión proactiva basada en IA evita los problemas con los datos: La detección de anomalías basada en ML identifica la desviación de esquemas, los valores atípicos y los problemas de frescura en una fase temprana del proceso, antes de que afecten a los sistemas posteriores.

- Costes predecibles con cobertura total de datos: A diferencia de las herramientas basadas en muestreos, Actian procesa cada registro de datos en una capa informática aislada, lo que ofrece una garantía de sobrecarga sin costes y evita los picos de facturación en la nube.

- Arquitectura flexible y abierta para pilas de datos modernas: Compatible con Apache Iceberg y se integra en lagos de datos, lakehouses y almacenes sin dependencia de un proveedor concreto ni degradación del rendimiento en los sistemas de producción.

El coste real de la calidad de datos reactiva

Gartner® estima que "Para 2026, el 50% de las empresas que implementen arquitecturas de datos distribuidas habrán adoptado herramientas de observabilidad de datos para mejorar la visibilidad sobre el estado del panorama de datos, frente a menos del 20% en 2024". Pero la observabilidad de los datos va más allá de la supervisión: es un factor estratégico para generar confianza en los datos y controlar al mismo tiempo los crecientes costes de la calidad de los datos en toda la empresa.

La pila de datos empresariales actual es un mosaico de tecnologías antiguas y nuevas, complejas, fragmentadas y difíciles de gestionar. A medida que los datos fluyen desde la ingesta hasta el almacenamiento, la transformación y el consumo, el riesgo de fallo se multiplica. Los métodos tradicionales ya no pueden seguir el ritmo.

- Los equipos de datos pierden hasta un 40% de su tiempo apagando incendios en lugar de centrarse en el valor estratégico.

- El gasto en la nube sigue aumentando, impulsado por enfoques ineficaces y reactivos en materia de calidad de los datos.

- Las inversiones en IA se quedan cortas cuando los modelos se construyen sobre datos poco fiables o incompletos.

- Los riesgos de cumplimiento aumentan a medida que las organizaciones carecen de la visibilidad necesaria para rastrear y confiar en sus datos.

Los enfoques actuales de la calidad de los datos están anclados en el pasado:

1. El problema del legado

Los métodos tradicionales de calidad de datos han provocado una tormenta perfecta de ineficacia y puntos ciegos. A medida que aumentan los volúmenes de datos, las organizaciones luchan con la creación manual de reglas, lo que obliga a los ingenieros a crear y mantener miles de comprobaciones de calidad en sistemas fragmentados. ¿Cuál es el resultado? Un proceso laborioso que se basa en el muestreo selectivo, dejando sin detectar problemas críticos de calidad de los datos. Al mismo tiempo, la supervisión sigue centrándose en las métricas de la infraestructura, como la CPU y la memoria, en lugar de en la integridad de los propios datos.

El resultado es una visibilidad fragmentada, en la que los problemas de un sistema no pueden relacionarse con los de otro, lo que hace casi imposible el análisis de la causa raíz. Los equipos de datos se ven atrapados en un bucle reactivo, persiguiendo fallos posteriores en lugar de prevenirlos en su origen. Esta lucha constante contra los fallos merma la productividad y, lo que es más importante, la confianza en los datos que sustentan las decisiones empresariales clave.

- Las comprobaciones manuales basadas en reglas no son escalables, por lo que la mayoría de los conjuntos de datos quedan sin supervisión.

- La toma de muestras para reducir costes introduce puntos ciegos que ponen en riesgo decisiones críticas.

- La supervisión de la infraestructura por sí sola ignora lo más importante: los propios datos.

- Las herramientas de supervisión desconectadas impiden a los equipos tener una visión completa de los procesos.

2. La sangría presupuestaria oculta

El cambio a la infraestructura de datos en la nube tenía como objetivo optimizar los costes, pero los enfoques tradicionales de observabilidad han dado lugar a lo contrario. A medida que los equipos amplían la supervisión de su pila de datos, las consultas que requieren un uso intensivo de recursos informáticos provocan picos de costes impredecibles en los sistemas de producción. Con una transparencia de costes limitada, es casi imposible realizar un seguimiento de los gastos o planificar los presupuestos de forma eficaz. A medida que los datos aumentan, también lo hacen los costes, y rápidamente. Las empresas se enfrentan a una difícil elección: reducir la supervisión y arriesgarse a que no se detecten problemas, o mantener la cobertura y justificar el aumento del gasto en la nube ante los responsables financieros. Esta imprevisibilidad de los costes es ahora una barrera clave para la adopción de la observabilidad de datos a nivel empresarial.

- Un procesamiento ineficaz genera costes excesivos de computación y almacenamiento.

- La escasa transparencia de los costes dificulta la optimización y la presupuestación.

- El aumento de los volúmenes de datos magnifica los costes, por lo que la escalabilidad es una preocupación creciente.

3. El cuello de botella de la arquitectura

La mayoría de las soluciones para la observabilidad de los datos crean ataduras arquitectónicas que limitan gravemente la flexibilidad técnica y la escalabilidad de una organización. Estas soluciones suelen estar diseñadas como componentes estrechamente integrados que se incrustan profundamente en plataformas en la nube o tecnologías de datos específicas, lo que obliga a las organizaciones a asumir compromisos a largo plazo con los proveedores y limita las opciones de innovación futuras.

Cuando las comprobaciones de calidad se ejecutan directamente en los sistemas de producción, compiten por recursos críticos con las operaciones principales de la empresa, lo que a menudo provoca una degradación significativa del rendimiento durante los periodos punta, precisamente cuando la fiabilidad es más importante. Las limitaciones arquitectónicas obligan a los equipos de datos a desarrollar complejas soluciones de ingeniería personalizadas para mantener el rendimiento, lo que genera deuda técnica y consume valiosos recursos de ingeniería.

- Soluciones estrechamente vinculadas que te encierran en plataformas específicas.

- Disminución del rendimiento al ejecutar comprobaciones en sistemas de producción.

- Utilización ineficiente de los recursos que requiere ingeniería a medida.

Actian aporta un nuevo enfoque a la fiabilidad de los datos

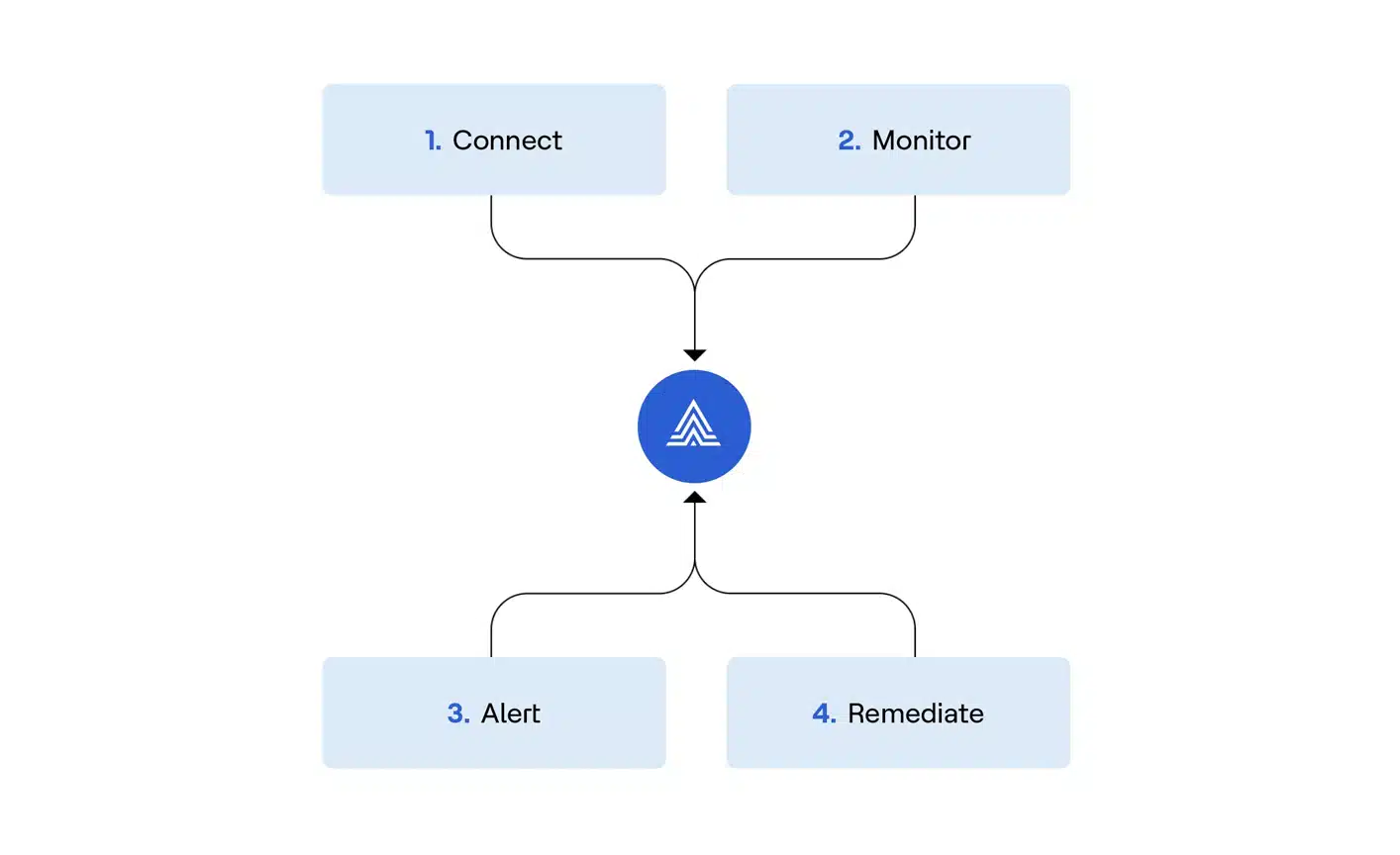

Actian Data Observability representa un cambio fundamental de la extinción reactiva de incendios a la fiabilidad proactiva de los datos. Así es como somos diferentes:

1. Proactivo, no reactivo

Método tradicional: Descubrir problemas de calidad de los datos después de que hayan afectado a las decisiones empresariales.

Método de Actian:Detección de anomalías basada en inteligencia artificial que detecta los problemas en una fase temprana del proceso utilizando información obtenida mediante aprendizaje automático.

2. Economía previsible de la nube

Método tradicional: Facturas de nube impredecibles que aumentan con el volumen de datos.

Método de Actian: Garantía de ausencia de aumentos de costes gracias a una arquitectura eficiente que optimiza el consumo de recursos.

3. Cobertura completa, sin muestreo

Método tradicional: Muestreo de datos para ahorrar costes, lo que crea puntos ciegos críticos.

Método de Actian: Cobertura del 100 % de los datos sin concesiones gracias al procesamiento inteligente.

4. Libertad arquitectónica

Método tradicional: Dependencia de un proveedor con opciones de integración limitadas.

Método de Actian: Arquitectura abierta con compatibilidad nativa con Apache Iceberg e integración perfecta en pilas de datos modernas.

Impacto en el mundo real

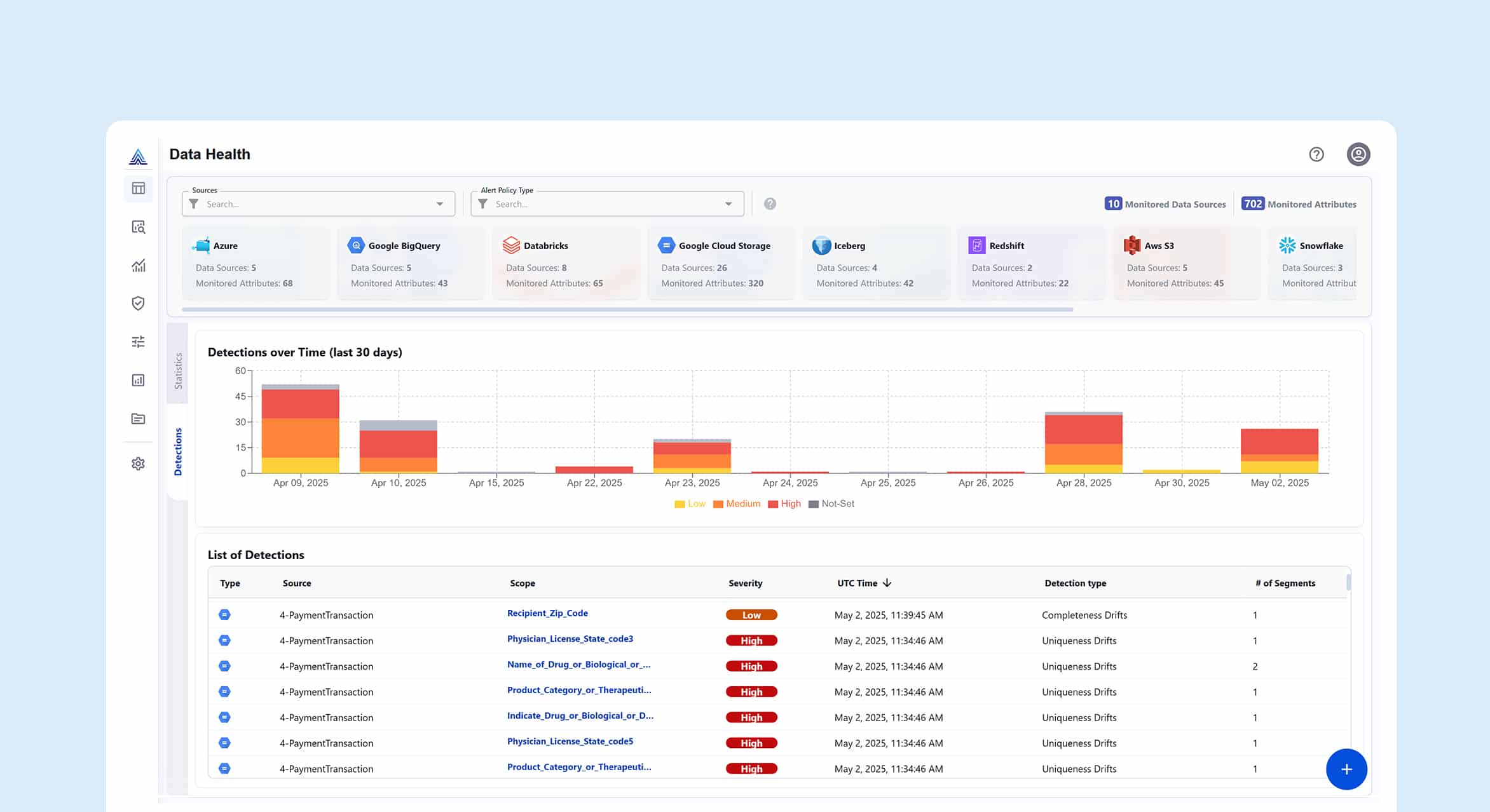

Echemos un vistazo rápido a cómo funciona la plataforma de observabilidad de datos de Actian en el día a día de una empresa u organización.

Caso práctico 1: Eficacia de la canalización de datos con "Shift-Left".

Transforme sus operaciones de datos detectando los problemas en su origen:

- Implemente comprobaciones DQ exhaustivas en las fases de ingestión, transformación y origen.

- Integración con flujos de trabajo CI/CD para canalizaciones de datos.

- Reduzca los costes de reelaboración y acelere la obtención de valor.

Caso práctico 2: Supervisión del ciclo de vida de GenAI

Asegúrese de que sus iniciativas de IA aportan valor empresarial:

- Validar la calidad de los datos de formación y las fuentes de conocimiento RAG.

- Vigilar las alucinaciones, los sesgos y la desviación del rendimiento.

- Realice un seguimiento de las métricas operativas del modelo en tiempo real.

Caso práctico 3: Análisis de autoservicio seguro

Permita a su organización explorar los datos con confianza:

- Incorpore indicadores de salud de datos en tiempo real en catálogos y herramientas de BI.

- Supervise los patrones de uso de los conjuntos de datos de forma proactiva.

- Genere confianza mediante la transparencia y la validación.

La ventaja de Actian: Cinco factores diferenciales que importan

- Sin muestreo de datos: Cobertura de datos del 100% para una observabilidad exhaustiva.

- Sin garantía de sobrecoste de la nube: Economía predecible a escala.

- Arquitectura segura de copia cero: Acceda a los metadatos sin costosas copias de datos.

- Cargas de trabajo de IA escalables: Capacidades de ML diseñadas a escala empresarial.

- Compatibilidad nativa con Apache Iceberg: Observabilidad sin precedentes para formatos de tabla modernos.

Tome el control de sus datos con la observabilidad de datos de Actian.

Realice una visita guiada por el producto y comprenda mejor cómo transformar sus operaciones de datos del caos reactivo al control proactivo.